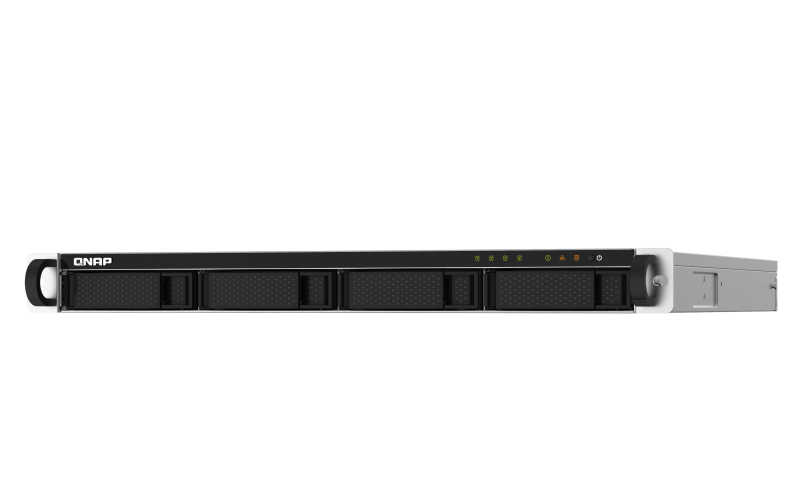

クアッドコアの高性能および最大16GBのRAM

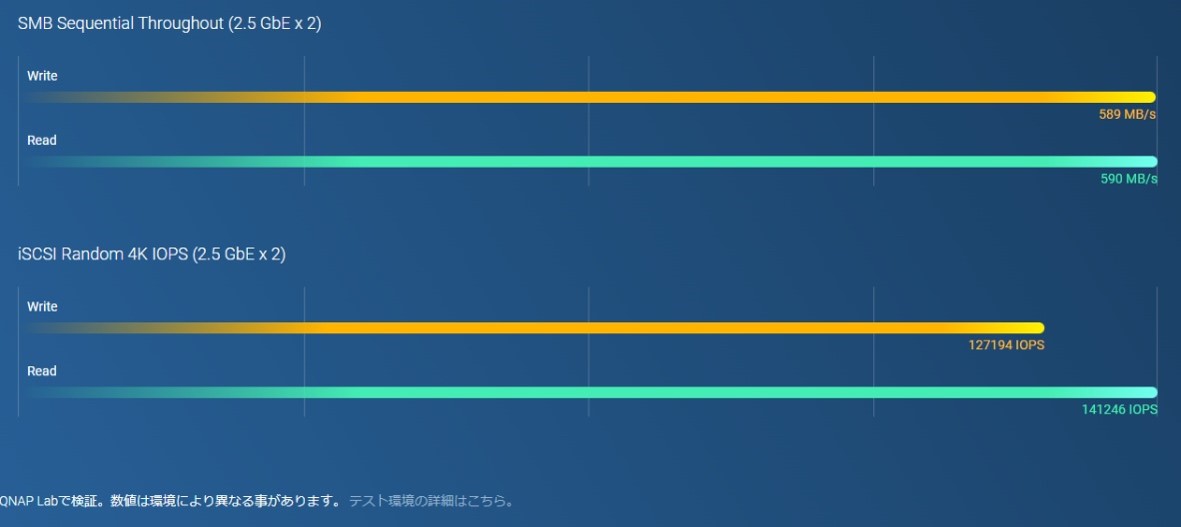

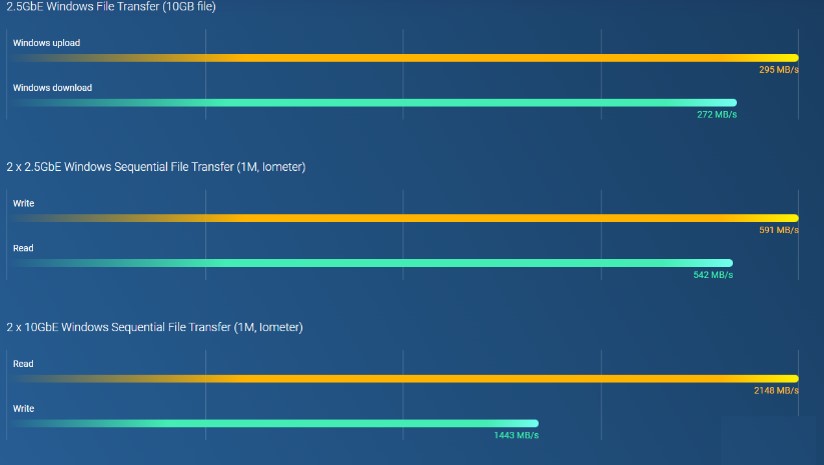

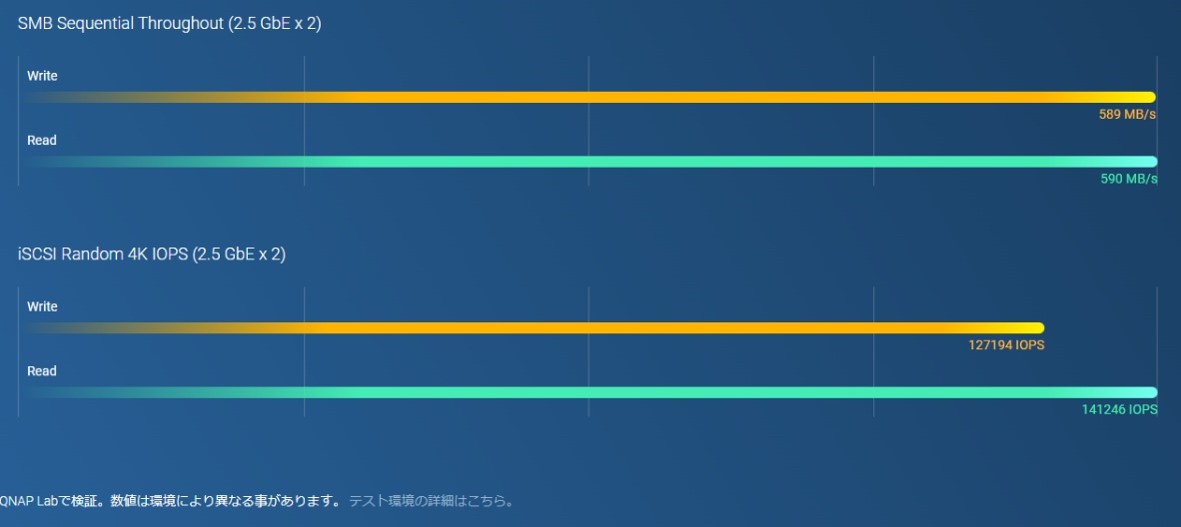

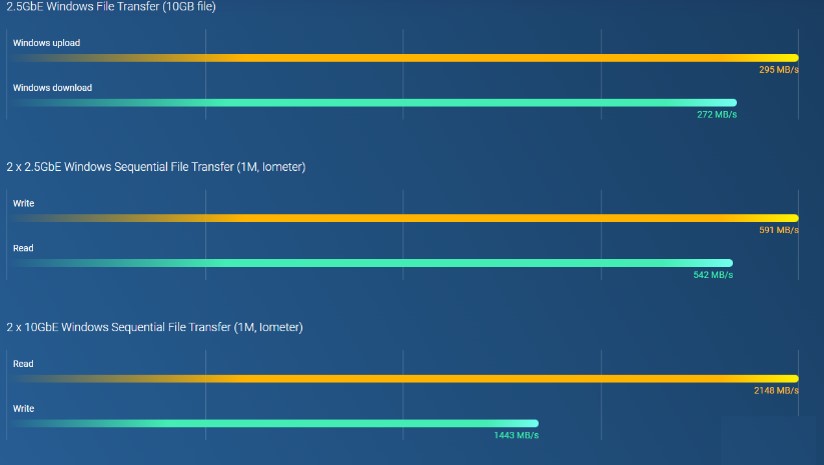

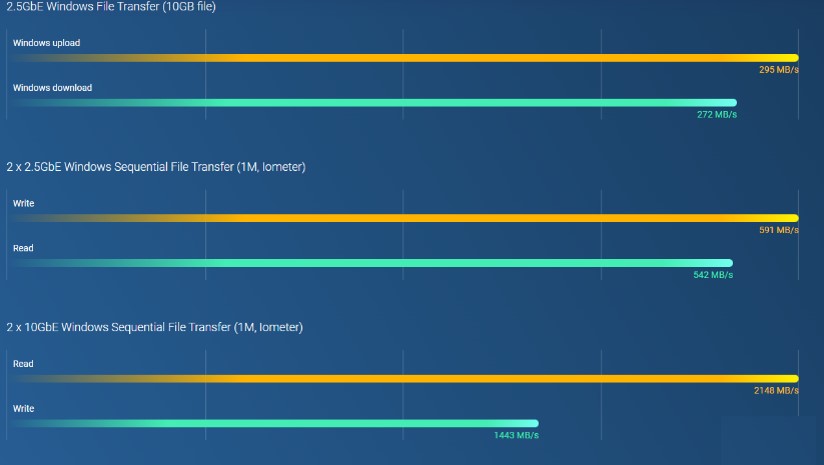

2.5GbEで、大容量ファイル転送とビデオ編集を効率化

TPUおよびPCIe拡張による、AIベース画像認識およびキャッシュのアクセラレーション

最大5年までのハードウェア保証延長

Intel® Celeron® J3455クアッドコア1.5Ghzプロセッサ 、最大8GB DDR3L RAMを搭載し、SMB/CIFS、NFS、AFPプロトコルに対応しているため、

Windows、Mac、Linux/UNIXネットワークでファイルを共有することができます。少人数でデータ共有を行う際に最適です。

高い機密性とパフォーマンス

シームレスな容量拡張

高信頼性ストレージWD Redシリーズ搭載

Intel® Celeron® J3455クアッドコア1.5Ghzプロセッサ 、最大8GB DDR3L RAMを搭載し、SMB/CIFS、NFS、AFPプロトコルに対応しているため、

Windows、Mac、Linux/UNIXネットワークでファイルを共有することができます。少人数でデータ共有を行う際に最適です。

高い機密性とパフォーマンス

シームレスな容量拡張

高信頼性ストレージWD Redシリーズ搭載

高性能AMD Ryzen™プロセッサ

* * 非ECCメモリとECCメモリの同時使用はできないため、ECCメモリを使用するには標準装備のメモリを取り外す必要があります。

お財布に優しい2.5GbEスイッチにより、ネットワークを変革します

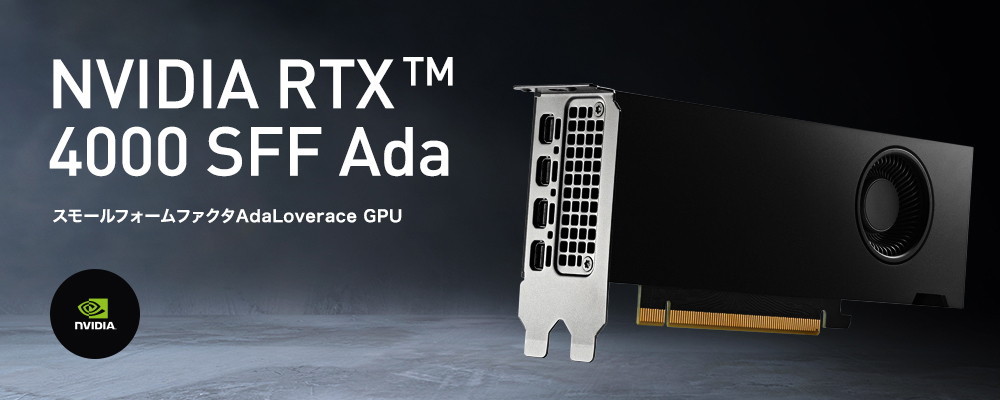

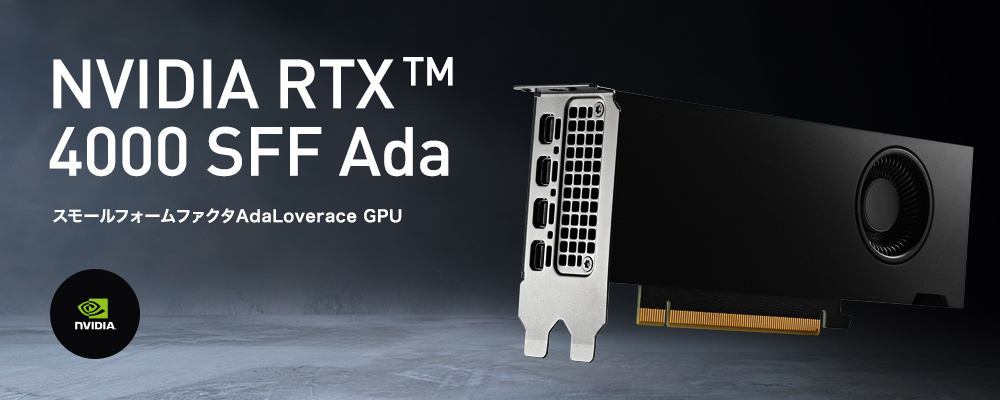

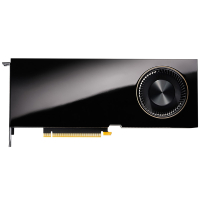

GPUアクセラレーションコンピューティングのためにグラフィックカードを取り付ける

最大5年までのハードウェア保証延長

より高いパフォーマンス x より速い処理能力

マルチポイントのファイルバックアップ、アクセス、および同期

頼れるサービスのための冗長性電源

必要な時にはいつでも、柔軟にストレージ容量を拡張します

QNAPで高速ネットワークを構築

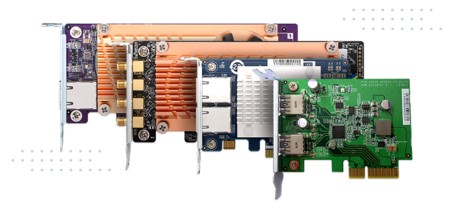

PCIeカードでNASの機能性を拡張

最適化されたストレージ効率のためのSSDキャッシングおよび自動階層化

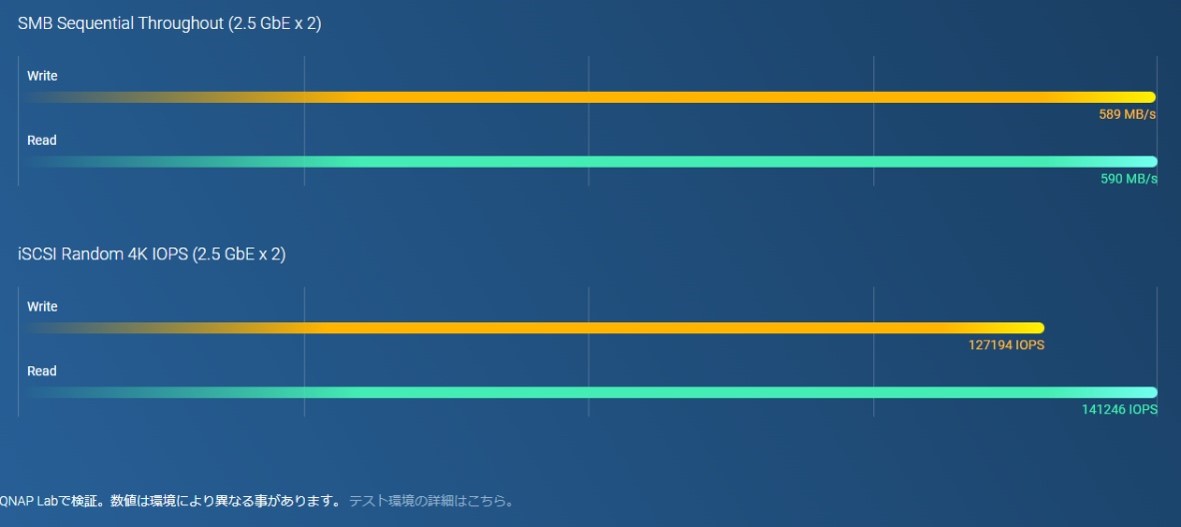

簡単で安全なファイル管理

QNAPで高速ネットワークを構築

PCIeカードでNASの機能性を拡張

最適化されたストレージ効率のためのSSDキャッシングおよび自動階層化

簡単で安全なファイル管理

クアッドコアプロセッサ、最大バースト2.9 GHz、最大8 GBまで増設可能なメモリ

SSDキャッシュおよび自動階層化によるストレージ効率の最適化

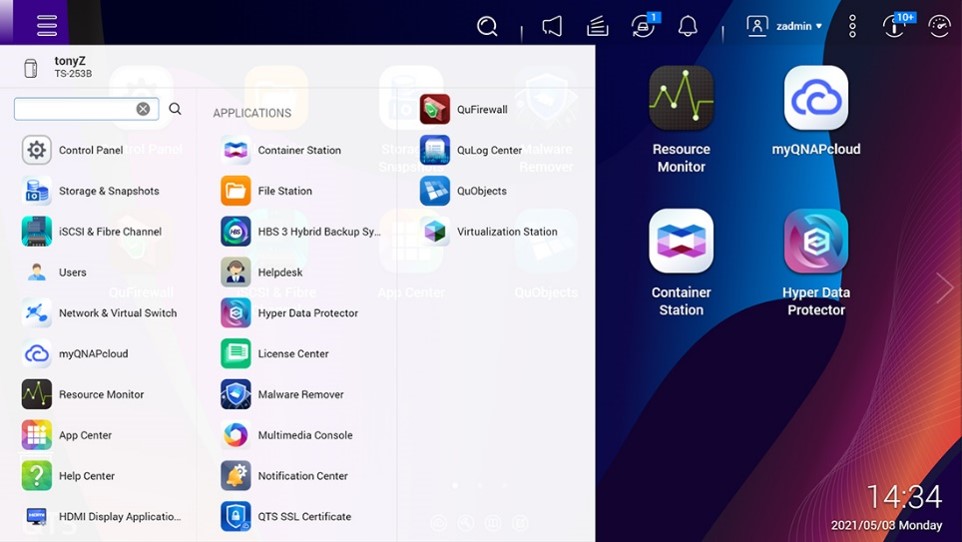

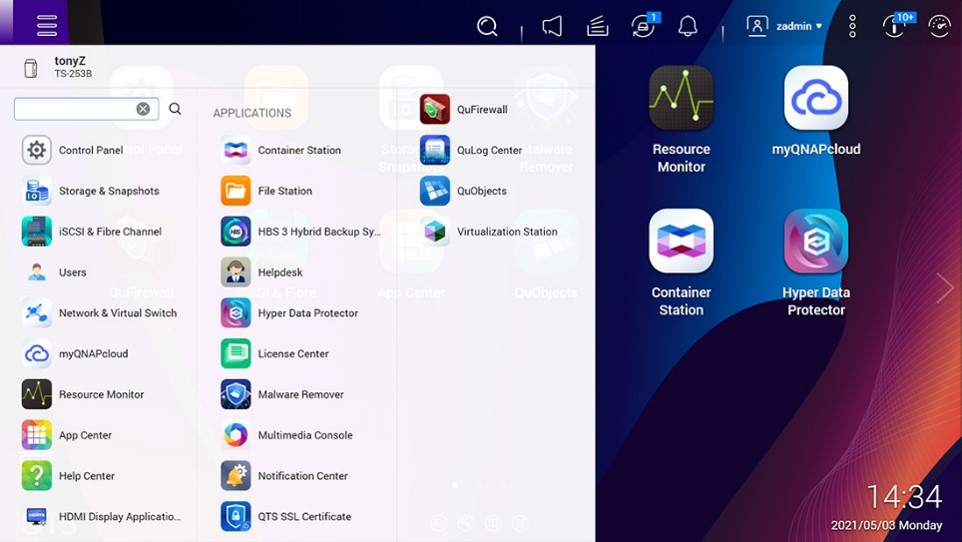

QTS 5、高速でスムーズかつ使いやすい!

包括的なセキュリティおよび権限設定

AMD Ryzen™および最大64GBのRAMによる絶対的なパフォーマンス

マル2.5GbEネットワーキングにアップグレード

SSDキャッシングによるIOPSパフォーマンスの高速化

必要な時にはいつでも、柔軟にストレージ容量を拡張します

クアッドコアプロセッサ、最大バースト2.9 GHz、最大8 GBまで増設可能なメモリ

SSDキャッシュおよび自動階層化によるストレージ効率の最適化

QTS 5、高速でスムーズかつ使いやすい!

包括的なセキュリティおよび権限設定

クアッドコアプロセッサ、最大バースト2.9 GHz、最大8 GBまで増設可能なメモリ

SSDキャッシュおよび自動階層化によるストレージ効率の最適化

QTS 5、高速でスムーズかつ使いやすい!

包括的なセキュリティおよび権限設定

AMD Ryzen™および最大64GBのRAMによる絶対的なパフォーマンス

マル2.5GbEネットワーキングにアップグレード

SSDキャッシングによるIOPSパフォーマンスの高速化

必要な時にはいつでも、柔軟にストレージ容量を拡張します

AMD Ryzen™および最大64GBのRAMによる絶対的なパフォーマンス

マル2.5GbEネットワーキングにアップグレード

SSDキャッシングによるIOPSパフォーマンスの高速化

必要な時にはいつでも、柔軟にストレージ容量を拡張します

高性能AMD Ryzen™プロセッサ

* * 非ECCメモリとECCメモリの同時使用はできないため、ECCメモリを使用するには標準装備のメモリを取り外す必要があります。

お財布に優しい2.5GbEスイッチにより、ネットワークを変革します

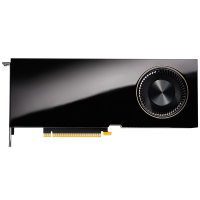

GPUアクセラレーションコンピューティングのためにグラフィックカードを取り付ける

最大5年までのハードウェア保証延長

高性能AMD Ryzen™プロセッサ

* * 非ECCメモリとECCメモリの同時使用はできないため、ECCメモリを使用するには標準装備のメモリを取り外す必要があります。

お財布に優しい2.5GbEスイッチにより、ネットワークを変革します

GPUアクセラレーションコンピューティングのためにグラフィックカードを取り付ける

最大5年までのハードウェア保証延長

ハイエンドビデオカードも搭載可能で、様々な用途に答えるコストパフォーマンスにすぐれたマルチなエントリーモデルです。

第12世代インテル® Core™プロセッサ”Alder Lake-S”を標準搭載

第12世代インテル® Core™ プロセッサー(コードネーム:Alder Lake-S)はGolden Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大16コアを搭載しています。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作、仮想現実(VR)などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

Intel® B660チップセット

第12世代Intel®プロセッサーの潜在能力を最大限に引き出すために、熟練した技術を駆使して設計されています。

B660マザーボードには、システムのあらゆる側面を調整するための柔軟なツールが搭載されており、あなたの作業方法にぴったり合ったパフォーマンス調整を可能にし、生産性を最大限に高めます。

最大128GBまで搭載可能な広帯域3200MHz DDR4メモリー

マザーボード上には合計4つのメモリスロットを確保しており最大で128GBのメモリ空間を広帯域で実現します。

DisprayPortを搭載

また、PCIe4.0/3.0 x16対応バスにも対応。

ハイエンドビデオカードも選択可能です。

ハイエンドビデオカードも搭載可能で、様々な用途に答えるコストパフォーマンスにすぐれたマルチなエントリーモデルです。

第12世代インテル® Core™プロセッサ”Alder Lake-S”を標準搭載

第12世代インテル® Core™ プロセッサー(コードネーム:Alder Lake-S)はGolden Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大16コアを搭載しています。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作、仮想現実(VR)などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

Intel® B660チップセット

第12世代Intel®プロセッサーの潜在能力を最大限に引き出すために、熟練した技術を駆使して設計されています。

B660マザーボードには、システムのあらゆる側面を調整するための柔軟なツールが搭載されており、あなたの作業方法にぴったり合ったパフォーマンス調整を可能にし、生産性を最大限に高めます。

最大128GBまで搭載可能な広帯域3200MHz DDR4メモリー

マザーボード上には合計4つのメモリスロットを確保しており最大で128GBのメモリ空間を広帯域で実現します。

DisprayPortを搭載

また、PCIe4.0/3.0 x16対応バスにも対応。

ハイエンドビデオカードも選択可能です。

前世代 Alder Lake-Sからクロック数の向上に加え、キャッシュメモリの容量増とE-COREのコア数の増加で大幅な性能向上を実現しております。Raptor Cove 高性能CPUコア(P-CORE)とGracemont高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なコンテンツのパフォーマンス向上をはじめ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

第13世代インテル® Core™プロセッサー “Raptor Lake-S”搭載

効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作、仮想現実(VR)などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

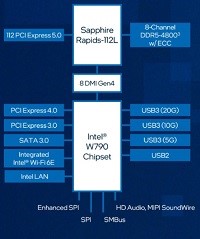

Intel® B760チップセット

PCI-Express 5.0 に対応

最大5基のストレージベイを搭載

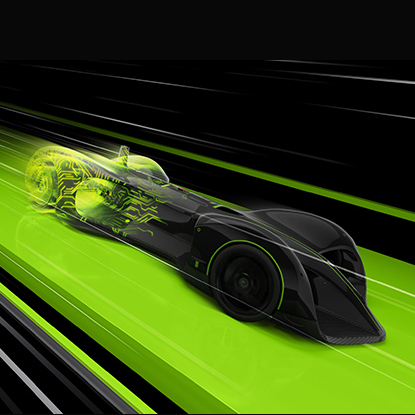

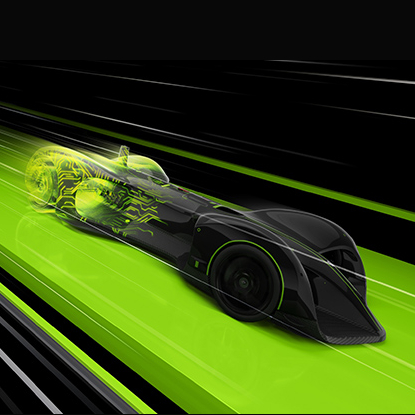

最新インテル第14世代 コードネーム Raptor Lake-S Refresh(ラプターレイクリフレッシュ)を搭載したデスクサイドGPUワークステーションです。Pコア+Eコア合計24コアで 最大Thermal Velocity Boost 6.0GHz動作の「Inte® Core™ i9-14900KF」をはじめとした」ラインナップによりCPU性能を大幅に向上させています。また、プラットフォームでは PCIe 5.0をサポート 、最大16のPCI Express 5.0レーンにより、RTX 4090 をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

※注意:このモデルはCPU 仕様によりPCIe Lanes数は20までとなり、2枚のGPUを搭載可能ですが、1枚目はx16転送レート(理論値 256.0Gbps)、2枚目はx4転送レート(理論値 64.0Gbps)での動作となります。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

GPU を最適な環境で動作

https://developer.nvidia.com/ja-jp/blog/cuda-toolkit-12-0-released-for-general-availability/

安定度抜群の高効率電源

前世代 Alder Lake-Sからクロック数の向上に加え、キャッシュメモリの容量増とE-COREのコア数の増加で大幅な性能向上を実現しております。Raptor Cove 高性能CPUコア(P-CORE)とGracemont高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なコンテンツのパフォーマンス向上をはじめ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

第13世代インテル® Core™プロセッサー “Raptor Lake-S”搭載

効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作、仮想現実(VR)などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

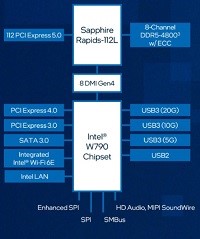

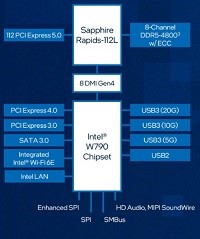

Intel® Z790チップセット

PCI-Express 5.0 に対応

最大5基のストレージベイを搭載

エアーフローによる冷却と静音のバランスを考え誕生した空冷システムを採用しております。厳選されたパーツの組み合わせにより、高性能に加え、格段の冷却性能と静音性を実現しました。静音性を追求したIntel Z790チップセット搭載DDR5対応タワー型モデルになります。システム騒音値はアイドル時で18.8db、高負荷時で30.1dbと静音性を保っております。CPUは第14世代 Raptor Lake Refreshを搭載しており、Raptor Cove 高性能CPUコア(P-CORE)とGracemont高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載しております。前世代のパフォーマンスを継承、改良を加えさらなる性能の向上を実現、効率的なコアの使用により没入感のある高精細なコンテンツのパフォーマンス向上をはじめ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

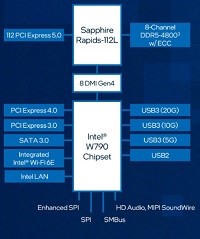

Intel® B760チップセット

CPUクーラーに「こだわり」の空冷システムメーカー Noctua搭載

負荷 40% 以下でのセミファンレスモード& ハイブリッドスイッチ搭載 80 PLUS Gold認証の静音電源

高効率を実現できるハーフブリッジ形 LLC方式 DC/DCコンバータに、日本製コンデンサを100% 使用し、プロフェッショナルグレードの品質を実現しつつ、本体のハイブリッドスイッチで ON/OFFを切替可能なセミファンレスモードを搭載することにより、静音性と冷却性にも優れ た 80 PLUS Gold 認証 850W電源です。

ノイズを最小限に抑え、冷却効率に優れたSILENCIOデザイン

ハイエンドビデオカードも搭載可能で、様々な用途に答えるコストパフォーマンスにすぐれたマルチなエントリーモデルです。

第12世代インテル® Core™プロセッサ”Alder Lake-S”を標準搭載

第12世代インテル® Core™ プロセッサー(コードネーム:Alder Lake-S)はGolden Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大16コアを搭載しています。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作、仮想現実(VR)などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

Intel® B660チップセット

第12世代Intel®プロセッサーの潜在能力を最大限に引き出すために、熟練した技術を駆使して設計されています。

B660マザーボードには、システムのあらゆる側面を調整するための柔軟なツールが搭載されており、あなたの作業方法にぴったり合ったパフォーマンス調整を可能にし、生産性を最大限に高めます。

最大128GBまで搭載可能な広帯域3200MHz DDR4メモリー

マザーボード上には合計4つのメモリスロットを確保しており最大で128GBのメモリ空間を広帯域で実現します。

DisprayPortを搭載

また、PCIe4.0/3.0 x16対応バスにも対応。

ハイエンドビデオカードも選択可能です。

エアーフローによる冷却と静音のバランスを考え誕生した空冷システムを採用しております。厳選されたパーツの組み合わせにより、高性能に加え、格段の冷却性能と静音性を実現しました。静音性を追求したIntel Z790チップセット搭載DDR5対応タワー型モデルになります。システム騒音値はアイドル時で18.8db、高負荷時で30.1dbと静音性を保っております。CPUは第14世代 Raptor Lake Refreshを搭載しており、Raptor Cove 高性能CPUコア(P-CORE)とGracemont高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載しております。前世代のパフォーマンスを継承、改良を加えさらなる性能の向上を実現、効率的なコアの使用により没入感のある高精細なコンテンツのパフォーマンス向上をはじめ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

Intel® Z790チップセット

CPUクーラーに「こだわり」の空冷システムメーカー Noctua搭載

負荷 40% 以下でのセミファンレスモード& ハイブリッドスイッチ搭載 80 PLUS Gold認証の静音電源

高効率を実現できるハーフブリッジ形 LLC方式 DC/DCコンバータに、日本製コンデンサを100% 使用し、プロフェッショナルグレードの品質を実現しつつ、本体のハイブリッドスイッチで ON/OFFを切替可能なセミファンレスモードを搭載することにより、静音性と冷却性にも優れ た 80 PLUS Gold 認証 850W電源です。

ノイズを最小限に抑え、冷却効率に優れたSILENCIOデザイン

エアーフローによる冷却と静音のバランスを考え誕生した空冷システムを採用しております。厳選されたパーツの組み合わせにより、高性能に加え、格段の冷却性能と静音性を実現しました。静音性を追求したIntel Z790チップセット搭載DDR5対応タワー型モデルになります。システム騒音値はアイドル時で18.8db、高負荷時で30.1dbと静音性を保っております。CPUは第14世代 Raptor Lake Refreshを搭載しており、Raptor Cove 高性能CPUコア(P-CORE)とGracemont高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載しております。前世代のパフォーマンスを継承、改良を加えさらなる性能の向上を実現、効率的なコアの使用により没入感のある高精細なコンテンツのパフォーマンス向上をはじめ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

Intel® Z790チップセット

CPUクーラーに「こだわり」の空冷システムメーカー Noctua搭載

負荷 40% 以下でのセミファンレスモード& ハイブリッドスイッチ搭載 80 PLUS Gold認証の静音電源

高効率を実現できるハーフブリッジ形 LLC方式 DC/DCコンバータに、日本製コンデンサを100% 使用し、プロフェッショナルグレードの品質を実現しつつ、本体のハイブリッドスイッチで ON/OFFを切替可能なセミファンレスモードを搭載することにより、静音性と冷却性にも優れ た 80 PLUS Gold 認証 850W電源です。

ノイズを最小限に抑え、冷却効率に優れたSILENCIOデザイン

前世代 Alder Lake-Sからクロック数の向上に加え、キャッシュメモリの容量増とE-COREのコア数の増加で大幅な性能向上を実現しております。Raptor Cove 高性能CPUコア(P-CORE)とGracemont高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なコンテンツのパフォーマンス向上をはじめ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

第13世代インテル® Core™プロセッサー “Raptor Lake-S”搭載

効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作、仮想現実(VR)などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

Intel® Z790チップセット

PCI-Express 5.0 に対応

最大5基のストレージベイを搭載

最新インテル第14世代 コードネーム Raptor Lake-S Refresh(ラプターレイクリフレッシュ)を搭載したデスクサイドGPUワークステーションです。Pコア+Eコア合計24コアで 最大Thermal Velocity Boost 6.0GHz動作の「Inte® Core™ i9-14900KF」をはじめとした」ラインナップによりCPU性能を大幅に向上させています。また、プラットフォームでは PCIe 5.0をサポート 、最大16のPCI Express 5.0レーンにより、RTX 4090 をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

※注意:このモデルはCPU 仕様によりPCIe Lanes数は20までとなり、2枚のGPUを搭載可能ですが、1枚目はx16転送レート(理論値 256.0Gbps)、2枚目はx4転送レート(理論値 64.0Gbps)での動作となります。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

GPU を最適な環境で動作

https://developer.nvidia.com/ja-jp/blog/cuda-toolkit-12-0-released-for-general-availability/

安定度抜群の高効率電源

ジーデップ・アドバンスではLLMなどの複雑で大規模なAI学習でも利用いただける、最新のAda LovelaceアーキテクチャGPUを搭載したモデルをご用意いたしました。

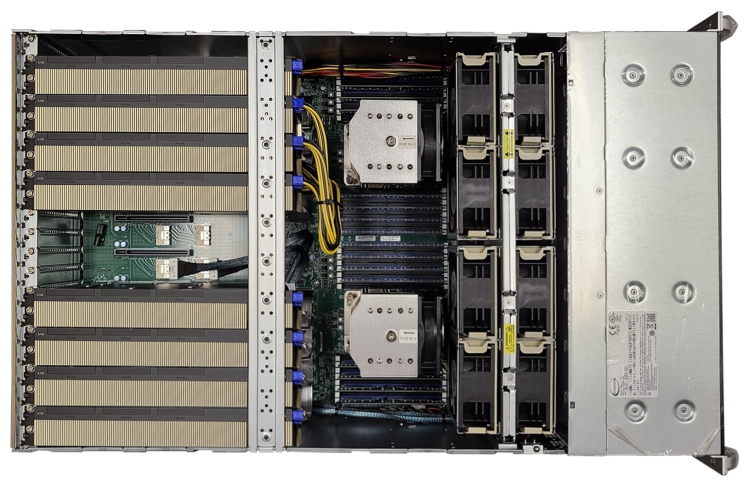

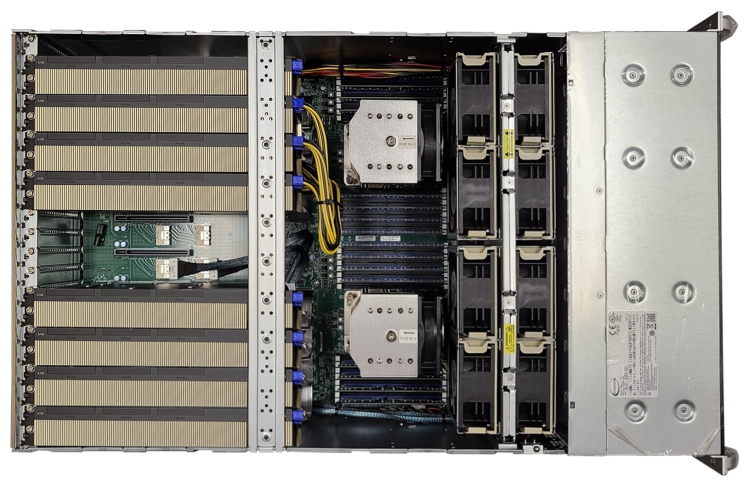

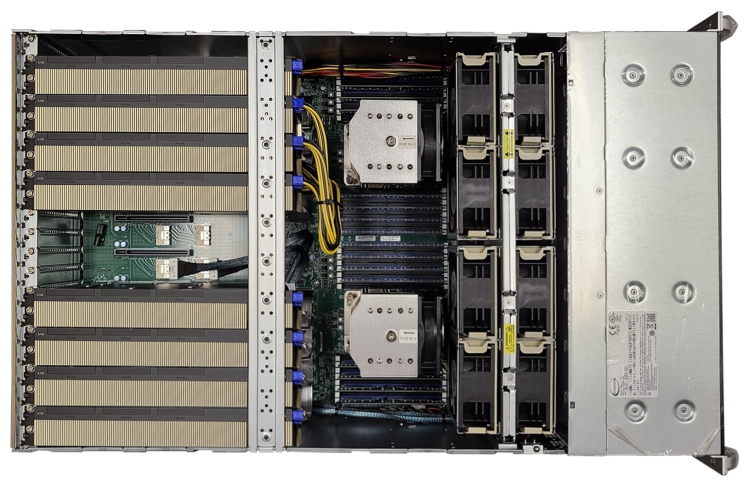

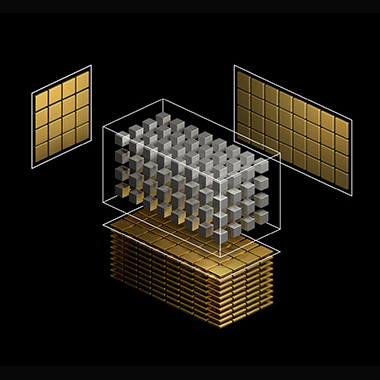

2基の電源ユニットが最大4基のハイエンドGPUを安定動作させ、144 レーンのPCI Express5.0により理論値224GT/秒の広帯域でGPU間の通信が可能となり、計算のボトルネックを大きく解消できます。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でもハイエンドマルチGPUが利用いただけます。

※更にオプションのラックマウントレールを装着することにより、デスクサイドだけでなく19インチラックへの搭載も可能となっています。

最先端の5nm「Zen 4」アーキテクチャをベースに構築されたAMD Ryzen™ Threadripper™ PRO シリーズ プロセッサーの採用により、シングルソケットで最大96個のメニーコア環境を実現しています。最大5.1GHzのCPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、AMDメモリー・ガード1によるリアルタイムの完全なシステム・メモリー暗号化機能を備えます。

また、フロントアクセスが可能な2基の3.5インチHDDホットスワップベイと、2.5インチSSDが最大4基内蔵でき、高いストレージ拡張性を実現します。

「G-Works 4.0」をインストール

DeepLearningSTATION シリーズには 深層学習研究において高効率で高いパフォーマンスを発揮できるよう Linux(Ubuntu)オペレーティングシステムと、当社独自のAI開発 ライブラリー群 「G-Works4.0」をインストールしてあります。さらに、OpenAI社も利用しているMLopsプラットフォームである「W&B」をプレインストールしており、最新のGPU Compute Capability 9.0に適合し最適に動作するようチューニングされています。

ジーデップ・アドバンスのAIワークステーションは、AI開発ユーザーが面倒な環境設定などを行うことなく、届いたその日から利用できる最適なAI開発環境がインストールされているターンキーAI開発用システムとなります。

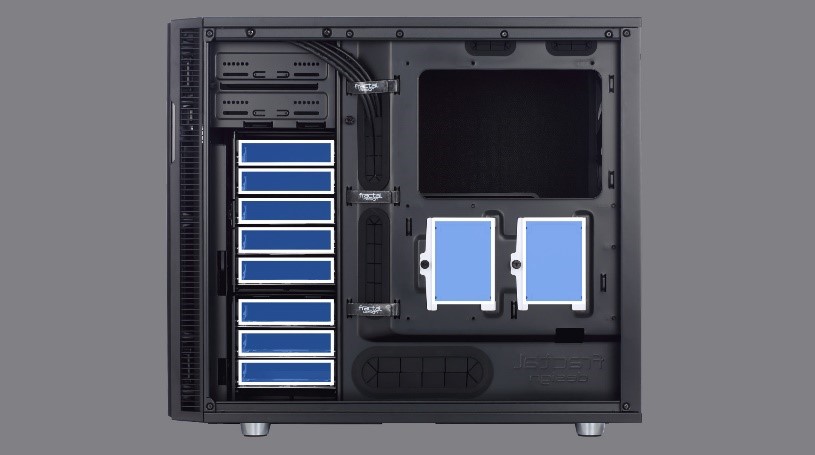

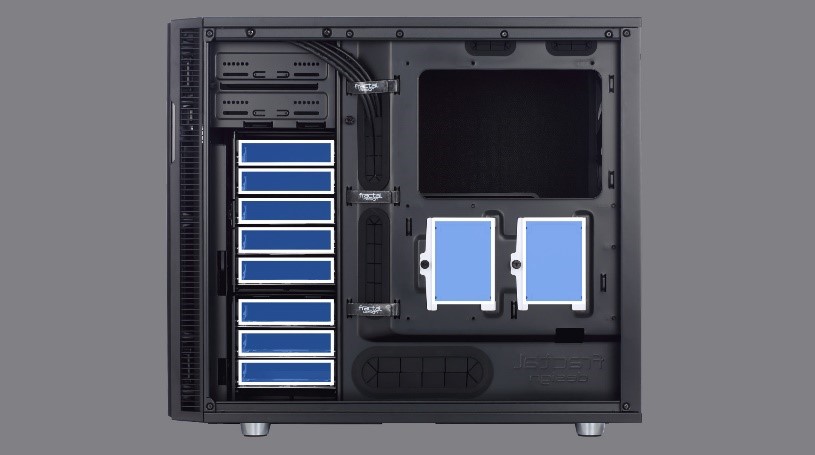

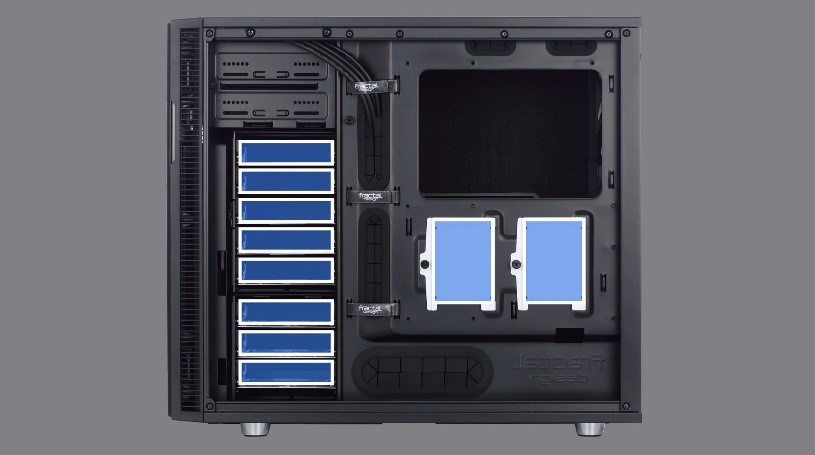

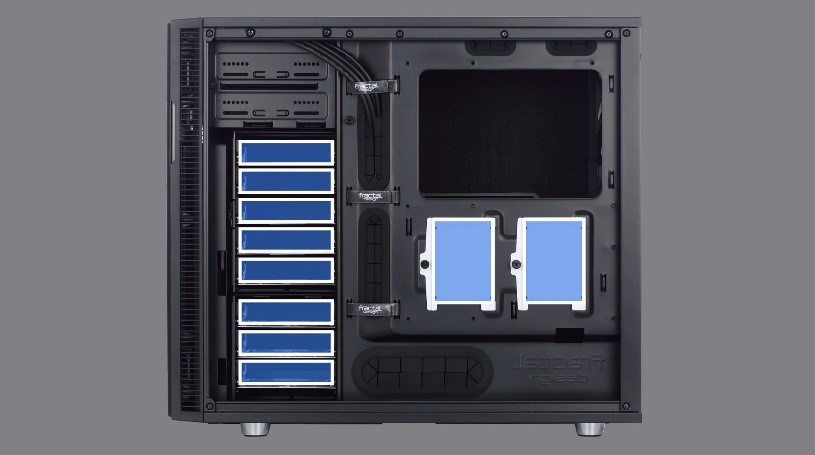

当社独自設計 4GPU ワークステーションケース

理論値224GT/秒の広帯域でGPU間の通信が可能となり、計算のボトルネックを大きく解消できます。

大容量ストレージを搭載

内蔵ベイは2.5インチの高速SSDを最大で4基搭載可能で、システムとデータエリアを分けた運用が可能です。

デュアルパワーサプライユニット搭載

100Vx2入力で理論値2400Wの消費電力までに対応し、高性能CPUに加えてハイエンドGPUを最大で4枚まで搭載可能です。

CPU冷却は液冷を採用し、可能な限り静粛性を維持することでデスクサイドでの利用を可能としました。

ラックマウントにも対応

居室だけでは無くサーバールームやデータセンターなど設置場所を選びません。

当社独自のDeepLearning開発環境「G-Works」

(https://www.gdep.co.jp/information/press_release/g-works4/)

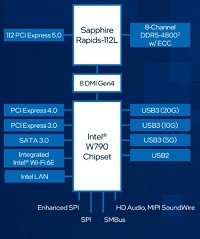

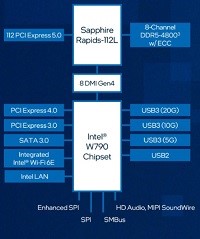

第5世代(ZEN 4)AMD Ryzen プロセッサー搭載を搭載

堅牢なコンポーネントを装備し、安定性を重視したマザーボード

最大128GBまで搭載可能な広帯域4800MHz DDR5メモリー

PCI-Express 5.0 に対応

最大5基のストレージベイを搭載

第5世代(ZEN 4)AMD Ryzen プロセッサー搭載を搭載

堅牢なコンポーネントを装備し、安定性を重視したマザーボード

最大128GBまで搭載可能な広帯域4800MHz DDR5メモリー

PCI-Express 5.0 に対応

最大5基のストレージベイを搭載

AMD新APU Ryzen 5000Gシリーズ を採用

世界屈指の空冷最強メーカー Noctua製 「NH-U12S redux」を選択可能

スリムな120 mmサイズにより、PCケース・メモリ・PCIeスロットとの互換性を確保。静音のNF-P12 redux-1700 120mm PWMファンの自動速度制御機能:アイドル時には静音性に優れ、必要に応じてフル回転でパフォーマンスを発揮します。

高品質な部品を採用し、安定性を重視したプロフェッショナルユーザー向けマザーボード

プロフェッショナルの作業効率を高めるだけでなく、マルチメディア用途や普段使いなど、あらゆるシチュエーションに対応するシステムチューニング機能を搭載しております。

AMD新APU Ryzen 5000Gシリーズ を採用

世界屈指の空冷最強メーカー Noctua製 「NH-U12S redux」を選択可能

スリムな120 mmサイズにより、PCケース・メモリ・PCIeスロットとの互換性を確保。静音のNF-P12 redux-1700 120mm PWMファンの自動速度制御機能:アイドル時には静音性に優れ、必要に応じてフル回転でパフォーマンスを発揮します。

高品質な部品を採用し、安定性を重視したプロフェッショナルユーザー向けマザーボード

プロフェッショナルの作業効率を高めるだけでなく、マルチメディア用途や普段使いなど、あらゆるシチュエーションに対応するシステムチューニング機能を搭載しております。

第5世代(ZEN 4)AMD Ryzen プロセッサー搭載を搭載

堅牢なコンポーネントを装備し、安定性を重視したマザーボード

最大128GBまで搭載可能な広帯域4800MHz DDR5メモリー

PCI-Express 5.0 に対応

最大5基のストレージベイを搭載

AMD新APU Ryzen 5000Gシリーズ を採用

世界屈指の空冷最強メーカー Noctua製 「NH-U12S redux」を選択可能

スリムな120 mmサイズにより、PCケース・メモリ・PCIeスロットとの互換性を確保。静音のNF-P12 redux-1700 120mm PWMファンの自動速度制御機能:アイドル時には静音性に優れ、必要に応じてフル回転でパフォーマンスを発揮します。

高品質な部品を採用し、安定性を重視したプロフェッショナルユーザー向けマザーボード

プロフェッショナルの作業効率を高めるだけでなく、マルチメディア用途や普段使いなど、あらゆるシチュエーションに対応するシステムチューニング機能を搭載しております。

サイドフローCPUファンや185mmの大口径排気ファンが抜群の静粛性を実現しており、高性能と拡張性、そして静粛性を実現した人気モデルです。

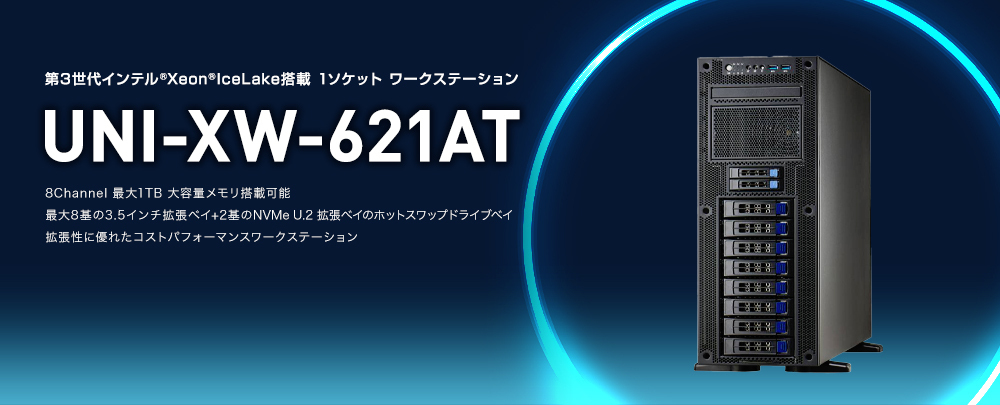

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

また、integer SPECrate2017_int_base や FlotingPoint SPECrate2017_int_base 、LINPAC などベンチマークでは第2世代Xeon Scalable Processor比で約1.46倍の性能向上を実現しています。

抜群の静粛性を誇る静音ケース

2基のCPUを効率よく冷却するサイドフローのCPUファンと、1850回転の大型120mm排気ファンがケース全体のエアフロー効率を高め効率の良い冷却性能を実現します。

筐体サイズはH150xW86xL185mm とミニタワーサイズながら7つの拡張スロット、2基の5.25”ベイ、4基の3.5”ベイ、など拡張性も抜群です。

安定度抜群の高効率電源

サーバーレベルの要求仕様はもちろん、高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

あらゆる利用シーンに対応した拡張性

例えばハイエンドなAmpereグラクィックにHDRのinfinibandカードを追加するなど、よりパワフルな使い方も可能です。

サイドフローCPUファンや185mmの大口径排気ファンが抜群の静粛性を実現しており、高性能と拡張性、そして静粛性を実現した人気モデルです。

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

また、integer SPECrate2017_int_base や FlotingPoint SPECrate2017_int_base 、LINPAC などベンチマークでは第2世代Xeon Scalable Processor比で約1.46倍の性能向上を実現しています。

抜群の静粛性を誇る静音ケース

2基のCPUを効率よく冷却するサイドフローのCPUファンと、1850回転の大型120mm排気ファンがケース全体のエアフロー効率を高め効率の良い冷却性能を実現します。

筐体サイズはH150xW86xL185mm とミニタワーサイズながら7つの拡張スロット、2基の5.25”ベイ、4基の3.5”ベイ、など拡張性も抜群です。

安定度抜群の高効率電源

サーバーレベルの要求仕様はもちろん、高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

あらゆる利用シーンに対応した拡張性

例えばハイエンドなAmpereグラクィックにHDRのinfinibandカードを追加するなど、よりパワフルな使い方も可能です。

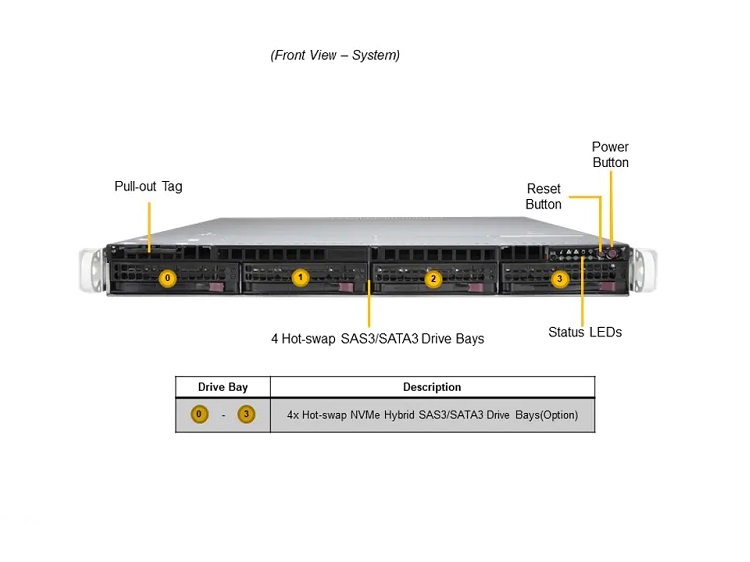

高速広帯域なノード間通信やフレキシブルなストレージ構築にも対応しています。管理ノードやログインノードにも最適なエントリークラスサーバーモデルです。

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

また、integer SPECrate2017_int_base や FlotingPoint SPECrate2017_int_base 、LINPAC などベンチマークでは第2世代Xeon Scalable Processor比で約1.46倍の性能向上を実現しています。

高信頼性エンタープライズストレージを搭載

さらにOS用のNVMeストレージもRAID-1で冗長化を施し障害に強い構成を実現しています。

安定度抜群の高効率電源

多様で高速なインターコネクトでスケールアウトも可能

高速広帯域なノード間通信やフレキシブルなストレージ構築にも対応しています。管理ノードやログインノードにも最適なエントリークラスサーバーモデルです。

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

また、integer SPECrate2017_int_base や FlotingPoint SPECrate2017_int_base 、LINPAC などベンチマークでは第2世代Xeon Scalable Processor比で約1.46倍の性能向上を実現しています。

高信頼性エンタープライズストレージを搭載

さらにOS用のNVMeストレージもRAID-1で冗長化を施し障害に強い構成を実現しています。

安定度抜群の高効率電源

多様で高速なインターコネクトでスケールアウトも可能

高速広帯域なノード間通信やフレキシブルなストレージ構築にも対応しています。管理ノードやログインノードにも最適なエントリークラスサーバーモデルです。

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

また、integer SPECrate2017_int_base や FlotingPoint SPECrate2017_int_base 、LINPAC などベンチマークでは第2世代Xeon Scalable Processor比で約1.46倍の性能向上を実現しています。

高信頼性エンタープライズストレージを搭載

さらにOS用のNVMeストレージもRAID-1で冗長化を施し障害に強い構成を実現しています。

安定度抜群の高効率電源

多様で高速なインターコネクトでスケールアウトも可能

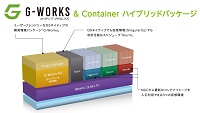

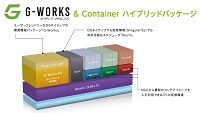

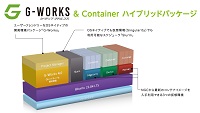

GDEPでは軽量かつ直感的で扱いやすいOSネイティブなオリジナルツール G-Worksバイナリアプリケーションと、より最新技術へのアクセスが容易となるコンテナアプリケーションの併用した「G-Works & Container Hybridパッケージ」をプレインストールし、DeepLearningターンキーシステムとしてお届けします。

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

PCI-Express 4.0 x16 対応ハイエンドGPUを2基搭載可能

本機には x16スロットが3本、x8スロットが2つ搭載されております。ダブルワイドPCI Express 4.0 x16対応する拡張スロットを計2本装備されています。NVIDIA RTX A6000などのハイエンドGPUをはじめ、NVIDIA RTX A6000/A5000/A4000 を最大2基搭載可能です。NVIDIA RTX A6000/5000 搭載モデルはNVLinkにも対応し、2枚1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。

様々な用途で使用可能な筐体

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

PCI-Express 4.0 x16 対応ハイエンドGPUを2基搭載可能

本機には x16スロットが3本、x8スロットが2つ搭載されております。ダブルワイドPCI Express 4.0 x16対応する拡張スロットを計2本装備されています。NVIDIA RTX A6000などのハイエンドGPUをはじめ、NVIDIA RTX A6000/A5000/A4000 を最大2基搭載可能です。NVIDIA RTX A6000/5000 搭載モデルはNVLinkにも対応し、2枚1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。

様々な用途で使用可能な筐体

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

PCI-Express 4.0 x16 対応ハイエンドGPUを2基搭載可能

本機には x16スロットが3本、x8スロットが2つ搭載されております。ダブルワイドPCI Express 4.0 x16対応する拡張スロットを計2本装備されています。NVIDIA RTX A6000などのハイエンドGPUをはじめ、NVIDIA RTX A6000/A5000/A4000 を最大2基搭載可能です。NVIDIA RTX A6000/5000 搭載モデルはNVLinkにも対応し、2枚1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。

様々な用途で使用可能な筐体

入力電圧環境及び構成されたパーツの最大消費電力の問題で選択できない(構成できない)場合があります。

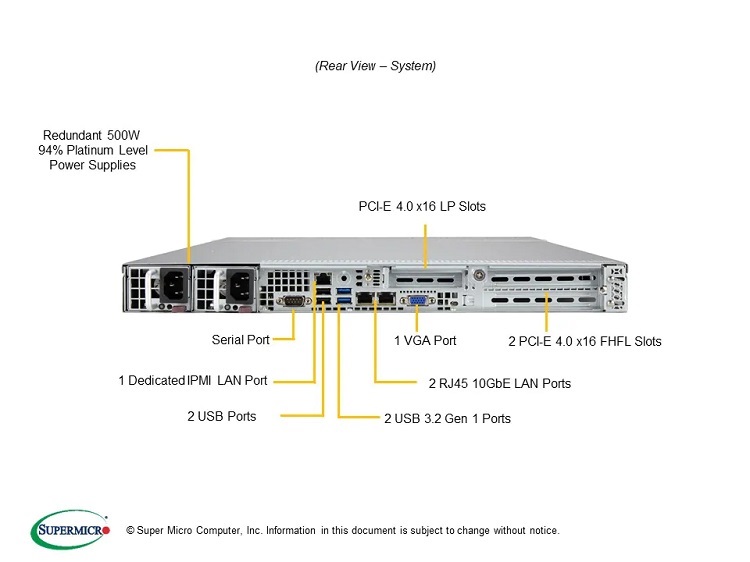

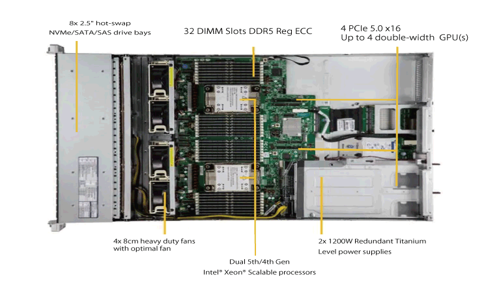

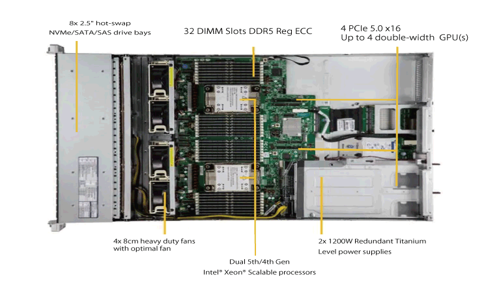

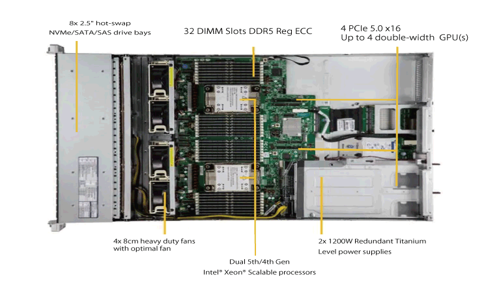

第3世代 インテル® Xeon® スケーラブル・プロセッサーを2基搭載

多彩なストレージベイと拡張ポート

80Plus Titanium認証 の高効率電源

第3世代 インテル® Xeon® スケーラブル・プロセッサーを2基搭載

多彩なストレージベイと拡張ポート

80Plus Titanium認証 の高効率電源

第3世代 インテル® Xeon® スケーラブル・プロセッサーを2基搭載

多彩なストレージベイと拡張ポート

80Plus Titanium認証 の高効率電源

Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、GPUは最大で3枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。

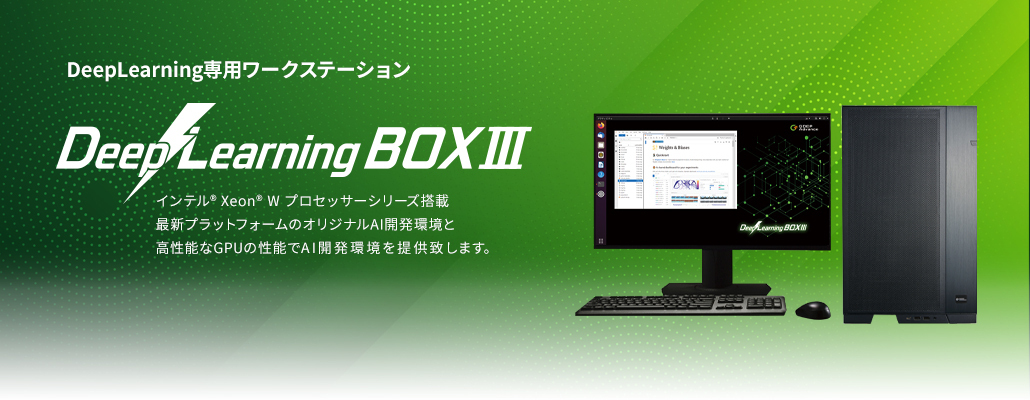

ジーデップ・アドバンスではLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。

「G-Works 4.0」をインストール

DeepLearning BOXIIIには 深層学習研究において高効率で高いパフォーマンスを発揮できるよう Linux(Ubuntu)オペレーティングシステムと、当社独自のAI開発 ライブラリー群 「G-Works4.0」をインストールしてあります。さらに、OpenAI社も利用しているMLopsプラットフォームである「W&B」をプレインストールしており、最新のGPU Compute Capability 9.0に適合し最適に動作するようチューニングされています。

DeepLearning BOXIIIはAI開発ユーザーが面倒な環境設定などを行うことなく、届いたその日から利用できる最適なAI開発環境がインストールされているターンキーAI開発用システムとなります。

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

ウルトラハイエンドGPUカードを 最大3枚搭載可能

搭載GPUはNVIDIA RTX 6000 Ada/*A6000*/A5000/A4000 を最大3枚搭載可能です。NVIDIA RTX A6000/5000 搭載モデルはNVLinkにも対応し、2枚1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。また、標準でCEM5に対応ケーブルを標準採用しており、最新世代のGPU搭載もサポートしております。

*200V 入力時のみ対応

バージョンアップされたDeepLearning開発環境「G-Works4.0」

G-Worksの詳細はこちらからご覧ください。

Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。

ジーデップ・アドバンスではMMLなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。

「G-Works 4.0」をインストール

DeepLearning BOXIIIには 深層学習研究において高効率で高いパフォーマンスを発揮できるよう Linux(Ubuntu)オペレーティングシステムと、当社独自のAI開発 ライブラリー群 「G-Works4.0」をインストールしてあります。さらに、OpenAI社も利用しているMLopsプラットフォームである「W&B」をプレインストールしており、最新のGPU Compute Capability 9.0に適合し最適に動作するようチューニングされています。

DeepLearning BOXIIIはAI開発ユーザーが面倒な環境設定などを行うことなく、届いたその日から利用できる最適なAI開発環境がインストールされているターンキーAI開発用システムとなります。

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

ウルトラハイエンドGPUカードを 最大4枚を搭載可能

搭載GPUはNVIDIA RTX 6000 Ada/*A6000*/A5000/A4000 を最大4枚搭載可能です。NVIDIA RTX A6000/5000 搭載モデルはNVLinkにも対応し、2枚1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。また、標準でCEM5に対応ケーブルを標準採用しており、最新世代のGPU搭載もサポートしております。

*200V 入力時のみ対応

バージョンアップされたDeepLearning開発環境「G-Works4.0」

G-Worksの詳細はこちらからご覧ください。

また、PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待でき、RTX 4090(1基 限定) をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができます。

GPU演算に加えて、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

安定度抜群の高効率電源

また、PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待でき、RTX 4090(1基 限定) をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができます。

GPU演算に加えて、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

安定度抜群の高効率電源

また、PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待でき、RTX 4090(1基 限定) をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができます。

GPU演算に加えて、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

安定度抜群の高効率電源

また、PCI Express 5.0 を備え、GPUは200V環境で最大4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待でき、RTX 4090(1基 限定) をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができます。

オプションのラックレールキットを用いることにより、サーバーラックでの運用も可能です。

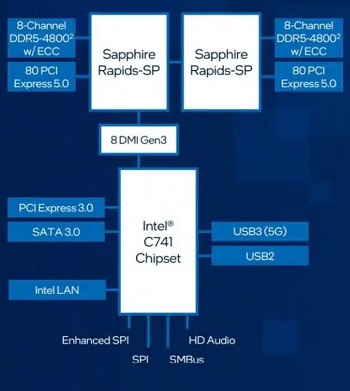

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

安定度抜群の高効率電源

また、PCI Express 5.0 を備え、GPUは200V環境で最大4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待でき、RTX 4090(1基 限定) をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができます。

オプションのラックレールキットを用いることにより、サーバーラックでの運用も可能です。

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

安定度抜群の高効率電源

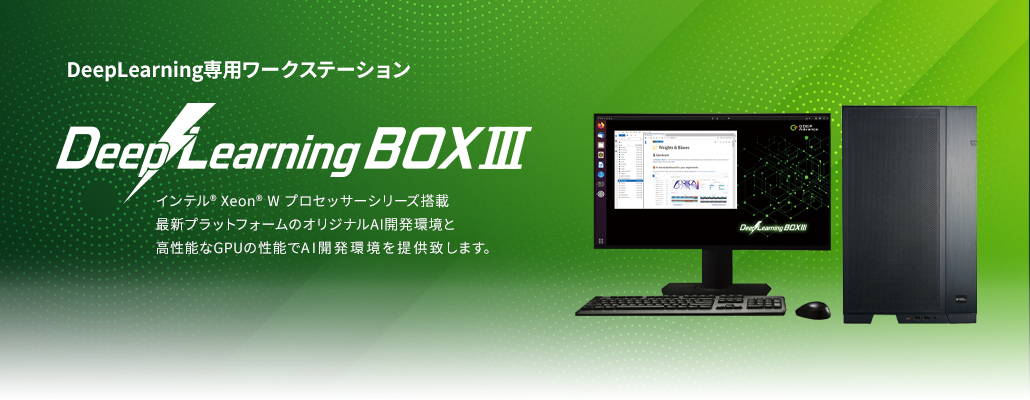

DeepLearning BOXIII はインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3400シリーズを搭載した GPUディープラーニングワークステーションです。

Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。

ジーデップ・アドバンスではMMLなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。

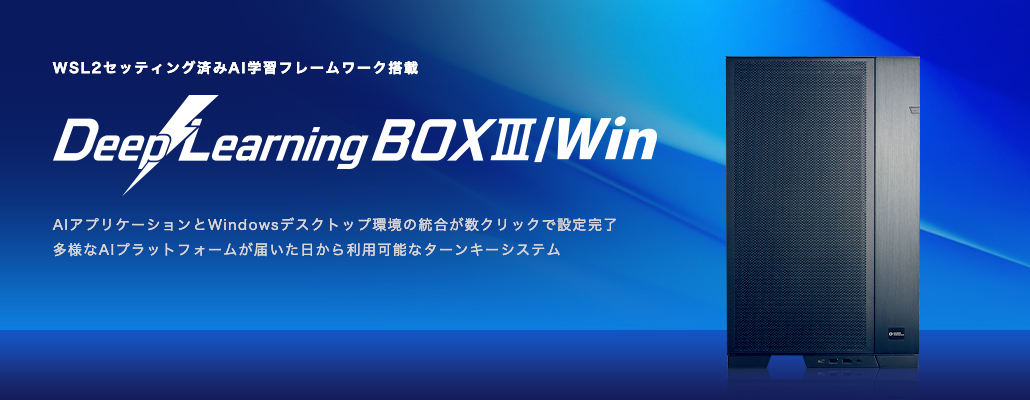

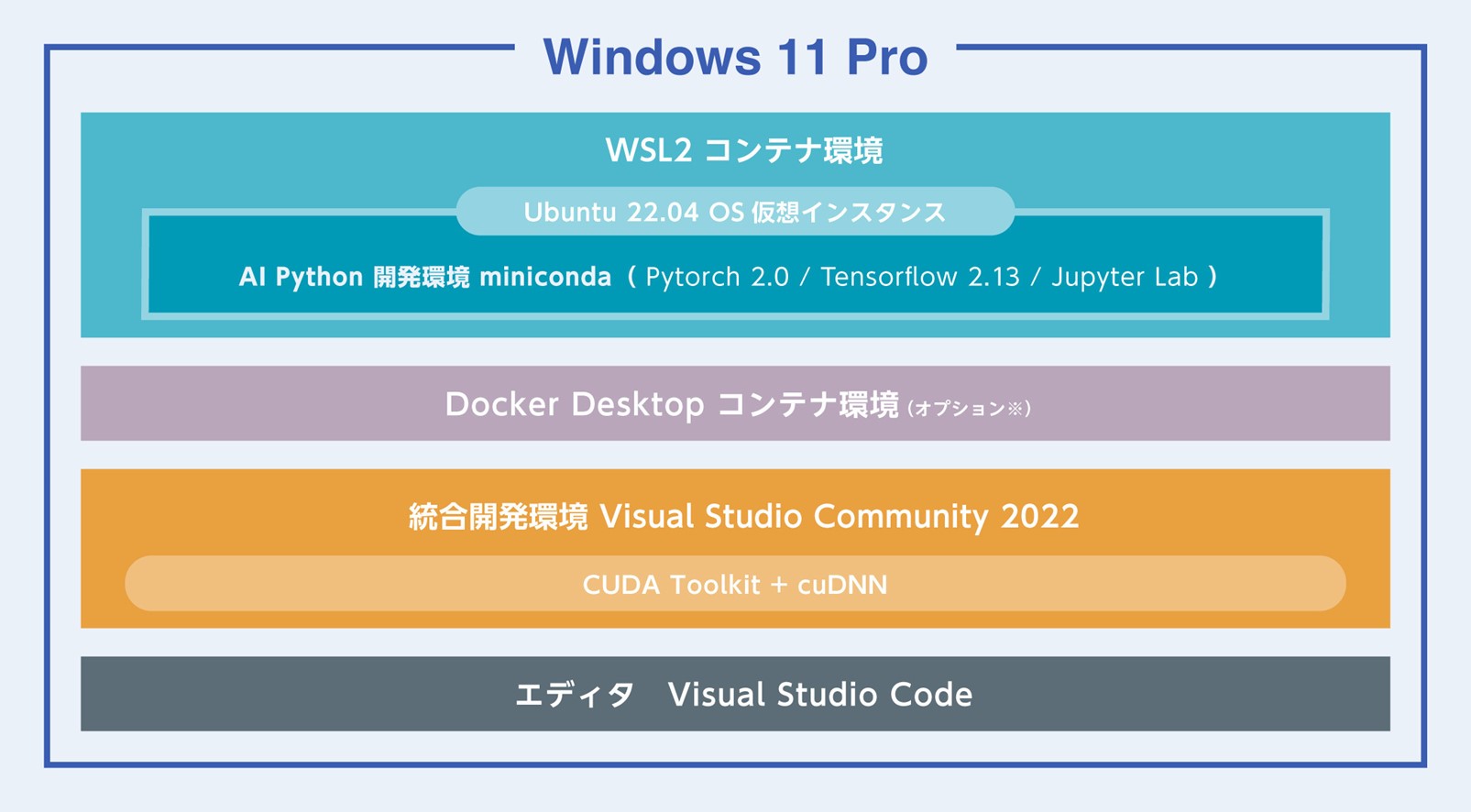

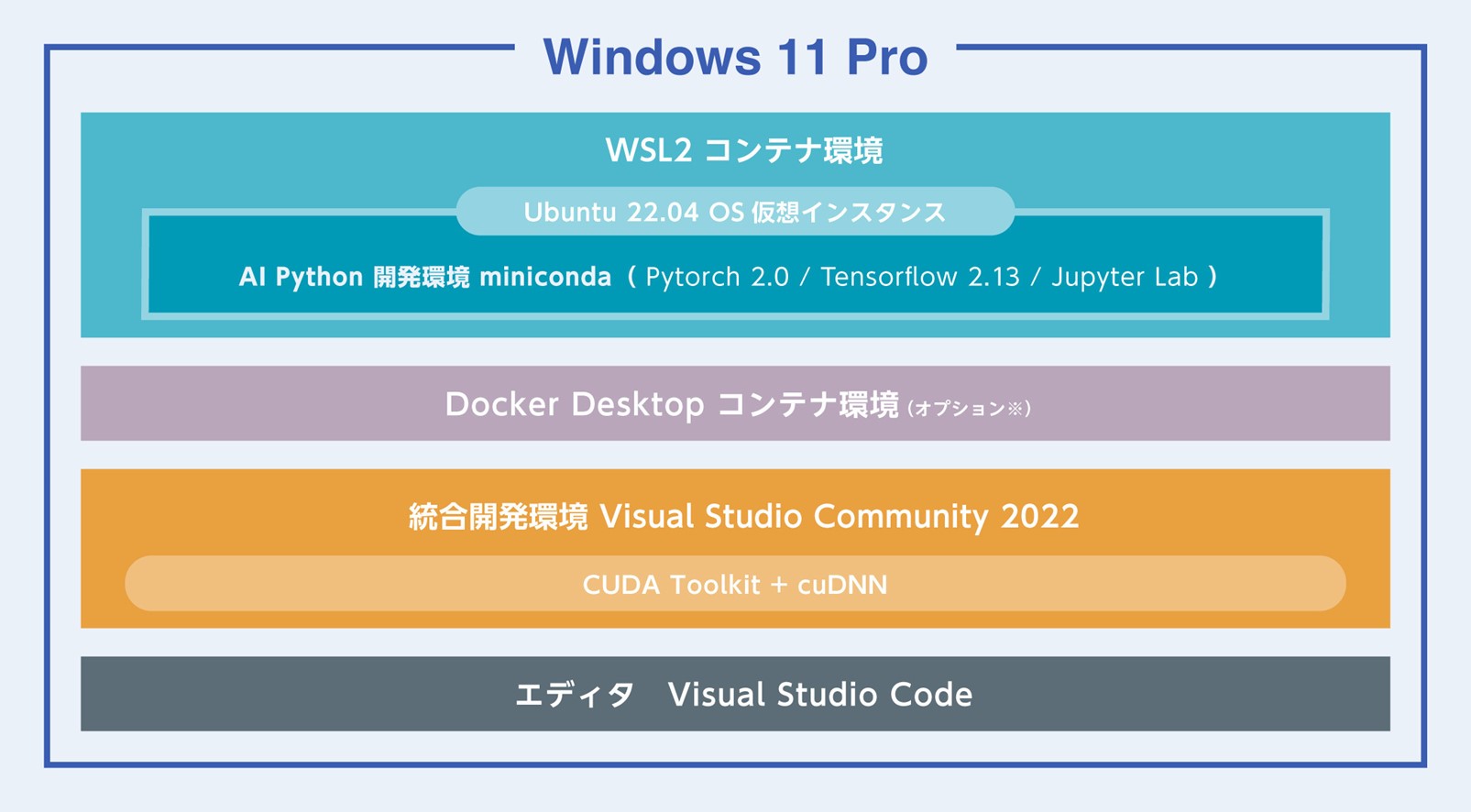

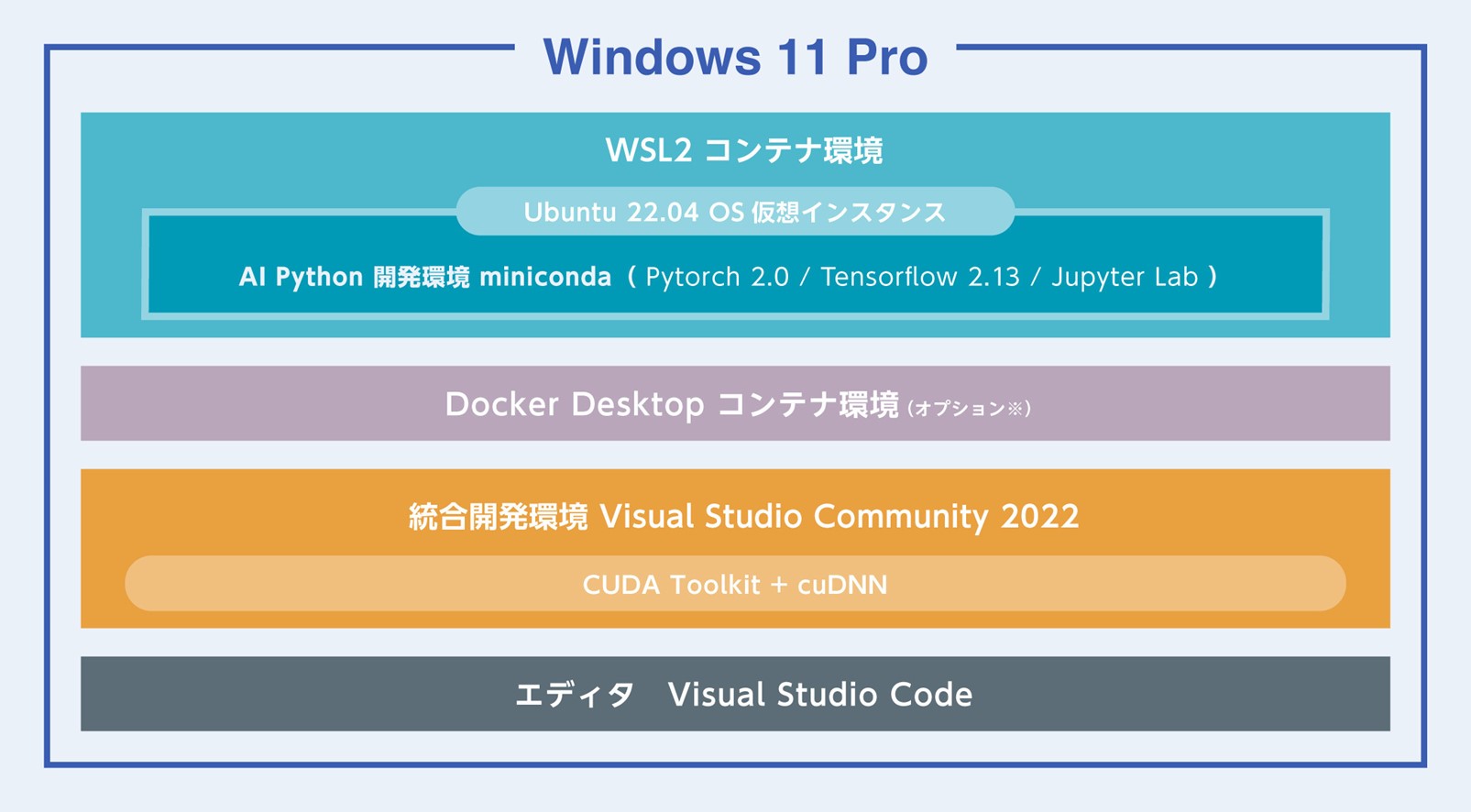

Windows11 WSL2セッティング済み

Windows11をOSに採用した本システムはLinux OS仮想環境を共存させ、Linuxのネイティブアプリケーションを実行可能とするWindows Subsystem for Linux Version 2 (WSL2) を利用しています。多くのAIアプリケーションがLinux上で開発されている中、それらのAIアプリケーションとWindowsデスクトップ環境の統合が容易になります。

一般的にWSL2環境はユーザーアカウントの中に構築されるため、基本的にユーザー自身が設定を行う必要があり、複雑な操作を正しく行うことは研究者とって大きな負担となります。

そこで「DeepLearingBOXIII/Win」では、専用のセットアップスクリプトを配備し、アカウントを作成後、ユーザー自身がWSL2と AI開発環境を、わずか数クリックで構築できる仕組みをプリインストールしました。

システム仕様に最適なDeep Learning環境をWindows上で容易に構築できるこの仕組みはユーザーのAI開発環境構築の負担を大幅に削減し、ファイルシステムへのアクセスも、Windows – Linuxの双方向でほぼシームレスに扱うことが可能で、非常に大きなユーザーベネフィットを提供します。

「DeepLearingBOXIII/Win」ではユーザーがAI開発において面倒で複雑な開発環境設定を行うことなく、届いたその日から利用することが可能です。

WSL2において以下のコンテナ環境でAI開発環境が提供されます。

製品初期設定時にはインターネット接続が必要です。

*Docker DesktopはDocker社の利用条件に従ってご利用ください。

DeepLearning BOXIIIはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3400シリーズを搭載した GPUディープラーニングワークステーションです。

Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。

ジーデップ・アドバンスではMMLなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。

Windows11 WSL2セッティング済み

Windows11をOSに採用した本システムはLinux OS仮想環境を共存させ、Linuxのネイティブアプリケーションを実行可能とするWindows Subsystem for Linux Version 2 (WSL2) を利用しています。多くのAIアプリケーションがLinux上で開発されている中、それらのAIアプリケーションとWindowsデスクトップ環境の統合が容易になります。

一般的にWSL2環境はユーザーアカウントの中に構築されるため、基本的にユーザー自身が設定を行う必要があり、複雑な操作を正しく行うことは研究者とって大きな負担となります。

そこで「DeepLearingBOXIII/Win」では、専用のセットアップスクリプトを配備し、アカウントを作成後、ユーザー自身がWSL2と AI開発環境を、わずか数クリックで構築できる仕組みをプリインストールしました。

システム仕様に最適なDeep Learning環境をWindows上で容易に構築できるこの仕組みはユーザーのAI開発環境構築の負担を大幅に削減し、ファイルシステムへのアクセスも、Windows – Linuxの双方向でほぼシームレスに扱うことが可能で、非常に大きなユーザーベネフィットを提供します。

「DeepLearingBOXIII/Win」ではユーザーがAI開発において面倒で複雑な開発環境設定を行うことなく、届いたその日から利用することが可能です。

WSL2において以下のコンテナ環境でAI開発環境が提供されます。

製品初期設定時にはインターネット接続が必要です。

*Docker DesktopはDocker社の利用条件に従ってご利用ください。

Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。

ジーデップ・アドバンスではLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。

「G-Works 4.0」をインストール

DeepLearning BOXIIIには 深層学習研究において高効率で高いパフォーマンスを発揮できるよう Linux(Ubuntu)オペレーティングシステムと、当社独自のAI開発 ライブラリー群 「G-Works4.0」をインストールしてあります。さらに、OpenAI社も利用しているMLopsプラットフォームである「W&B」をプレインストールしており、最新のGPU Compute Capability 9.0に適合し最適に動作するようチューニングされています。

DeepLearning BOXIIIはAI開発ユーザーが面倒な環境設定などを行うことなく、届いたその日から利用できる最適なAI開発環境がインストールされているターンキーAI開発用システムとなります。

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

ウルトラハイエンドGPUカードを 最大4枚を搭載可能

搭載GPUはNVIDIA RTX 6000 Ada/*A6000*/A5000/A4000 を最大4枚搭載可能です。NVIDIA RTX A6000/5000 搭載モデルはNVLinkにも対応し、2枚1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。また、標準でCEM5に対応ケーブルを標準採用しており、最新世代のGPU搭載もサポートしております。

*200V 入力時のみ対応

バージョンアップされたDeepLearning開発環境「G-Works4.0」

G-Worksの詳細はこちらからご覧ください。

DeepLearning BOXIIIはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3400シリーズを搭載した GPUディープラーニングワークステーションです。

Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、GPUは最大で4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。

ジーデップ・アドバンスではMMLなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。

Windows11 WSL2セッティング済み

Windows11をOSに採用した本システムはLinux OS仮想環境を共存させ、Linuxのネイティブアプリケーションを実行可能とするWindows Subsystem for Linux Version 2 (WSL2) を利用しています。多くのAIアプリケーションがLinux上で開発されている中、それらのAIアプリケーションとWindowsデスクトップ環境の統合が容易になります。

一般的にWSL2環境はユーザーアカウントの中に構築されるため、基本的にユーザー自身が設定を行う必要があり、複雑な操作を正しく行うことは研究者とって大きな負担となります。

そこで「DeepLearingBOXIII/Win」では、専用のセットアップスクリプトを配備し、アカウントを作成後、ユーザー自身がWSL2と AI開発環境を、わずか数クリックで構築できる仕組みをプリインストールしました。

システム仕様に最適なDeep Learning環境をWindows上で容易に構築できるこの仕組みはユーザーのAI開発環境構築の負担を大幅に削減し、ファイルシステムへのアクセスも、Windows – Linuxの双方向でほぼシームレスに扱うことが可能で、非常に大きなユーザーベネフィットを提供します。

「DeepLearingBOXIII/Win」ではユーザーがAI開発において面倒で複雑な開発環境設定を行うことなく、届いたその日から利用することが可能です。

WSL2において以下のコンテナ環境でAI開発環境が提供されます。

製品初期設定時にはインターネット接続が必要です。

*Docker DesktopはDocker社の利用条件に従ってご利用ください。

また、PCI Express 5.0 を備え、GPUは200V環境で最大4枚まで搭載可能です。最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待でき、RTX 4090(1基 限定) をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができます。

オプションのラックレールキットを用いることにより、サーバーラックでの運用も可能です。

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

インテル Xeon W プロセッサー 搭載

強化されたプラットフォーム

安定度抜群の高効率電源

お客様のご要望によって設計されたGDEPオリジナルケースは2つの電源ユニットで構成され、最大4枚のハイエンドGPUを112レーンのPCI Express5.0で搭載。理論値224GT/秒の広帯域でGPU間疎通が可能となり、計算のボトルネックを大きく解消できます。また、フロントアクセスが可能な2基のHDDスワップベイと、4基の内蔵SSDが高いストレージ拡張性を実現します。

更にオプションのラックマウントレールを装着することにより、デスクサイド利用に加え19インチラックへの搭載も可能となっています。

ジーデップ・アドバンスではLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なAIワークステーションです。

また、ベースとなるプラットフォームは、Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

「G-Works 4.0」をインストール

DeepLearningSTATION シリーズには 深層学習研究において高効率で高いパフォーマンスを発揮できるよう Linux(Ubuntu)オペレーティングシステムと、当社独自のAI開発 ライブラリー群 「G-Works4.0」をインストールしてあります。さらに、OpenAI社も利用しているMLopsプラットフォームである「W&B」をプレインストールしており、最新のGPU Compute Capability 9.0に適合し最適に動作するようチューニングされています。

ジーデップ・アドバンスのAIワークステーションは、AI開発ユーザーが面倒な環境設定などを行うことなく、届いたその日から利用できる最適なAI開発環境がインストールされているターンキーAI開発用システムとなります。

独自設計 4GPU ワークステーションケース

お客様のご要望によって設計されたGDEPオリジナルケースは2つの電源ユニットで構成され、最大4枚のハイエンドGPUを112レーンのPCI Express5.0で搭載。理論値224GT/秒の広帯域でGPU間疎通が可能となり、計算のボトルネックを大きく解消できます。

デスクサイドでLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意しています。

フロントアクセス可能なストレージベイ

フロントベイはセキュリティーキーを標準装備、サイドパネルはワイヤーロックに対応し、セキュリティー面も考慮した設計となっています。

デュアルパワーサプライユニット搭載

居室だけでは無くサーバールームやデータセンターなど設置場所を選びません。

ラックマウントにも対応

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

居室だけでは無くサーバールームやデータセンターなど設置場所を選びません。

当社独自のDeepLearning開発環境「G-Works4.0」をインストール

当社独自のDeepLearning開発環境である「G-Works 4.0」は、OSネーティブでディープラーニングフレームワークを利用できる環境に加えて、MLOpsプラットフォームであるWandBをプリインストールしており、実験結果のトラッキングや学習効率の可視化が可能です。

OSはUbuntu 22.04 LTSに対応、業界標準となっている仮想環境Dockerに加え、AI/HPCアプリケーションに適したSingularity、およびワークロードマネジメント用にSlurmをインストールしました。

また、NVIDIA社が提供するNVIDIA GPU Cloud (NGC)の内容を検索できるngcスクリプトも配置してありますので、コマンドラインから利用出来るDocker Imageを簡単に探し出すことが可能です。

G-Worksの詳細はこちらからご覧ください。

お客様のご要望によって設計されたGDEPオリジナルケースは2つの電源ユニットで構成され、最大4枚のハイエンドGPUを112レーンのPCI Express5.0で搭載。理論値224GT/秒の広帯域でGPU間疎通が可能となり、計算のボトルネックを大きく解消できます。また、フロントアクセスが可能な2基のHDDスワップベイと、4基の内蔵SSDが高いストレージ拡張性を実現します。

更にオプションのラックマウントレールを装着することにより、デスクサイド利用に加え19インチラックへの搭載も可能となっています。

ジーデップ・アドバンスではLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なAIワークステーションです。

また、ベースとなるプラットフォームは、Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

「G-Works 4.0」をインストール

DeepLearningSTATION シリーズには 深層学習研究において高効率で高いパフォーマンスを発揮できるよう Linux(Ubuntu)オペレーティングシステムと、当社独自のAI開発 ライブラリー群 「G-Works4.0」をインストールしてあります。さらに、OpenAI社も利用しているMLopsプラットフォームである「W&B」をプレインストールしており、最新のGPU Compute Capability 9.0に適合し最適に動作するようチューニングされています。

ジーデップ・アドバンスのAIワークステーションは、AI開発ユーザーが面倒な環境設定などを行うことなく、届いたその日から利用できる最適なAI開発環境がインストールされているターンキーAI開発用システムとなります。

独自設計 4GPU ワークステーションケース

お客様のご要望によって設計されたGDEPオリジナルケースは2つの電源ユニットで構成され、最大4枚のハイエンドGPUを112レーンのPCI Express5.0で搭載。理論値224GT/秒の広帯域でGPU間疎通が可能となり、計算のボトルネックを大きく解消できます。

デスクサイドでLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意しています。

フロントアクセス可能なストレージベイ

フロントベイはセキュリティーキーを標準装備、サイドパネルはワイヤーロックに対応し、セキュリティー面も考慮した設計となっています。

デュアルパワーサプライユニット搭載

居室だけでは無くサーバールームやデータセンターなど設置場所を選びません。

ラックマウントにも対応

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

居室だけでは無くサーバールームやデータセンターなど設置場所を選びません。

当社独自のDeepLearning開発環境「G-Works4.0」をインストール

当社独自のDeepLearning開発環境である「G-Works 4.0」は、OSネーティブでディープラーニングフレームワークを利用できる環境に加えて、MLOpsプラットフォームであるWandBをプリインストールしており、実験結果のトラッキングや学習効率の可視化が可能です。

OSはUbuntu 22.04 LTSに対応、業界標準となっている仮想環境Dockerに加え、AI/HPCアプリケーションに適したSingularity、およびワークロードマネジメント用にSlurmをインストールしました。

また、NVIDIA社が提供するNVIDIA GPU Cloud (NGC)の内容を検索できるngcスクリプトも配置してありますので、コマンドラインから利用出来るDocker Imageを簡単に探し出すことが可能です。

G-Worksの詳細はこちらからご覧ください。

お客様のご要望によって設計されたGDEPオリジナルケースは2つの電源ユニットで構成され、最大4枚のハイエンドGPUを112レーンのPCI Express5.0で搭載。理論値224GT/秒の広帯域でGPU間疎通が可能となり、計算のボトルネックを大きく解消できます。また、フロントアクセスが可能な2基のHDDスワップベイと、4基の内蔵SSDが高いストレージ拡張性を実現します。

更にオプションのラックマウントレールを装着することにより、デスクサイド利用に加え19インチラックへの搭載も可能となっています。

ジーデップ・アドバンスではLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なAIワークステーションです。

また、ベースとなるプラットフォームは、Xeon W3400シリーズの採用によりシングルソケットで最大 56 個のメニーコア環境を実現しています。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

「G-Works 4.0」をインストール

DeepLearning STATION シリーズには 深層学習研究において高効率で高いパフォーマンスを発揮できるよう Linux(Ubuntu)オペレーティングシステムと、当社独自のAI開発 ライブラリー群 「G-Works4.0」をインストールしてあります。さらに、OpenAI社も利用しているMLopsプラットフォームである「W&B」をプレインストールしており、最新のGPU Compute Capability 9.0に適合し最適に動作するようチューニングされています。

ジーデップ・アドバンスのAIワークステーションは、AI開発ユーザーが面倒な環境設定などを行うことなく、届いたその日から利用できる最適なAI開発環境がインストールされているターンキーAI開発用システムとなります。

独自設計 4GPU ワークステーションケース

お客様のご要望によって設計されたGDEPオリジナルケースは2つの電源ユニットで構成され、最大4枚のハイエンドGPUを112レーンのPCI Express5.0で搭載。理論値224GT/秒の広帯域でGPU間疎通が可能となり、計算のボトルネックを大きく解消できます。

デスクサイドでLLMなどの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意しています。

フロントアクセス可能なストレージベイ

フロントベイはセキュリティーキーを標準装備、サイドパネルはワイヤーロックに対応し、セキュリティー面も考慮した設計となっています。

デュアルパワーサプライユニット搭載

居室だけでは無くサーバールームやデータセンターなど設置場所を選びません。

ラックマウントにも対応

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

居室だけでは無くサーバールームやデータセンターなど設置場所を選びません。

当社独自のDeepLearning開発環境「G-Works4.0」をインストール

当社独自のDeepLearning開発環境である「G-Works 4.0」は、OSネーティブでディープラーニングフレームワークを利用できる環境に加えて、MLOpsプラットフォームであるWandBをプリインストールしており、実験結果のトラッキングや学習効率の可視化が可能です。

OSはUbuntu 22.04 LTSに対応、業界標準となっている仮想環境Dockerに加え、AI/HPCアプリケーションに適したSingularity、およびワークロードマネジメント用にSlurmをインストールしました。

また、NVIDIA社が提供するNVIDIA GPU Cloud (NGC)の内容を検索できるngcスクリプトも配置してありますので、コマンドラインから利用出来るDocker Imageを簡単に探し出すことが可能です。

G-Worksの詳細はこちらからご覧ください。

大規模言語モデル(LLM)の開発において、機密性の高い学習データをイントラから外に出すことに安全上の様々な懸念があることが多い中、お手軽・迅速・安全利用したいユーザーに最適です。

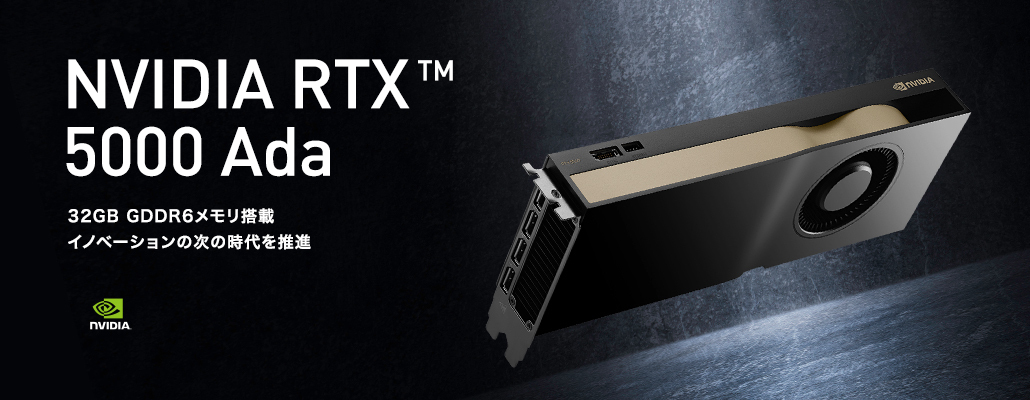

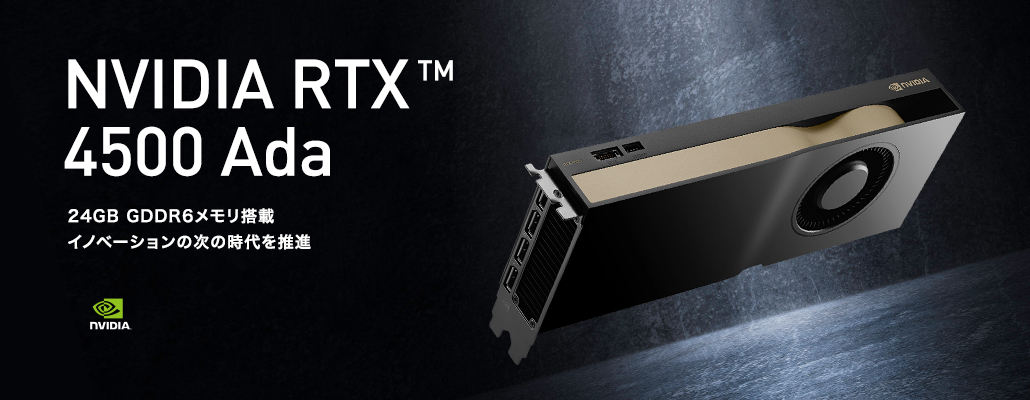

スタンダードモデルとなるワークステーションのGPUは NVIDIA Ada Lovelaceアーキテクチャを採用したRTX Adaシリーズを搭載し、第3世代の RT コア、第4世代の Tensor コア、次世代 CUDA® コアを搭載。高いAI学習性能及び推論性能を実現します。

開発環境には Dify OpenWebUIと Ollama Xinference を実装し、 AIモデルには2025年1月7日に公開された最新のMicrosoft Phi-4 [14Bモデル] 、2024年公開のLlama 3.1など複数のモデルをプリインストールしています。そのため、届いたその日から最短時間で基本機能が稼働し、迅速に業務への導入が可能です。加えてRidge-iのQ&Aに利用できるQ&Aチケットが付属していますので、サポートを受けながらスムーズな導入が可能です。

また、ローカルRAGスターターBOXは、ハードウェア構成のオプションとしてGPUカードの追加、ストレージの増設などにも柔軟に対応し、PoCから実装運用フェーズまで包括的にサポートするワークステーションです。

セキュアなローカル環境

短期導入・即運用可能

安心のQ&Aチケット

さらにローカルRAGスターターBOXでのPoCを経て、本格的なシステムの導入をご検討のお客様には、GPUとAIのプロフェッショナルであるジーデップ・アドバンスとRidge-iが実運用フェーズまで包括的にサポートし、LLM/RAGローカル運用環境の構築をお手伝いいたします。

※Q&A サポートの範囲はマニュアルに記載の内容に沿った操作方法となります。

抜群のコストパフォーマンス

他に類を見ない拡張性と柔軟性

大規模言語モデル(LLM)の開発において、機密性の高い学習データをイントラから外に出すことに安全上の様々な懸念があることが多い中、お手軽・迅速・安全利用したいユーザーに最適です。

スタンダードモデルとなるワークステーションのGPUは NVIDIA Ada Lovelaceアーキテクチャを採用したRTX Adaシリーズを搭載し、第3世代の RT コア、第4世代の Tensor コア、次世代 CUDA® コアを搭載。高いAI学習性能及び推論性能を実現します。

開発環境には Dify OpenWebUIと Ollama Xinference を実装し、 AIモデルには2025年1月7日に公開された最新のMicrosoft Phi-4 [14Bモデル] 、2024年公開のLlama 3.1など複数のモデルをプリインストールしています。そのため、届いたその日から最短時間で基本機能が稼働し、迅速に業務への導入が可能です。加えてRidge-iのQ&Aに利用できるQ&Aチケットが付属していますので、サポートを受けながらスムーズな導入が可能です。

また、ローカルRAGスターターBOXは、ハードウェア構成のオプションとしてGPUカードの追加、ストレージの増設などにも柔軟に対応し、PoCから実装運用フェーズまで包括的にサポートするワークステーションです。

セキュアなローカル環境

短期導入・即運用可能

安心のQ&Aチケット

さらにローカルRAGスターターBOXでのPoCを経て、本格的なシステムの導入をご検討のお客様には、GPUとAIのプロフェッショナルであるジーデップ・アドバンスとRidge-iが実運用フェーズまで包括的にサポートし、LLM/RAGローカル運用環境の構築をお手伝いいたします。

※Q&A サポートの範囲はマニュアルに記載の内容に沿った操作方法となります。

抜群のコストパフォーマンス

他に類を見ない拡張性と柔軟性

大規模言語モデル(LLM)の開発において、機密性の高い学習データをイントラから外に出すことに安全上の様々な懸念があることが多い中、お手軽・迅速・安全利用したいユーザーに最適です。

スタンダードモデルとなるワークステーションのGPUは NVIDIA Ada Lovelaceアーキテクチャを採用したRTX Adaシリーズを搭載し、第3世代の RT コア、第4世代の Tensor コア、次世代 CUDA® コアを搭載。高いAI学習性能及び推論性能を実現します。

開発環境には Dify OpenWebUIと Ollama Xinference を実装し、 AIモデルには2025年1月7日に公開された最新のMicrosoft Phi-4 [14Bモデル] 、2024年公開のLlama 3.1など複数のモデルをプリインストールしています。そのため、届いたその日から最短時間で基本機能が稼働し、迅速に業務への導入が可能です。加えてRidge-iのQ&Aに利用できるQ&Aチケットが付属していますので、サポートを受けながらスムーズな導入が可能です。

また、ローカルRAGスターターBOXは、ハードウェア構成のオプションとしてGPUカードの追加、ストレージの増設などにも柔軟に対応し、PoCから実装運用フェーズまで包括的にサポートするワークステーションです。

セキュアなローカル環境

短期導入・即運用可能

安心のQ&Aチケット

さらにローカルRAGスターターBOXでのPoCを経て、本格的なシステムの導入をご検討のお客様には、GPUとAIのプロフェッショナルであるジーデップ・アドバンスとRidge-iが実運用フェーズまで包括的にサポートし、LLM/RAGローカル運用環境の構築をお手伝いいたします。

※Q&A サポートの範囲はマニュアルに記載の内容に沿った操作方法となります。

抜群のコストパフォーマンス

他に類を見ない拡張性と柔軟性

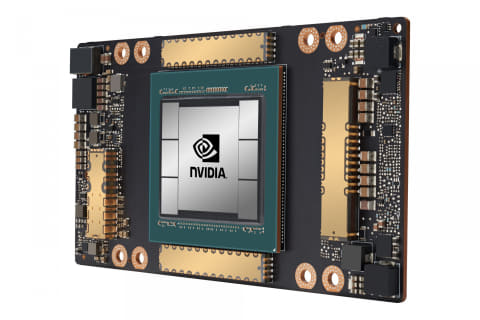

ジーデップ・アドバンスが国内代理店をしている Super Micro Computer, Inc. の SuperServer をベースにしたAMD 第3世代EPYC™ "MILAN" 7003 Serie搭載のGPUサーバです。4Uラックマウント筐体に最大8枚までのハイエンドGPUを搭載可能。Gen4対応の広帯域なPCI-Eepress 接続と、NVLINKで高速なCPU-GPU間、GPU-GPU間のデータ疎通を実現します。

NVIDIAエリートパートナーのジーデップ・アドバンスでは最新のNVIDIA社のハイエンドGPUを搭載し、AIやHPCでご利用頂けるようOSやミドルウェアをプリインストールしたモデルをご用意しました。

GDEPでは軽量かつ直感的で扱いやすいOSネイティブなオリジナルツール G-Worksバイナリアプリケーションと、より最新技術へのアクセスが容易となるコンテナアプリケーションの併用した「G-Works & Container Hybridパッケージ」をプレインストールし、DeepLearningターンキーシステムとしてお届けします。

*こちらのモデル(GSV-AGESM-4U8G)のGPUアカデミック価格は、3枚以上のご購入からご選択いただけます。

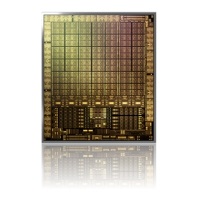

NVIDIAの最新GPU A100 (40GB)を最大8枚実装可能

ジーデップ・アドバンスのGSV-SMC4U8GはGen4のPCI-Exppress Gen4 の NVIDIA A100を最大8枚搭載可能です。

NVIDIA A100 (PCI Express Gen4) 性能

| ピーク FP64 | 9.7 TF |

| ピーク FP64 Tensor コア | 19.5 TF |

| ピーク FP32 | 19.5 TF |

| ピーク TF32 Tensor コア | 156 TF | 312 TF* |

| ピーク BFLOAT16 Tensor コア | 312 TF | 624 TF* |

| ピーク FP16 Tensor コア | 312 TF | 624 TF* |

| ピーク INT8 Tensor コア | 624 TOPS | 1,248 TOPS* |

| ピーク INT4 Tensor コア | 1,248 TOPS | 2,496 TOPS* |

| GPU メモリ | 40 GB |

| GPU メモリ帯域幅 | 1,555 GB/s |

| 相互接続 | PCIe Gen4 64 GB/s |

| マルチインスタンス GPU | 最大 7MIG @5GB のさまざまなインスタンス サイズ |

| フォーム ファクター | PCIe |

| 最大 TDP 電力 | 250W |

| 主要アプリケーション実効性能 | 90% |

AMD EPYC™ 7003シリーズをDUAL搭載

AMD EPYC 7003 シリーズ・プロセッサーは、AMD「Zen 3」マイクロアーキテクチャー・ベースのコアと AMD Infinity アーキテクチャーをベースに、業界をリードする I/O、7nm x86 CPU テクノロジー、イに統合されたセキュリティー・プロセッサーなど、充実した機能を製品ラインアップ全体で提供します。

同時に、コアあたり最大 32 MB の L3 キャッシュを搭載し、4-6-8 チャネルのメモリー・インターリーブを提供して様々な DIMM 構成でパフォーマンスを最適化するほか、ファブリックとメモリー間のクロック同期など、リーダーシップのパフォーマンスを発揮する様々なテクノロジーも提供します。

エンタープライズ NVMe SSD

GSVシリーズに搭載されているNVMe SSDはビジネスインテリジェンス(BI)、オンライントランザクション処理(OLTP)、ソフトウェア・デファインド・ストレージ(SDS)、仮想化環境などの 様々な企業向けアプリケーションおよび関連ワークロードに適したリードインテンシブSSDです。 あらゆる状態において、高い安定性能を維持し優れた耐久性と高速性を実現します。※メーカー・型番は調達状況により異なります。特定のメーカー・型番のご指定は弊社までご相談下さい。

安心&安定のTITANIUM96%+レベル 2+2リダンダント電源

GPUサーバーの安定動作の重要なファクターは何と言っても電源ユニットです。最大8枚の NVIDIA A100 搭載構成時においても安定動作を担保できる高効率96%+となる高効率2000W TITANIUM電源を採用しています。低 ESR・超低インピーダンスと抜群の耐久性を誇り、2+2の冗長性を確保。負荷の高いワークロードでも全てのGPUへ余裕のある電源供給を実現します。

ジーデップ・アドバンスが国内代理店をしている Super Micro Computer, Inc. の SuperServer をベースにしたAMD 第3世代EPYC™ "MILAN" 7003 Serie搭載のGPUサーバです。4Uラックマウント筐体に最大8枚までのハイエンドGPUを搭載可能。Gen4対応の広帯域なPCI-Eepress 接続と、NVLINKで高速なCPU-GPU間、GPU-GPU間のデータ疎通を実現します。

NVIDIAエリートパートナーのジーデップ・アドバンスでは最新のNVIDIA社のハイエンドGPUを搭載し、AIやHPCでご利用頂けるようOSやミドルウェアをプリインストールしたモデルをご用意しました。

NVIDIAの最新GPU A100 (40GB)を最大8枚実装可能

ジーデップ・アドバンスのGSV-4U/8G-A100はGen4のPCI-Exppress Gen4 の NVIDIA A100を最大8枚搭載可能です。

NVIDIA A100 (PCI Express Gen4) 性能

| ピーク FP64 | 9.7 TF |

| ピーク FP64 Tensor コア | 19.5 TF |

| ピーク FP32 | 19.5 TF |

| ピーク TF32 Tensor コア | 156 TF | 312 TF* |

| ピーク BFLOAT16 Tensor コア | 312 TF | 624 TF* |

| ピーク FP16 Tensor コア | 312 TF | 624 TF* |

| ピーク INT8 Tensor コア | 624 TOPS | 1,248 TOPS* |

| ピーク INT4 Tensor コア | 1,248 TOPS | 2,496 TOPS* |

| GPU メモリ | 40 GB |

| GPU メモリ帯域幅 | 1,555 GB/s |

| 相互接続 | PCIe Gen4 64 GB/s |

| マルチインスタンス GPU | 最大 7MIG @5GB のさまざまなインスタンス サイズ |

| フォーム ファクター | PCIe |

| 最大 TDP 電力 | 250W |

| 主要アプリケーション実効性能 | 90% |

第2世代 AMD EPYC™ 7002シリーズをDUAL搭載

Samsung製データセンター向け高速 NVMe SSD

高速なPCI-Express3.0(x4)(NMV Express)接続のSamsung製データセンター向けNVMe SSDを標準採用。Samsung 3D V-NAND と、32GB / 秒の帯域幅を提供する PCIe Gen 3.0 x4 ホストインタフェースを備えた最適化された Samsung NVMe コントローラーを使用して、SATA SSD の 4 倍のパフォーマンスを実現します。また、ランダム Read/Write 性能において SAS HDD より 1000 倍速く、2.5 インチ SAS SSD より 3 倍優れています。PM983 は、より低速な SATA SSD と同じ、ギガバイトあたりの低コストを実現します。1 ドルあたり 4 倍の IOPS を提供することで、IT やデータセンター管理者は、サーバーのワークロード利用率を拡大し、コンピューティング環境のコストを削減できます。

安心&安定のTITANIUM96%+レベル 2+2リダンダント電源

GPUサーバーの安定動作の重要なファクターは何と言っても電源ユニットです。最大8枚の NVIDIA A100 搭載構成時においても安定動作を担保できる高効率96%+となる高効率2000W TITANIUM電源を採用しています。低 ESR・超低インピーダンスと抜群の耐久性を誇り、2+2の冗長性を確保。負荷の高いワークロードでも全てのGPUへ余裕のある電源供給を実現します。

ジーデップ・アドバンスが国内代理店をしている Super Micro Computer, Inc. の SuperServer をベースにしたAMD 第3世代EPYC™ "MILAN" 7003 Serie搭載のGPUサーバです。4Uラックマウント筐体に最大8枚までのハイエンドGPUを搭載可能。Gen4対応の広帯域なPCI-Eepress 接続と、NVLINKで高速なCPU-GPU間、GPU-GPU間のデータ疎通を実現します。

NVIDIAエリートパートナーのジーデップ・アドバンスでは最新のNVIDIA社のハイエンドGPUを搭載し、AIやHPCでご利用頂けるようOSやミドルウェアをプリインストールしたモデルをご用意しました。

NVIDIAの最新GPU A100 (40GB)を最大8枚実装可能

ジーデップ・アドバンスのGSV-4U/8G-A100はGen4のPCI-Exppress Gen4 の NVIDIA A100を最大8枚搭載可能です。

NVIDIA A100 (PCI Express Gen4) 性能

| ピーク FP64 | 9.7 TF |

| ピーク FP64 Tensor コア | 19.5 TF |

| ピーク FP32 | 19.5 TF |

| ピーク TF32 Tensor コア | 156 TF | 312 TF* |

| ピーク BFLOAT16 Tensor コア | 312 TF | 624 TF* |

| ピーク FP16 Tensor コア | 312 TF | 624 TF* |

| ピーク INT8 Tensor コア | 624 TOPS | 1,248 TOPS* |

| ピーク INT4 Tensor コア | 1,248 TOPS | 2,496 TOPS* |

| GPU メモリ | 40 GB |

| GPU メモリ帯域幅 | 1,555 GB/s |

| 相互接続 | PCIe Gen4 64 GB/s |

| マルチインスタンス GPU | 最大 7MIG @5GB のさまざまなインスタンス サイズ |

| フォーム ファクター | PCIe |

| 最大 TDP 電力 | 250W |

| 主要アプリケーション実効性能 | 90% |

第2世代 AMD EPYC™ 7002シリーズをDUAL搭載

Samsung製データセンター向け高速 NVMe SSD

高速なPCI-Express3.0(x4)(NMV Express)接続のSamsung製データセンター向けNVMe SSDを標準採用。Samsung 3D V-NAND と、32GB / 秒の帯域幅を提供する PCIe Gen 3.0 x4 ホストインタフェースを備えた最適化された Samsung NVMe コントローラーを使用して、SATA SSD の 4 倍のパフォーマンスを実現します。また、ランダム Read/Write 性能において SAS HDD より 1000 倍速く、2.5 インチ SAS SSD より 3 倍優れています。PM983 は、より低速な SATA SSD と同じ、ギガバイトあたりの低コストを実現します。1 ドルあたり 4 倍の IOPS を提供することで、IT やデータセンター管理者は、サーバーのワークロード利用率を拡大し、コンピューティング環境のコストを削減できます。

安心&安定のTITANIUM96%+レベル 2+2リダンダント電源

GPUサーバーの安定動作の重要なファクターは何と言っても電源ユニットです。最大8枚の NVIDIA A100 搭載構成時においても安定動作を担保できる高効率96%+となる高効率2000W TITANIUM電源を採用しています。低 ESR・超低インピーダンスと抜群の耐久性を誇り、2+2の冗長性を確保。負荷の高いワークロードでも全てのGPUへ余裕のある電源供給を実現します。

Alveo アクセラレータ カードは、変化するアクセラレーション要件やアルゴリズム規格に柔軟に対応でき、ハードウェアを変更しなくてもあらゆるワークロードを加速できる上に、総保有コスト (TCO) を削減できます。

Alveo アクセラレータ カードの利用は、一般的なデータセンター ワークロード向けにザイリンクスおよびパートナーが提供するアプリケーションの広範なエコシステムでサポートされています。カスタム ソリューションを構築する場合は、アプリケーション開発者ツール (SDAccel™ ツール) および Machine Learning Suite を利用することで、差別化したアプリケーションを市場へ送り出すことができます。

※このカードはPassive(ファンレス)設計であり、高い冷却性能を有する筐体への搭載を前提としています。

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

また、integer SPECrate2017_int_base や FlotingPoint SPECrate2017_int_base 、LINPAC などベンチマークでは第2世代Xeon Scalable Processor比で約1.46倍の性能向上を実現しています。

高信頼性エンタープライズストレージを搭載

さらにOS用のNVMeストレージもRAID-1で冗長化を施し障害に強い構成を実現しています。

信頼のハードウェアRAIDコントローラ

多様で高速なインターコネクトでスケールアウトも可能

安心のオンサイトサポート

2Uラックマウントの筐体に安定のintel製CPU Skylake-SP 第二世代Xeon® Scalable Family を搭載しました。ストレージべイは前後で合計12スロット装備し様々なRIADレベル 0, 1, 5, 6, 10,50,60 に対応。エンタープライズクラスの高信頼性ストレージとの組み合わせはミッションクリティカルなシーンでも安定した利用が可能です。インターコネクトも標準で10GBase-Tを2ポート、オプションでInfiniBand(EDR)も増設可能ですので、高速広帯域なノード間通信やフレキシブルなストレージ増設にも対応しています。

第3世代 インテル® Xeon® スケーラブル・プロセッサーを搭載

また、integer SPECrate2017_int_base や FlotingPoint SPECrate2017_int_base 、LINPAC などベンチマークでは第2世代Xeon Scalable Processor比で約1.46倍の性能向上を実現しています。

高信頼性エンタープライズストレージを搭載

信頼のハードウェアRAIDコントローラ

多様で高速なインターコネクトでスケールアウトも可能

安心のオンサイトサポート

安定のインテルXeonプロセッサを採用

解析、高速計算、シミュレーションなど高いマシンスペックを要求される仕事に納得のパフォーマンスを提供するハイスペックストレージシステムです

高信頼性エンタープライズストレージを搭載

さらにOS用のNVMeストレージもRAID-1で冗長化を施し障害に強い構成を実現しています。

信頼のハードウェアRAIDコントローラ

多様で高速なインターコネクトでスケールアウトも可能

安心のオンサイトサポート

安定のインテルXeonプロセッサを採用

解析、高速計算、シミュレーションなど高いマシンスペックを要求される仕事に納得のパフォーマンスを提供するハイスペックストレージシステムです

高信頼性エンタープライズストレージを搭載

さらにOS用のNVMeストレージもRAID-1で冗長化を施し障害に強い構成を実現しています。

信頼のハードウェアRAIDコントローラ

多様で高速なインターコネクトでスケールアウトも可能

安心のオンサイトサポート

2Uラックマウントの筐体に安定のintel製CPU Skylake-SP 第二世代Xeon® Scalable Family を搭載しました。ストレージべイは前後で合計12スロット装備し様々なRIADレベル 0, 1, 5, 6, 10,50,60 に対応。エンタープライズクラスの高信頼性ストレージとの組み合わせはミッションクリティカルなシーンでも安定した利用が可能です。インターコネクトも標準で10GBase-Tを2ポート、オプションでInfiniBand(EDR)も増設可能ですので、高速広帯域なノード間通信やフレキシブルなストレージ増設にも対応しています。

第三世代 Intel® Xeon® Scalable processors (Ice Lake -SP)搭載

第三世代 Intel® Xeon® Scalable processors (Ice Lake -SP)は AVX512に新しいSIMD命令を追加し、ソフトウェアやアルゴリズムの改善により、前世代のCascade Lakeから1.5~8倍のパフォーマンス向上が図られています。2ソケットで最大80コア/160スレッドを実現し全世代と比較して1.74倍のAI性能向上を実現します。

※性能は使用状況、構成、その他要因によって異なります。詳しくは弊社までお問い合わせ下さい。

高信頼性エンタープライズストレージを搭載

信頼のハードウェアRAIDコントローラ

多様で高速なインターコネクトでスケールアウトも可能

安心のオンサイトサポート

2Uラックマウントの筐体に安定のintel製CPU Skylake-SP 第二世代Xeon® Scalable Family を搭載しました。ストレージべイは前後で合計12スロット装備し様々なRIADレベル 0, 1, 5, 6, 10,50,60 に対応。エンタープライズクラスの高信頼性ストレージとの組み合わせはミッションクリティカルなシーンでも安定した利用が可能です。インターコネクトも標準で10GBase-Tを2ポート、オプションでInfiniBand(EDR)も増設可能ですので、高速広帯域なノード間通信やフレキシブルなストレージ増設にも対応しています。

安定のインテルXeonプロセッサを採用

解析、高速計算、シミュレーションなど高いマシンスペックを要求される仕事に納得のパフォーマンスを提供するハイスペックストレージシステムです

高信頼性エンタープライズストレージを搭載

信頼のハードウェアRAIDコントローラ

多様で高速なインターコネクトでスケールアウトも可能

安心のオンサイトサポート

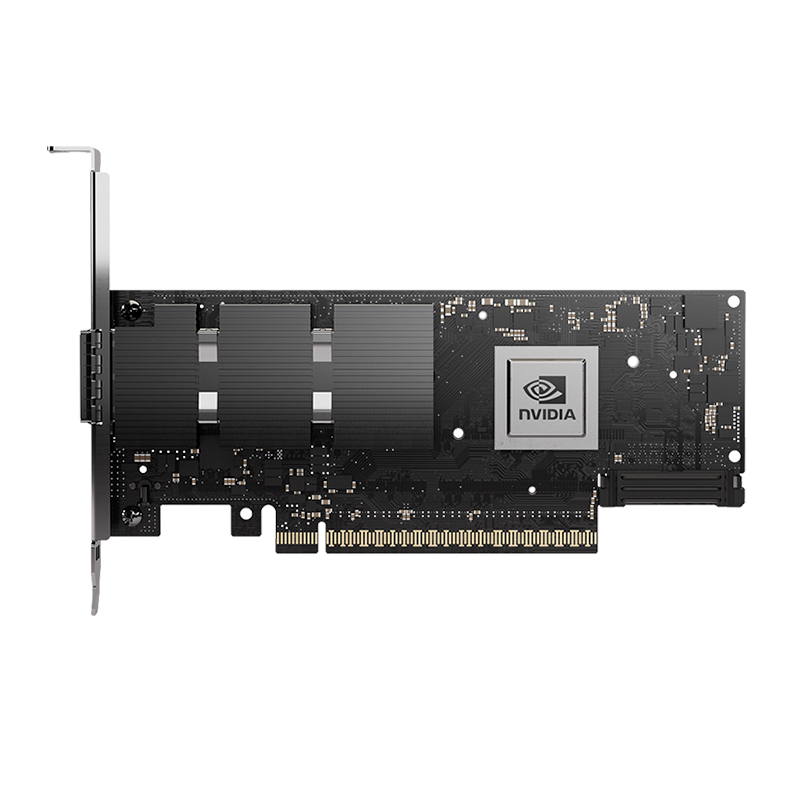

200GHDR対応カード:NVIDIA Mellanox ConnectX-6 アダプタカードは、NVIDIA Mellanox スマート・インターコネクトスイートの最新製品です。協調設計(Co-Design)、「In-Network Compute」のサポートしています。、HPC環境、クラウド、データ分析、ストレージプラットフォームにおいて最適化、高速通信が可能なカードです。

| ConnectX-6 VPI | Single/Dual-Port 200Gb/s Adapter Card with Virtual Protocol Interconnect |

| INFINIBAND | ・HDR /HDR100 /EDR / FDR / QDR / DDR / SDR ・IBTA仕様1.3 準拠 ・RDMA、Send/Receive semantics ・ハードウェアベースの輻輳制御 ・アトミック操作 ・1,600万I/O チャネル ・256 to 4Kバイト MTU、2Gバイトメッセージ ・8 仮想レーン + VL15 |

| ETHERNET | ・200GbE/ 100GbE/ 50GbE/ 40GbE/ 25GbE/ 10GbE/ 1GbE (詳細はブローシャ参照) |

| 強化機能 | (詳細はブローシャ参照) |

| CPU オフロード | ・RDMA over Converged Ethernet (RoCE) ・TCP/UDP/IP ステートレスオフロード ・LSO、LRO、チェックサムオフロード ・(カプセル化されたパケットを含めた)RSS、TSS、HDS、VLANおよびMPLS tag insertion / stripping、Receive flow steering、Receive flow steering ・カーネル・バイパス・アプリケーションのためのData Plane Development Kit (DPDK) ・ASAP2を活用する、Open VSwitch (OVS) オフロード ・Flexible match-action flow tables ・トンネリング カプセル化 / カプセル化解除 ・Intelligent interrupt coalescence ・NATルータのハードウェア・オフロードをサポートするヘッダの書き換え |

| ストレージオフロード | ・ブロックーレベル暗号化:XTS-AES 256/512ビットキー ・ターゲット機器のためのNVMe over Fabricsオフロード ・リードソロモン演算をオフロードする、イレイジャーコーディング(Erasure Coding)オフロード ・T10 DIF - 入力および出力トラフィックのワイヤースピードでのシグネチャーハンドオーバー操作 ・ストレージプロトコル: ・SRP, iSER, NFS RDMA, SMB Direct, NVMe-oF |

| オーバーレイ ネットワーク |

・オーバーレイネットワークを介したRoCE ・オーバーレイネットワークのトンネリングプロトコルのためのステートレスオフロード ・VXLAN、NVGRE、およびGENEVEオーバーレイネットワークのカプセル化とカプセル化解除のハードウェア・オフロード |

| ハードウェアベースの I/O仮想化 |

・Single Root IOV ・Address translation and protection ・VMware NetQueue support ・SR-IOV:最大512 仮想機能 ・SR-IOV:ホスト毎に最大16 の物理機能 ・仮想化階層(別名 NPAR) ・物理ポート上の物理機能の仮想化 ・すべての物理機能上のSR-IOV ・設定可能でユーザがプログラム可能なOoS ・VMのための保証されたQoS |

| HPC ソフトウェア ライブラリ |

・HPC-X、Open MPI、 MVAPICH、MPICH、Open SHMEM, PGAS 及び様々なコマーシャルパッケージ |

| 管理とコントロール | ・NC-SI、MCTP over SMBus と MCTP over PCIe - ベースボード管理コントローラインターフェイス ・モニタおよび制御用のPLDM DSP0248 ・ファームウェア更新用のPLDM DSP0267 ・eSwitchを管理するためのSDN 管理インターフェイス ・デバイス制御と設定のためのI2C インターフェイス ・General Purpose I/O ピン ・FlashへのSPI インターフェイス ・JTAG IEEE 1149.1と IEEE 1149.6 |

| リモート起動 | ・InfiniBandを介したリモート起動 ・Ethernetを介したリモート起動 ・iSCSI を介したリモート起動 ・Unified Extensible Firmware Interface (UEFI) ・Pre-execution Environment (PXE) |

| パーツナンバー | InfiniBandで サポートされる 速度 (Gb/s) |

Ethernetで サポートされる 速度 (GbE) |

ポート数 | ケージ | PCI Express設定 |

|---|---|---|---|---|---|

| MCX653105A-ECAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25, 10 |

1 | QSFP56 | PCIe 3.0 x16 |

| MCX653106A-ECAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 2 | QSFP56 | PCIe 3.0 x16 |

| MCX653105A-HDAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 1 | QSFP56 | PCIe 3.0/4.0 x16 |

| MCX653106A-HDAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 2 | QSFP56 | PCIe 3.0/4.0 x16 |

| Socket Direct | |||||

| MCX653105A-EFAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 1 | QSFP56 | PCIe3.0/4.0 Socket Direct 2x8 in a row |

| MCX653106A-EFAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 2 | QSFP56 | PCIe3.0/4.0 Socket Direct 2x8 in a row |

| MCX654105A-HCAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 1 | QSFP56 | Socket Direct 2x PCIe3.0 x16 |

| MCX654106A-HCAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 2 | QSFP56 | Socket Direct 2x PCIe3.0 x16 |

| MCX654106A-ECAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 2 | QSFP56 | Socket Direct 2x PCIe3.0 x16 |

| OCP 3.0 | |||||

| MCX653435A-HDAI | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 1 | QSFP56 | OCP 3.0, with host management PCIe4.0 x16, Internal Lock |

| MCX653436A-HDAI | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 2 | QSFP56 | OCP 3.0, with host management PCIe4.0 x16, Internal Lock |

| MCX653435A-EDAI | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 1 | QSFP56 | OCP 3.0, with host management PCIe 3.0/4.0 x16, Internal Lock |

注:ブラケットなしの寸法は167.65mm x 68.90mmです。すべてのトール(背の高い)・ブラケットアダプタには、トール・ブラケットが取り付けられ、ショート・ブラケットが付属品として添付され出荷されます。l

200GHDR対応カード:NVIDIA Mellanox ConnectX-6 アダプタカードは、NVIDIA Mellanox スマート・インターコネクトスイートの最新製品です。協調設計(Co-Design)、「In-Network Compute」のサポートしています。、HPC環境、クラウド、データ分析、ストレージプラットフォームにおいて最適化、高速通信が可能なカードです。

| ConnectX-6 VPI | Single/Dual-Port 200Gb/s Adapter Card with Virtual Protocol Interconnect |

| INFINIBAND | ・HDR /HDR100 /EDR / FDR / QDR / DDR / SDR ・IBTA仕様1.3 準拠 ・RDMA、Send/Receive semantics ・ハードウェアベースの輻輳制御 ・アトミック操作 ・1,600万I/O チャネル ・256 to 4Kバイト MTU、2Gバイトメッセージ ・8 仮想レーン + VL15 |

| ETHERNET | ・200GbE/ 100GbE/ 50GbE/ 40GbE/ 25GbE/ 10GbE/ 1GbE (詳細はブローシャ参照) |

| 強化機能 | (詳細はブローシャ参照) |

| CPU オフロード | ・RDMA over Converged Ethernet (RoCE) ・TCP/UDP/IP ステートレスオフロード ・LSO、LRO、チェックサムオフロード ・(カプセル化されたパケットを含めた)RSS、TSS、HDS、VLANおよびMPLS tag insertion / stripping、Receive flow steering、Receive flow steering ・カーネル・バイパス・アプリケーションのためのData Plane Development Kit (DPDK) ・ASAP2を活用する、Open VSwitch (OVS) オフロード ・Flexible match-action flow tables ・トンネリング カプセル化 / カプセル化解除 ・Intelligent interrupt coalescence ・NATルータのハードウェア・オフロードをサポートするヘッダの書き換え |

| ストレージオフロード | ・ブロックーレベル暗号化:XTS-AES 256/512ビットキー ・ターゲット機器のためのNVMe over Fabricsオフロード ・リードソロモン演算をオフロードする、イレイジャーコーディング(Erasure Coding)オフロード ・T10 DIF - 入力および出力トラフィックのワイヤースピードでのシグネチャーハンドオーバー操作 ・ストレージプロトコル: ・SRP, iSER, NFS RDMA, SMB Direct, NVMe-oF |

| オーバーレイ ネットワーク |

・オーバーレイネットワークを介したRoCE ・オーバーレイネットワークのトンネリングプロトコルのためのステートレスオフロード ・VXLAN、NVGRE、およびGENEVEオーバーレイネットワークのカプセル化とカプセル化解除のハードウェア・オフロード |

| ハードウェアベースの I/O仮想化 |

・Single Root IOV ・Address translation and protection ・VMware NetQueue support ・SR-IOV:最大512 仮想機能 ・SR-IOV:ホスト毎に最大16 の物理機能 ・仮想化階層(別名 NPAR) ・物理ポート上の物理機能の仮想化 ・すべての物理機能上のSR-IOV ・設定可能でユーザがプログラム可能なOoS ・VMのための保証されたQoS |

| HPC ソフトウェア ライブラリ |

・HPC-X、Open MPI、 MVAPICH、MPICH、Open SHMEM, PGAS 及び様々なコマーシャルパッケージ |

| 管理とコントロール | ・NC-SI、MCTP over SMBus と MCTP over PCIe - ベースボード管理コントローラインターフェイス ・モニタおよび制御用のPLDM DSP0248 ・ファームウェア更新用のPLDM DSP0267 ・eSwitchを管理するためのSDN 管理インターフェイス ・デバイス制御と設定のためのI2C インターフェイス ・General Purpose I/O ピン ・FlashへのSPI インターフェイス ・JTAG IEEE 1149.1と IEEE 1149.6 |

| リモート起動 | ・InfiniBandを介したリモート起動 ・Ethernetを介したリモート起動 ・iSCSI を介したリモート起動 ・Unified Extensible Firmware Interface (UEFI) ・Pre-execution Environment (PXE) |

| パーツナンバー | InfiniBandで サポートされる 速度 (Gb/s) |

Ethernetで サポートされる 速度 (GbE) |

ポート数 | ケージ | PCI Express設定 |

|---|---|---|---|---|---|

| MCX653105A-ECAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25, 10 |

1 | QSFP56 | PCIe 3.0 x16 |

| MCX653106A-ECAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 2 | QSFP56 | PCIe 3.0 x16 |

| MCX653105A-HDAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 1 | QSFP56 | PCIe 3.0/4.0 x16 |

| MCX653106A-HDAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 2 | QSFP56 | PCIe 3.0/4.0 x16 |

| Socket Direct | |||||

| MCX653105A-EFAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 1 | QSFP56 | PCIe3.0/4.0 Socket Direct 2x8 in a row |

| MCX653106A-EFAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 2 | QSFP56 | PCIe3.0/4.0 Socket Direct 2x8 in a row |

| MCX654105A-HCAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 1 | QSFP56 | Socket Direct 2x PCIe3.0 x16 |

| MCX654106A-HCAT | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 2 | QSFP56 | Socket Direct 2x PCIe3.0 x16 |

| MCX654106A-ECAT | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 2 | QSFP56 | Socket Direct 2x PCIe3.0 x16 |

| OCP 3.0 | |||||

| MCX653435A-HDAI | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 1 | QSFP56 | OCP 3.0, with host management PCIe4.0 x16, Internal Lock |

| MCX653436A-HDAI | HDR, HDR100, EDR, FDR, QDR, DDR, SDR | 200,100,50,40,25,10 | 2 | QSFP56 | OCP 3.0, with host management PCIe4.0 x16, Internal Lock |

| MCX653435A-EDAI | HDR100, EDR, FDR, QDR, DDR, SDR | 100,50,40,25,10 | 1 | QSFP56 | OCP 3.0, with host management PCIe 3.0/4.0 x16, Internal Lock |

注:ブラケットなしの寸法は167.65mm x 68.90mmです。すべてのトール(背の高い)・ブラケットアダプタには、トール・ブラケットが取り付けられ、ショート・ブラケットが付属品として添付され出荷されます。l

NVIDIAエリートパートナ ジーデップ・アドバンスはGTC2022で発表された 最新ハイエンドGPU NVIDIA® RTX™ A5500 の取り扱いを開始しました。

※ジーデップ・アドバンスなら購入はもちろん 長期レンタルでもトータルコストが大きく変わらずおトクです。

NVIDIA RTX™ A5500 グラフィックス カードでデスクトップ PC のパワーを開放しよう。高い処理能力が要求されるマルチアプリケーション ワークフローに必要なパフォーマンス、信頼性、機能を提供します。NVIDIA Ampere アーキテクチャに基づいて構築され、24GBのGPUメモリを搭載したこのカードは、デザイナー、エンジニア、サイエンティスト、アーティストの無限の創造力に必要なものをすべて備えています。

【NVIDIA RTX製品比較】

| RTX A6000 | RTX A5500 | RTX A5000 | RTX A4500 | RTX A4000 |

| Ampere | Ampere | Ampere | Ampere | Ampere |

| 48GB GDDR6 | 24GB GDDR6 | 24GB GDDR6 | 20GB GDDR6 | 16GB GDDR6 |

| 最大768GB/s | 最大768GB/s | 最大768GB/s | 最大640GB/s | 最大512GB/s |

| 384bit | 384bit | 384bit | 384bit | 384bit |

| 10752 CUDAコア | 10240 CUDAコア | 8192 CUDAコア | 7168 CUDAコア | 6144 CUDAコア |

| 336 Tensorコア | 320 Tensorコア | 256 Tensorコア | 224 Tensorコア | 192 Tensorコア |

| 84 RTコア | 80 RTコア | 64 RTコア | 56 RTコア | 48 RTコア |

| PCI Express 4.0 x16 | PCI Express 4.0 x16 | PCI Express 4.0 x16 | PCI Express 4.0 x16 | PCI Express 4.0 x16 |

| NVLink対応 | NVLink対応 | NVLink対応 | NVLink 対応 | NVLink 非対応 |

| TDP 300W | TDP 230W | TDP 230W | TDP 200W | TDP 140W |

| アクティブ冷却 | アクティブ冷却 | アクティブ冷却 | アクティブ冷却 | アクティブ冷却 |

※NVIDIA RTX A5500、RTXシリーズ搭載のGPUワークステーションも特別価格でご提供しています。

-国内正規流通品について-

NVIDIA認定パートナー ジーデップ・アドバンスが扱っているNVIDIA社製GPUカードは全て「国内正規流通品」です。並行輸入品や組込向けのバルク品ではありません。並行輸入品には国内代理店の保証書が添付されておらず国内での保証修理が受けられません。そのため修理や交換に通常よりも長い時間を要します。またメーカー出荷時から時間が経過しており保証期間が短くなっている場合が多く、販売店が独自で交換保証を付ける等の対応を行っているケースもあります。

加えて並行輸入品は以下の様な正規代理店対応も受けられませんのでご注意下さい。

・輸出関連資料の対応 非該当判定用パラメーターシートや米国輸出関連資料作成

・環境物質資料の対応 RoHS2,REACH,SVHC その他大学研究機関定型形式での資料作成

・紛争鉱物(コンフリクトミネラル)調査資料の対応

・ドライバーのバグなどクリティカルな不具合に関するメーカーリレーションとその対応

ご購入の際には安心の国内正規流通品をお勧め致します。

NVIDIAエリートパートナ ジーデップ・アドバンスはGTC2022で発表された 最新ハイエンドGPU NVIDIA® RTX™ A5500 の取り扱いを開始しました。

※ジーデップ・アドバンスなら購入はもちろん 長期レンタルでもトータルコストが大きく変わらずおトクです。

NVIDIA RTX™ A5500 グラフィックス カードでデスクトップ PC のパワーを開放しよう。高い処理能力が要求されるマルチアプリケーション ワークフローに必要なパフォーマンス、信頼性、機能を提供します。NVIDIA Ampere アーキテクチャに基づいて構築され、24GBのGPUメモリを搭載したこのカードは、デザイナー、エンジニア、サイエンティスト、アーティストの無限の創造力に必要なものをすべて備えています。

【NVIDIA RTX製品比較】

| RTX A6000 | RTX A5500 | RTX A5000 | RTX A4500 | RTX A4000 |

| Ampere | Ampere | Ampere | Ampere | Ampere |

| 48GB GDDR6 | 24GB GDDR6 | 24GB GDDR6 | 20GB GDDR6 | 16GB GDDR6 |

| 最大768GB/s | 最大768GB/s | 最大768GB/s | 最大640GB/s | 最大512GB/s |

| 384bit | 384bit | 384bit | 384bit | 384bit |

| 10752 CUDAコア | 10240 CUDAコア | 8192 CUDAコア | 7168 CUDAコア | 6144 CUDAコア |

| 336 Tensorコア | 320 Tensorコア | 256 Tensorコア | 224 Tensorコア | 192 Tensorコア |

| 84 RTコア | 80 RTコア | 64 RTコア | 56 RTコア | 48 RTコア |

| PCI Express 4.0 x16 | PCI Express 4.0 x16 | PCI Express 4.0 x16 | PCI Express 4.0 x16 | PCI Express 4.0 x16 |

| NVLink対応 | NVLink対応 | NVLink対応 | NVLink 対応 | NVLink 非対応 |

| TDP 300W | TDP 230W | TDP 230W | TDP 200W | TDP 140W |

| アクティブ冷却 | アクティブ冷却 | アクティブ冷却 | アクティブ冷却 | アクティブ冷却 |

※NVIDIA RTX A5500、RTXシリーズ搭載のGPUワークステーションも特別価格でご提供しています。

-国内正規流通品について-

NVIDIA認定パートナー ジーデップ・アドバンスが扱っているNVIDIA社製GPUカードは全て「国内正規流通品」です。並行輸入品や組込向けのバルク品ではありません。並行輸入品には国内代理店の保証書が添付されておらず国内での保証修理が受けられません。そのため修理や交換に通常よりも長い時間を要します。またメーカー出荷時から時間が経過しており保証期間が短くなっている場合が多く、販売店が独自で交換保証を付ける等の対応を行っているケースもあります。

加えて並行輸入品は以下の様な正規代理店対応も受けられませんのでご注意下さい。

・輸出関連資料の対応 非該当判定用パラメーターシートや米国輸出関連資料作成

・環境物質資料の対応 RoHS2,REACH,SVHC その他大学研究機関定型形式での資料作成

・紛争鉱物(コンフリクトミネラル)調査資料の対応

・ドライバーのバグなどクリティカルな不具合に関するメーカーリレーションとその対応

ご購入の際には安心の国内正規流通品をお勧め致します。

納期目安:こちらの製品は現在在庫がございます。

※ご注意点

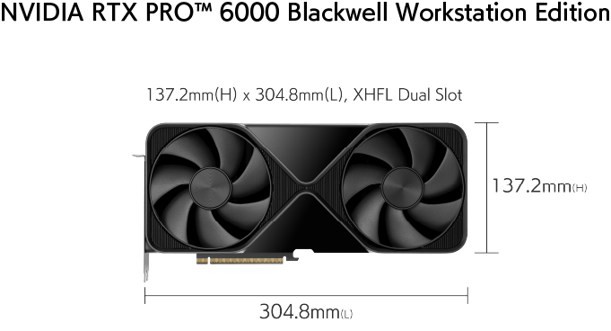

RTX 6000 Ada は従来のRTXシリーズとは異なり、電源供給が16ピン(CEM-5 PCIeコネクタ)となります。ジーデップ・アドバンスでは、既存のPCI-Express8ピン x2本 を PCI-Express CEM5 16ピン x1本へ変換するアダプタを標準添付しています。利用予定のマシンに PCI-Express8ピン x2本 があることをご確認下さい。

詳しい形状は弊社Twitterからご覧いただけます。

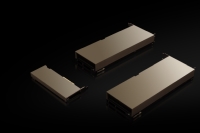

NVIDIA認定 エリートパートナー ジーデップ・アドバンスは最新ハイエンドGPU NVIDIA RTX™ 6000 Ada を特別価格でご提供します。さらにジーデップ・アドバンスのオリジナルレンタルなら購入時と比較してもトータルコストが大きく変わらずおトクです。

アカデミックユーザー 様/「NVIDIA Inception Program」パートナー企業 様向け「ドラゴンブーストキャンペーン」

【価格】¥999,900-(税込み・送料込み)

2022年9月開催のNVIDIA GTC 2022 秋において「NVIDIA RTX™ 6000 Ada」が発表されました。NVIDIA RTX A6000 Adaは NVIDIA Ada Lovelaceアーキテクチャを採用したワークステーション向けGPUです。第3世代の RT コア、第4世代の Tensor コア、次世代 CUDA® コアを 48GB の広帯域GDDR6メモリと組み合わせることにより、かつてないコンピューティング パフォーマンスを実現します。

NVIDIA RTX 6000 Ada は、前世代となるNVIDIA RTX A6000と比較して約2倍の性能パフォーマンスを提供し、レンダリング、グラフィックス、AI、NVIDIA Omniverseを使ったコンテンツ制作など、開発や研究をさらに加速します。

RTX 6000 Ada のパフォーマンスベンチはこちらを御覧ください。

【NVIDIA ハイエンドGPU製品比較】

| RTX 6000 Ada | RTX A6000 | RTX A5500 | RTX A5000 | RTX A4500 | RTX A4000 | |

| アーキテクチャ | Ada Lovelace | Ampere | Ampere | Ampere | Ampere | Ampere |

| メモリ容量 | 48GB GDDR6 | 48GB GDDR6 | 24GB GDDR6 | 24GB GDDR6 | 20GB GDDR6 | 16GB GDDR6 |

| メモリ帯域 | 最大960GB/s | 最大768GB/s | 最大768GB/s | 最大768GB/s | 最大640GB/s | 最大512GB/s |

| メモリバス幅 | 384bit | 384bit | 384bit | 384bit | 384bit | 384bit |

| CUDAコア数 | 18176 | 10752 | 10240 | 8192 | 7168 | 6144 |

| Tensorコア数 | 568 | 336 | 320 | 256 | 224 | 192 |

| RTコア数 | 142 | 84 | 80 | 64 | 56 | 48 |

| インターフェース | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 |

| NVLink | 非対応 | 対応 | 対応 | 対応 | 対応 | 非対応 |

| 熱設計電力(TDP) | 300W | 300W | 230W | 230W | 200W | 140W |

| 冷却方法 | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ |

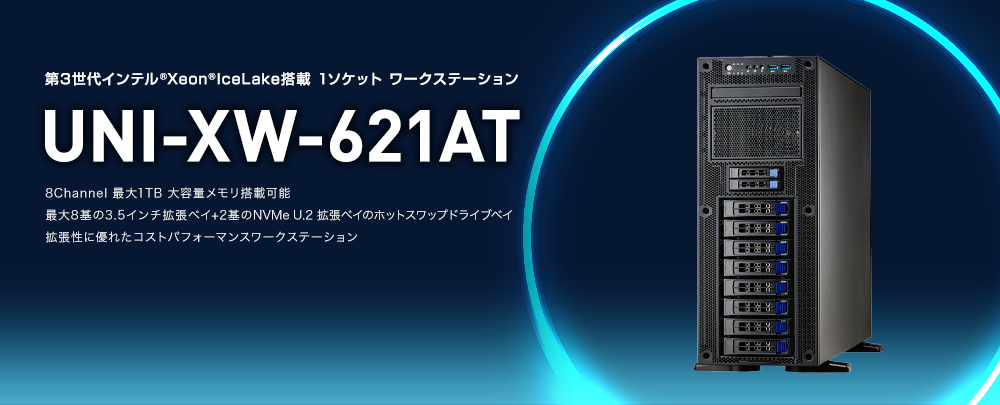

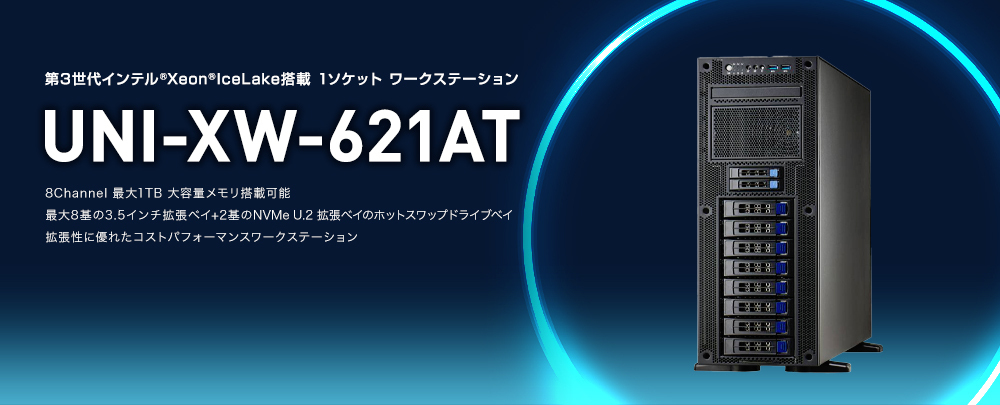

※NVIDIA RTX 6000 Ada 搭載のGPUワークステーション「GWS-TRP/4G」「GWS-621XW/4G」「UNI-XW-621AT」も特別価格でご提供しています。

-国内正規流通品について-

NVIDIA認定パートナー ジーデップ・アドバンスが扱っているNVIDIA社製GPUカードは全て「国内正規流通品」です。並行輸入品や組込向けのバルク品ではありません。並行輸入品には国内でのシリアル管理が行われておらず日本での保証修理が受けられません。そのため修理や交換に通常よりも長い時間を要します。またメーカー出荷時から時間が経過しており保証期間が短くなっている場合が多く、販売店が独自で交換保証を付ける等の対応を行っているケースもあります。

加えて並行輸入品は以下の様な正規代理店対応も受けられませんのでご注意下さい。

・輸出関連資料の対応 非該当判定用パラメーターシートや米国輸出関連資料作成

・環境物質資料の対応 RoHS2,REACH,SVHC その他大学研究機関定型形式での資料作成

・紛争鉱物(コンフリクトミネラル)調査資料の対応

・ドライバーのバグなどクリティカルな不具合に関するメーカーリレーションとその対応

ご購入の際には安心の国内正規流通品をお勧め致します。

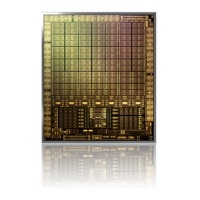

新コアAda Lovelace AD102

Ada Lovelaceアーキテクチャは、2018年に発表されたTuring(チューリング)、2020年に投入されたAmpere(アンペア)に続く同社がRTXと呼んでいるハードウエア・レイトレーシングのエンジン(RTコア)を内蔵したGPUアーキテクチャの第3世代となります。(NVIDIA GPUの開発コードネームは過去の科学者の名前に基づいており、今回のAda Lovelaceも、世界初のコンピュータプログラマーとして知られる19世紀のイギリスの数学者の名前が元になっています)

Ada Lovelaceの最大の特徴は、NVIDIAがGPC、TPC、SM、CUDAコアと呼んでいる演算器がいずれも増えていることあり、AmpereではGPCが最大7基だったのに対して、Ada Lovelaceでは最大12基に増加しています。これはTuring世代に比べると倍、Ampere世代に比較すると71%も増えていることになり、それに比例してTPCも、SMも、CUDAコアも71%増加しており大きな性能向上が期待できます。

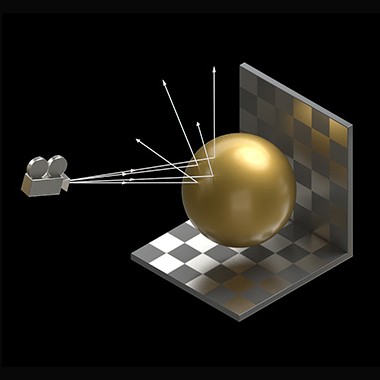

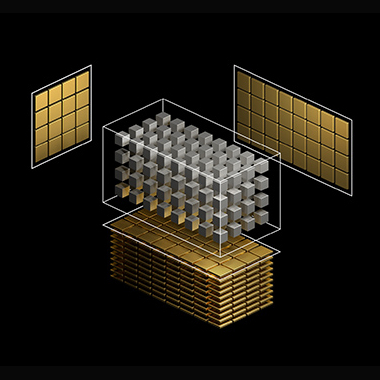

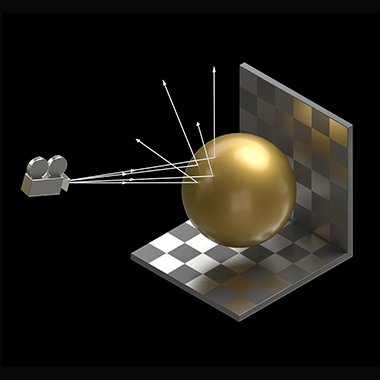

第4世代Tensorコア

NVIDIA RTX 6000 Adaは、NVIDIA Tensor コアは、NVIDIA DLSS や、新しいフレーム レートの飛躍技術 NVIDIA DLSS 3 などの革新的な AI 技術の実現と高速化を担います。

Ada の新しい第 4 世代 Tensor コアは、NVIDIA の Hopper H100 データセンター GPU で初めて導入された、新しい FP8 Transformer エンジンを使用して、驚異的に速い、最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。

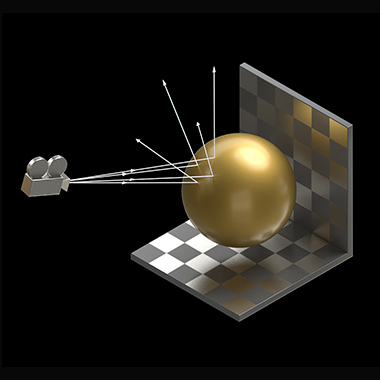

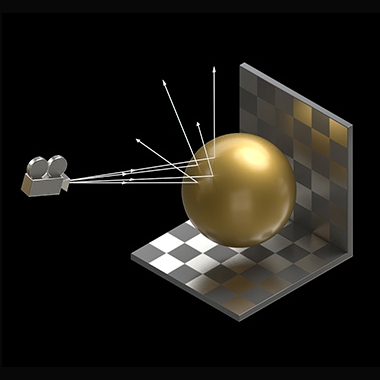

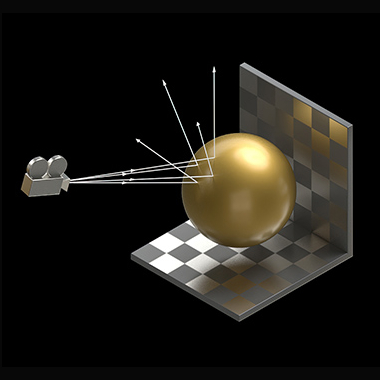

第 3 世代の RT コア

Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。

新しい RT コアには、新しい Opacity Micromap (OMM) エンジンと新しい Displaced Micro-Mesh (DMM) エンジンも含まれています。OMM エンジンは、葉、粒子、格子によく使用されるアルファテストされたテクスチャのレイ トレーシングをより高速に実現します。DMM エンジンは、バウンディング ボリューム階層 (BVH) の構築時間を最大 10 倍高速化し、容量を最大 20 倍削減することで、ジオメトリが複雑な場面のリアルタイム レイ トレーシングを実現します。

シェーダー実行リオーダー

シェーダー実行リオーダリング (SER) 技術は、以前は非効率だった処理を動的に再編成し、高効率の処理に変えます。SER はレイ トレーシング実行のためのシェーダー性能を最大 3 倍、ゲーム内フレーム レートを最大 25% 向上させることができます。

DLSS 3

※ご注意点

RTX 6000 Ada は従来のRTXシリーズとは異なり、電源供給が16ピン(CEM-5 PCIeコネクタ)となります。ジーデップ・アドバンスでは、既存のPCI-Express 8ピン ケーブル x2本をPCI-Express CEM5 16ピン ケーブル x1本へ変換するアダプタを標準添付していますが、搭載予定のマシンにPCI-Express 8ピン ケーブル x2本が追加可能であることをご確認下さい。

詳しい形状は弊社Twitterからご覧いただけます。

2022年9月開催のNVIDIA GTC 2022 秋において「NVIDIA RTX™ 6000 Ada」が発表されました。NVIDIA RTX A6000 Adaは NVIDIA Ada Lovelaceアーキテクチャを採用したワークステーション向けGPUです。第3世代の RT コア、第4世代の Tensor コア、次世代 CUDA® コアを 48GB の広帯域GDDR6メモリと組み合わせることにより、かつてないコンピューティング パフォーマンスを実現します。

NVIDIA RTX 6000 Ada は、前世代となるNVIDIA RTX A6000と比較して約2倍の性能パフォーマンスを提供し、レンダリング、グラフィックス、AI、NVIDIA Omniverseを使ったコンテンツ制作など、開発や研究をさらに加速します。

RTX 6000 Ada のパフォーマンスベンチはこちらを御覧ください。

【NVIDIA ハイエンドGPU製品比較】

| RTX 6000 Ada | RTX A6000 | RTX A5500 | RTX A5000 | RTX A4500 | RTX A4000 | |

| アーキテクチャ | Ada Lovelace | Ampere | Ampere | Ampere | Ampere | Ampere |

| メモリ容量 | 48GB GDDR6 | 48GB GDDR6 | 24GB GDDR6 | 24GB GDDR6 | 20GB GDDR6 | 16GB GDDR6 |

| メモリ帯域 | 最大960GB/s | 最大768GB/s | 最大768GB/s | 最大768GB/s | 最大640GB/s | 最大512GB/s |

| メモリバス幅 | 384bit | 384bit | 384bit | 384bit | 384bit | 384bit |

| CUDAコア数 | 18176 | 10752 | 10240 | 8192 | 7168 | 6144 |

| Tensorコア数 | 568 | 336 | 320 | 256 | 224 | 192 |

| RTコア数 | 142 | 84 | 80 | 64 | 56 | 48 |

| インターフェース | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 |

| NVLink | 非対応 | 対応 | 対応 | 対応 | 対応 | 非対応 |

| 熱設計電力(TDP) | 300W | 300W | 230W | 230W | 200W | 140W |

| 冷却方法 | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ |

※NVIDIA RTX 6000 Ada 搭載のGPUワークステーション「DeepLearningBOXIII」「GWS-741SI4U4G」「GWS-i9XG」も特別価格でご提供しています。

-国内正規流通品について-

NVIDIA認定パートナー ジーデップ・アドバンスが扱っているNVIDIA社製GPUカードは全て「国内正規流通品」です。並行輸入品や組込向けのバルク品ではありません。並行輸入品には国内でのシリアル管理が行われておらず日本での保証修理が受けられません。そのため修理や交換に通常よりも長い時間を要します。またメーカー出荷時から時間が経過しており保証期間が短くなっている場合が多く、販売店が独自で交換保証を付ける等の対応を行っているケースもあります。

加えて並行輸入品は以下の様な正規代理店対応も受けられませんのでご注意下さい。

・輸出関連資料の対応 非該当判定用パラメーターシートや米国輸出関連資料作成

・環境物質資料の対応 RoHS2,REACH,SVHC その他大学研究機関定型形式での資料作成

・紛争鉱物(コンフリクトミネラル)調査資料の対応

・ドライバーのバグなどクリティカルな不具合に関するメーカーリレーションとその対応

ご購入の際には安心の国内正規流通品をお勧め致します。

新コアAda Lovelace AD102

Ada Lovelaceアーキテクチャは、2018年に発表されたTuring(チューリング)、2020年に投入されたAmpere(アンペア)に続く同社がRTXと呼んでいるハードウエア・レイトレーシングのエンジン(RTコア)を内蔵したGPUアーキテクチャの第3世代となります。(NVIDIA GPUの開発コードネームは過去の科学者の名前に基づいており、今回のAda Lovelaceも、世界初のコンピュータプログラマーとして知られる19世紀のイギリスの数学者の名前が元になっています。)

Ada Lovelaceの最大の特徴は、NVIDIAがGPC、TPC、SM、CUDAコアと呼んでいる演算器がいずれも増えていることあり、AmpereではGPCが最大7基だったのに対して、Ada Lovelaceでは最大12基に増加しています。これはTuring世代に比べると倍、Ampere世代に比較すると71%も増えていることになり、それに比例してTPCも、SMも、CUDAコアも71%増加しており大きな性能向上が期待できます。

第4世代Tensorコア

NVIDIA RTX 6000 Adaは、NVIDIA Tensor コアは、NVIDIA DLSS や、新しいフレーム レートの飛躍技術 NVIDIA DLSS 3 などの革新的な AI 技術の実現と高速化を担います。

Ada の新しい第 4 世代 Tensor コアは、NVIDIA の Hopper H100 データセンター GPU で初めて導入された、新しい FP8 Transformer エンジンを使用して、驚異的に速い、最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。

第 3 世代の RT コア

Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。

新しい RT コアには、新しい Opacity Micromap (OMM) エンジンと新しい Displaced Micro-Mesh (DMM) エンジンも含まれています。OMM エンジンは、葉、粒子、格子によく使用されるアルファテストされたテクスチャのレイ トレーシングをより高速に実現します。DMM エンジンは、バウンディング ボリューム階層 (BVH) の構築時間を最大 10 倍高速化し、容量を最大 20 倍削減することで、ジオメトリが複雑な場面のリアルタイム レイ トレーシングを実現します。

シェーダー実行リオーダー

シェーダー実行リオーダリング (SER) 技術は、以前は非効率だった処理を動的に再編成し、高効率の処理に変えます。SER はレイ トレーシング実行のためのシェーダー性能を最大 3 倍、ゲーム内フレーム レートを最大 25% 向上させることができます。

DLSS 3

納期目安:こちらの製品は現在在庫がございます。

※ご注意点

RTX 6000 Ada は従来のRTXシリーズとは異なり、電源供給が16ピン(CEM-5 PCIeコネクタ)となります。ジーデップ・アドバンスでは、既存のPCI-Express8ピン x2本 を PCI-Express CEM5 16ピン x1本へ変換するアダプタを標準添付しています。利用予定のマシンに PCI-Express8ピン x2本 があることをご確認下さい。

詳しい形状は弊社Twitterからご覧いただけます。

NVIDIA認定 エリートパートナー ジーデップ・アドバンスは最新ハイエンドGPU NVIDIA RTX™ 6000 Ada を特別価格でご提供します。さらにジーデップ・アドバンスのオリジナルレンタルなら購入時と比較してもトータルコストが大きく変わらずおトクです。

アカデミックユーザー 様/「NVIDIA Inception Program」パートナー企業 様向けキャンペーン価格

【価格】¥899,800-(税込み・送料込み) 24ケ月レンタル目安 月額¥38,691-

2022年9月開催のNVIDIA GTC 2022 秋において「NVIDIA RTX™ 6000 Ada」が発表されました。NVIDIA RTX A6000 Adaは NVIDIA Ada Lovelaceアーキテクチャを採用したワークステーション向けGPUです。第3世代の RT コア、第4世代の Tensor コア、次世代 CUDA® コアを 48GB の広帯域GDDR6メモリと組み合わせることにより、かつてないコンピューティング パフォーマンスを実現します。

NVIDIA RTX 6000 Ada は、前世代となるNVIDIA RTX A6000と比較して約2倍の性能パフォーマンスを提供し、レンダリング、グラフィックス、AI、NVIDIA Omniverseを使ったコンテンツ制作など、開発や研究をさらに加速します。

RTX 6000 Ada のパフォーマンスベンチはこちらを御覧ください。

【NVIDIA ハイエンドGPU製品比較】

| RTX 6000 Ada | RTX A6000 | RTX A5500 | RTX A5000 | RTX A4500 | RTX A4000 | |

| アーキテクチャ | Ada Lovelace | Ampere | Ampere | Ampere | Ampere | Ampere |

| メモリ容量 | 48GB GDDR6 | 48GB GDDR6 | 24GB GDDR6 | 24GB GDDR6 | 20GB GDDR6 | 16GB GDDR6 |

| メモリ帯域 | 最大960GB/s | 最大768GB/s | 最大768GB/s | 最大768GB/s | 最大640GB/s | 最大512GB/s |

| メモリバス幅 | 384bit | 384bit | 384bit | 384bit | 384bit | 384bit |

| CUDAコア数 | 18176 | 10752 | 10240 | 8192 | 7168 | 6144 |

| Tensorコア数 | 568 | 336 | 320 | 256 | 224 | 192 |

| RTコア数 | 142 | 84 | 80 | 64 | 56 | 48 |

| インターフェース | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 | PCIe Gen4 x16 |

| NVLink | 非対応 | 対応 | 対応 | 対応 | 対応 | 非対応 |

| 熱設計電力(TDP) | 300W | 300W | 230W | 230W | 200W | 140W |

| 冷却方法 | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ |

※NVIDIA RTX 6000 Ada 搭載のGPUワークステーション「GWS-TRP/4G」「GWS-621XW/4G」「UNI-XW-621AT」「GWS-i9/2G」も特別価格でご提供しています。

-国内正規流通品について-

NVIDIA認定パートナー ジーデップ・アドバンスが扱っているNVIDIA社製GPUカードは全て「国内正規流通品」です。並行輸入品や組込向けのバルク品ではありません。並行輸入品には国内でのシリアル管理が行われておらず日本での保証修理が受けられません。そのため修理や交換に通常よりも長い時間を要します。またメーカー出荷時から時間が経過しており保証期間が短くなっている場合が多く、販売店が独自で交換保証を付ける等の対応を行っているケースもあります。

加えて並行輸入品は以下の様な正規代理店対応も受けられませんのでご注意下さい。

・輸出関連資料の対応 非該当判定用パラメーターシートや米国輸出関連資料作成

・環境物質資料の対応 RoHS2,REACH,SVHC その他大学研究機関定型形式での資料作成

・紛争鉱物(コンフリクトミネラル)調査資料の対応

・ドライバーのバグなどクリティカルな不具合に関するメーカーリレーションとその対応

ご購入の際には安心の国内正規流通品をお勧め致します。

新コアAda Lovelace AD102

Ada Lovelaceアーキテクチャは、2018年に発表されたTuring(チューリング)、2020年に投入されたAmpere(アンペア)に続く同社がRTXと呼んでいるハードウエア・レイトレーシングのエンジン(RTコア)を内蔵したGPUアーキテクチャの第3世代となります。(NVIDIA GPUの開発コードネームは過去の科学者の名前に基づいており、今回のAda Lovelaceも、世界初のコンピュータプログラマーとして知られる19世紀のイギリスの数学者の名前が元になっています。)

Ada Lovelaceの最大の特徴は、NVIDIAがGPC、TPC、SM、CUDAコアと呼んでいる演算器がいずれも増えていることあり、AmpereではGPCが最大7基だったのに対して、Ada Lovelaceでは最大12基に増加しています。これはTuring世代に比べると倍、Ampere世代に比較すると71%も増えていることになり、それに比例してTPCも、SMも、CUDAコアも71%増加しており大きな性能向上が期待できます。

第4世代Tensorコア

NVIDIA RTX 6000 Adaは、NVIDIA Tensor コアは、NVIDIA DLSS や、新しいフレーム レートの飛躍技術 NVIDIA DLSS 3 などの革新的な AI 技術の実現と高速化を担います。

Ada の新しい第 4 世代 Tensor コアは、NVIDIA の Hopper H100 データセンター GPU で初めて導入された、新しい FP8 Transformer エンジンを使用して、驚異的に速い、最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。

第 3 世代の RT コア

Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。

新しい RT コアには、新しい Opacity Micromap (OMM) エンジンと新しい Displaced Micro-Mesh (DMM) エンジンも含まれています。OMM エンジンは、葉、粒子、格子によく使用されるアルファテストされたテクスチャのレイ トレーシングをより高速に実現します。DMM エンジンは、バウンディング ボリューム階層 (BVH) の構築時間を最大 10 倍高速化し、容量を最大 20 倍削減することで、ジオメトリが複雑な場面のリアルタイム レイ トレーシングを実現します。

シェーダー実行リオーダー

シェーダー実行リオーダリング (SER) 技術は、以前は非効率だった処理を動的に再編成し、高効率の処理に変えます。SER はレイ トレーシング実行のためのシェーダー性能を最大 3 倍、ゲーム内フレーム レートを最大 25% 向上させることができます。

DLSS 3

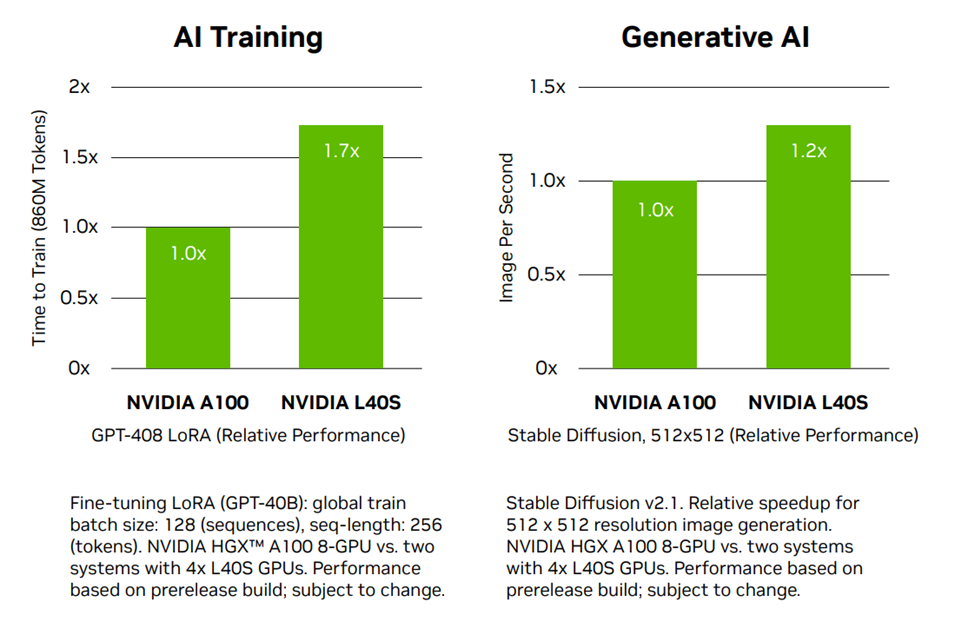

生成AIの爆発的な普及により、あらゆる業界で大規模なコンピューティングリソースを導入する必要性が高まっています。パフォーマンス、効率、ROI*[1]向上のため、現代のデータセンターには、複雑なワークロード、高速コンピューティング、グラフィックス、ビデオ処理機能を提供する技術が必要です。

NVIDIA L40Sは、データセンター向けの最も強力なユニバーサルGPUであり、推論とトレーニング、グラフィックス、およびビデオアプリケーションに対して高性能かつ高速な処理を実現します。マルチモーダル*[2]生成 AI のプレミアプラットフォームとして、推論、トレーニング、グラフィックス、ビデオワークフローのエンドtoエンドでの高速処理を可能にし、次世代の AI 対応オーディオ、音声、ビデオ、2Dおよび 3D アプリケーションを強化します。

*[1] Return On Investment(投資利益率)。事業や施策において、投下した資本に対しての収益性を図る指標のこと。

*[2] Multi(複数)とModal(様式)を組み合わせたコンピューター用語。さまざまな種類の情報を利用して高度な判断を行うAIを指す。

GPUリソースの安定確保にむけて

現在、世界的なGPUの急激な需要増加によってNVIDIA H100やNVIDIA A100などのデータセンターGPUの納期が非常に長期化している状況です。ジーデップ・アドバンスでは NVIDIA A100を凌駕したAIトレーニングパフォーマンスを誇る新製品 NVIDIA L40S を搭載した製品ラインナップを増強し、多彩なポートフォリオでお客様のご要望にお応えして参ります。

GPUリソースの安定確保にむけて

現在、世界的なGPUの急激な需要増加によってNVIDIA H100やNVIDIA A100などのデータセンターGPUの納期が非常に長期化している状況です。ジーデップ・アドバンスでは NVIDIA A100を凌駕したAIトレーニングパフォーマンスを誇る新製品 NVIDIA L40S を搭載した製品ラインナップを増強し、多彩なポートフォリオでお客様のご要望にお応えして参ります。

NVIDIA L40S 製品 仕様比較

|

L40S |

A100 80GB SXM |

|

|

GPU Architecture |

NVIDIA Ada Lovelace |

NVIDIA Ampere |

|

FP64 |

N/A |

9.7 TFLOPS |

|

FP32 |

91.6 TFLOPS |

19.5 TFLOPS |

|

RT Core |

212 TFLOPS |

N/A |

|

TF32 TensorCore* |

366 TFLOPS |

312 TFLOPS |

|

FP16/BF16 Tensor Core* |

733 TFLOPS |

624 TFLOPS |

|

FP8 Tensor Core* |

1466 TFLOPS |

N/A |

|

INT8 Tensor Core* |

1466 TOPS |

1248 TOPS |

|

GPU Memory |

48 GB GDDR6 |

80 GB HBM2e |

|

GPU Memory Bandwidth |

864 GB/s |

2039 GB/s |

|

L2 Cache |

96 MB |

40 MB |

|

Power |

Up to 350 W |

Up to 400 W |

|

Form Factor |

2-slot FHFL |

8-way HGX |

|

Interconnect |

PCIe Gen4 x16: 64 GB/s |

PCIe Gen4 x16: 64 GB/s |

強力なAIパフォーマンス

第4世代TensorコアとTransformer Engine、新しい半精度性能(FP8)フォーマットは、NVIDIA A100 Tensor Core GPUの推論性能を最大1.5倍上回ります。18,176個のNVIDIA Ada Lovelace GPUアーキテクチャーCUDA® コアを搭載し、A100の約5倍の単精度性能 (FP32)を提供します。

次世代グラフィックス機能

企業向けデータセンター対応

DLSS3

さらに40GB HBMGPUに加えGPU間を第3世代NV Linkにより400GB/s高速インターコネクトで接続とマルチインスタンスGPU(MIG)による、マルチテナントによるGPUリソースの分割利用が可能になります。

また、「NVIDIA A800 40GB Active」は、デスクサイド ワークステーションにマルチGPU利用してコンピューティングパフォーマンスを高め、AI学習性能、AI推論、CSM(個体力学)、流体力学(CFD)、電磁気学 等のCAEのシュミレーション性能向上により計算時間を縮めます。

尚、本製品には、3年間のNVIDIA AI Enterprise のサブスクリプションが提供されます。

【NVIDIA@ A100 vs A800 比較】

「NVIDIA A800 40GB Active」は、NVIDIA A100と同等仕様を有しており、デスクサイド利用においては A800 40GBの搭載をお勧め致します。

| 仕様 | A100 40GB PCIe | A800 40GB Active |

| GPUメモリー | 40GB HBM2 | |

| メモリーインターフェース | 5120-bit | |

| メモリー帯域幅 | 1555.2 GB/s | |

| CUDA コア | 6912 | |

| Tensor コア | 432 | |

| 倍精度(64)演算性能 | 9.7 TFLOPS | |

| 単精度(32)演算性能 | 19.5 TFLOPS | |

| マルチインスタンス GPU | 最大7MIG | |

| NVIDIA NVLink | Yes(×3) | Yes(×2) |

| NVLink 帯域幅 | 600GB/s | 400GB/s |

| システムインターフェース | PCIe 4.0×16 | |

| 消費電力 | 250W | 240W |

| サーマル | Passive | Active |

| フォームファクタ | 4.4"H×10.5" L -デュアルスロット | |

| ディスプレイ対応 | 出力無し | |

| 電力供給コネクタ形状 | 1×CPU-8pin | 1x PCIe CEM5 16-pin |

| 重さ | 1240g | 1182g |

カタログダウンロードはこちらから

Ampereアーキテクチャを採用

第3世代 Tensor コア

マルチインスタンス GPU (MIG)

40 GB の HBM2 大容量メモリ

PCI Express Gen 4

さらに40GB HBMGPUに加えGPU間を第3世代NV Linkにより400GB/s高速インターコネクトで接続とマルチインスタンスGPU(MIG)による、マルチテナントによるGPUリソースの分割利用が可能になります。

また、「NVIDIA A800 40GB Active」は、デスクサイド ワークステーションにマルチGPU利用してコンピューティングパフォーマンスを高め、AI学習性能、AI推論、CSM(個体力学)、流体力学(CFD)、電磁気学 等のCAEのシュミレーション性能向上により計算時間を縮めます。

尚、本製品には、3年間のNVIDIA AI Enterprise のサブスクリプションが提供されます。

【NVIDIA@ A100 vs A800 比較】

「NVIDIA A800 40GB Active」は、NVIDIA A100と同等仕様を有しており、デスクサイド利用においては A800 40GBの搭載をお勧め致します。

| 仕様 | A100 40GB PCIe | A800 40GB Active |

| GPUメモリー | 40GB HBM2 | |

| メモリーインターフェース | 5120-bit | |

| メモリー帯域幅 | 1555.2 GB/s | |

| CUDA コア | 6912 | |

| Tensor コア | 432 | |

| 倍精度(64)演算性能 | 9.7 TFLOPS | |

| 単精度(32)演算性能 | 19.5 TFLOPS | |

| マルチインスタンス GPU | 最大7MIG | |

| NVIDIA NVLink | Yes(×3) | Yes(×2) |

| NVLink 帯域幅 | 600GB/s | 400GB/s |

| システムインターフェース | PCIe 4.0×16 | |

| 消費電力 | 250W | 240W |

| サーマル | Passive | Active |

| フォームファクタ | 4.4"H×10.5" L -デュアルスロット | |

| ディスプレイ対応 | 出力無し | |

| 電力供給コネクタ形状 | 1×CPU-8pin | 1x PCIe CEM5 16-pin |

| 重さ | 1240g | 1182g |

カタログダウンロードはこちらから

Ampereアーキテクチャを採用

第3世代 Tensor コア

マルチインスタンス GPU (MIG)

40 GB の HBM2 大容量メモリ

PCI Express Gen 4

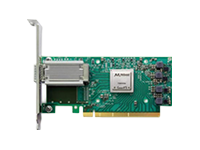

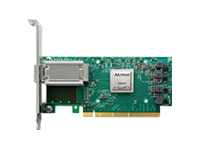

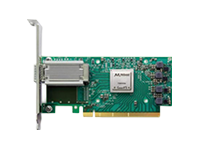

100G対応カード:NVIDIA Mellanox ConnectX-5 アダプターカードシリーズは、HPC環境に柔軟なソリューションと高性能を提供する製品です。ConnectX-5 VPIは、100Gb/s Infiniband(インフィニバンド)およびEthernet(イーサネット)で動作するポートを実装し、600ナノ秒以下のレイテンシー、非常に高いメッセージレートをサポートしています。

100G対応カード:NVIDIA Mellanox ConnectX-5 アダプターカードシリーズは、HPC環境に柔軟なソリューションと高性能を提供する製品です。ConnectX-5 VPIは、100Gb/s Infiniband(インフィニバンド)およびEthernet(イーサネット)で動作するポートを実装し、600ナノ秒以下のレイテンシー、非常に高いメッセージレートをサポートしています。

100G対応カード:NVIDIA Mellanox ConnectX-5 アダプターカードシリーズは、HPC環境に柔軟なソリューションと高性能を提供する製品です。ConnectX-5 VPIは、100Gb/s Infiniband(インフィニバンド)およびEthernet(イーサネット)で動作するポートを実装し、600ナノ秒以下のレイテンシー、非常に高いメッセージレートをサポートしています。

SB7800シリーズはNVIDIAの36ポートノンブロッキング EDR 100Gb/s インフィニバンド・スマートスイッチです。1Uポートに36個のEDR 100Gb/s双方向フル帯域幅のポートを搭載し、最大7.2Tb/sのノンブロッキング帯域幅と90ナノ秒のポート間遅延という市場で最も高いファブリックパフォーマンスを発揮します。また協調設計アーキテクチャScalable Hierarchical Aggregation Protocol (SHARP)がデータセンターの稼働中の全デバイスの利用を可能にし、組込ハードウェアを利用した通信フレームワークの高速化によりアプリケーションのパフォーマンスを大幅に高めます。managed、unmaneged、P2Cエアフロー、C2Pエアフローの4タイプが用意されています。

| NVIDIA MELLANOX SB7800 シリーズ |

36-ポート ノンブロッキング管理型EDR 100Gb/s InfiniBand(インフィニバンド) スマートスイッチ ・19インチラックマウント可能な1U シャーシ ・最大7Tb/s (EDR) のアグリゲートデータスループットを実現する、36のQSFP28 ノンブロッキングポート |

| スイッチ仕様 | ・IBTA 1.2/1.3準拠 ・仮想レーンx9 :データx8+管理x1 ・256 – 4Kbyte MTU ・アダプティブルーティング ・輻輳制御 ・ポートミラーリング ・VL2VLマッピング ・4X48K エントリ リニア転送データベース |

| 管理ポート | ・10/100/1000 Ethernet(イーサネット) ポート ・DB9接続によるRS232ポート ・USBポート ・DHCP ・一般的な業界標準CLI ・IPv6による管理 ・管理IP ・SNMP v1、v2、v3 ・Web UI |

| ファブリック管理機能 | ・最大2,000ノードのファブリック管理に対応したオンボードSubnet Manager ・Unified Fabric Manager™(UFM™) Agent |

| コネクタとケーブル | ・QSFP28コネクタ ・パッシブカッパーまたはアクティブ光ケーブル ・オプティカルモジュール |

| インジケータ | ・ポート別のリンク/稼働状態表示用LED ・システム状態表示用LED:システム、ファン、電源 ・ポートエラー表示用LED ・ユニットID 表示用LED |

| 物理仕様 | ・サイズ:4.4cm(高さ)x 42.8cm(幅) x 68.6cm(奥行) ・重量:11kg |

| パワーサプライ | ・冗長電源用デュアルスロット ・ホットプラグ対応 ・入力電圧レンジ:100~127VAC、200~240VAC ・電源周波数:50~60Hz、単相AC、4.5A、2.9A |

| 冷却装置 | ・正面から背面あるいは背面から正面へのエアフローによる冷却オプション ・ホットスワップ対応ファンユニット |

| 消費電力 | ・ATIS仕様に基づく消費電力:136W |

| 発注型番 | Managed | ポート 数 |

最大転送 レート |

電源 数 |

FRU 構成 |

エア フロー |

筐体の 奥行 |

|---|---|---|---|---|---|---|---|

| MSB7800-ES2F | ○ | 36 | EDR (Switch-IB2) |

2 | Yes | P2C | Standard |

| MSB7800-ES2R | C2P | ||||||

| MSB7890-ES2F | × | P2C | |||||

| MSB7890-ES2R | C2P |

SB7800シリーズはNVIDIAの36ポートノンブロッキング EDR 100Gb/s インフィニバンド・スマートスイッチです。1Uポートに36個のEDR 100Gb/s双方向フル帯域幅のポートを搭載し、最大7.2Tb/sのノンブロッキング帯域幅と90ナノ秒のポート間遅延という市場で最も高いファブリックパフォーマンスを発揮します。また協調設計アーキテクチャScalable Hierarchical Aggregation Protocol (SHARP)がデータセンターの稼働中の全デバイスの利用を可能にし、組込ハードウェアを利用した通信フレームワークの高速化によりアプリケーションのパフォーマンスを大幅に高めます。managed、unmaneged、P2Cエアフロー、C2Pエアフローの4タイプが用意されています。

| NVIDIA MELLANOX SB7800 シリーズ |

36-ポート ノンブロッキング管理型EDR 100Gb/s InfiniBand(インフィニバンド) スマートスイッチ ・19インチラックマウント可能な1U シャーシ ・最大7Tb/s (EDR) のアグリゲートデータスループットを実現する、36のQSFP28 ノンブロッキングポート |

| スイッチ仕様 | ・IBTA 1.2/1.3準拠 ・仮想レーンx9 :データx8+管理x1 ・256 – 4Kbyte MTU ・アダプティブルーティング ・輻輳制御 ・ポートミラーリング ・VL2VLマッピング ・4X48K エントリ リニア転送データベース |

| 管理ポート | ・10/100/1000 Ethernet(イーサネット) ポート ・DB9接続によるRS232ポート ・USBポート ・DHCP ・一般的な業界標準CLI ・IPv6による管理 ・管理IP ・SNMP v1、v2、v3 ・Web UI |

| ファブリック管理機能 | ・最大2,000ノードのファブリック管理に対応したオンボードSubnet Manager ・Unified Fabric Manager™(UFM™) Agent |

| コネクタとケーブル | ・QSFP28コネクタ ・パッシブカッパーまたはアクティブ光ケーブル ・オプティカルモジュール |

| インジケータ | ・ポート別のリンク/稼働状態表示用LED ・システム状態表示用LED:システム、ファン、電源 ・ポートエラー表示用LED ・ユニットID 表示用LED |

| 物理仕様 | ・サイズ:4.4cm(高さ)x 42.8cm(幅) x 68.6cm(奥行) ・重量:11kg |

| パワーサプライ | ・冗長電源用デュアルスロット ・ホットプラグ対応 ・入力電圧レンジ:100~127VAC、200~240VAC ・電源周波数:50~60Hz、単相AC、4.5A、2.9A |

| 冷却装置 | ・正面から背面あるいは背面から正面へのエアフローによる冷却オプション ・ホットスワップ対応ファンユニット |

| 消費電力 | ・ATIS仕様に基づく消費電力:136W |

| 発注型番 | Managed | ポート 数 |

最大転送 レート |

電源 数 |

FRU 構成 |

エア フロー |

筐体の 奥行 |

|---|---|---|---|---|---|---|---|

| MSB7800-ES2F | ○ | 36 | EDR (Switch-IB2) |

2 | Yes | P2C | Standard |

| MSB7800-ES2R | C2P | ||||||

| MSB7890-ES2F | × | P2C | |||||

| MSB7890-ES2R | C2P |

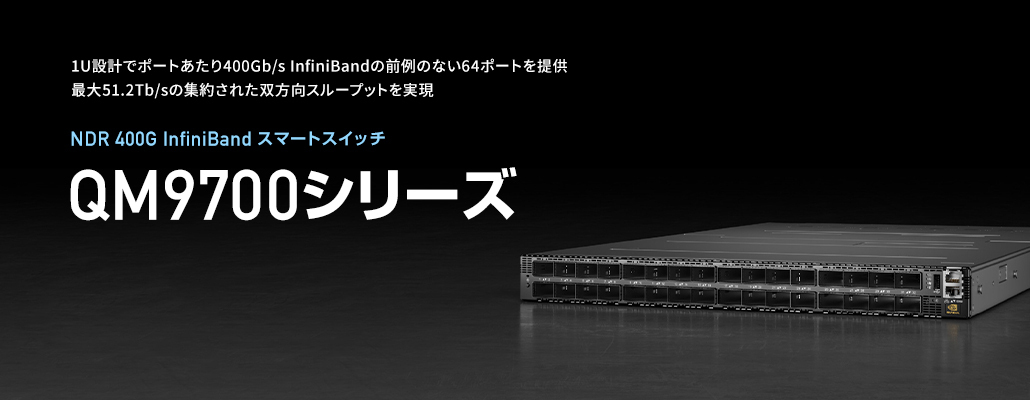

QM8700シリーズ - メラノックスQuantum™ HDR 200Gb/s InfiniBandスマートスイッチ

QM8700シリーズはNVIDIAの40ポートノンブロッキング HDR 200Gb/s インフィニバンド・スマートスイッチです。1Uポートに40個のHDR 200Gb/s双方向フル帯域幅のポートを搭載し、最大16Tb/sのノンブロッキング帯域幅と130ナノ秒のポート間遅延という市場で最も高いファブリックパフォーマンスを発揮します。また協調設計アーキテクチャScalable Hierarchical Aggregation Protocol (SHARP)がデータセンターの稼働中の全デバイスの利用を可能にし、組込ハードウェアを利用した通信フレームワークの高速化によりアプリケーションのパフォーマンスを大幅に高めます。managed、unmaneged、P2Cエアフロー、C2Pエアフローの4タイプが用意されています。

| NVIDIA MELLANOX QM8700 シリーズ |

40-ポート ノンブロッキング管理型/外部管理型 HDR 200Gb/s InfiniBand(インフィニバンド) スマートスイッチ ・19インチラックマウント可能な1U シャーシ ・最大16Tb/s (HDR) のアグリゲートデータスループットを実現する、40のQSFP56 ノンブロッキングポート |

| スイッチ仕様 | ・IBTA 1.21/1.3準拠 ・仮想レーンx9 :データx8+管理x1 ・256 – 4Kbyte MTU ・アダプティブルーティング ・輻輳制御 ・ポートミラーリング ・VL2VLマッピング ・4X48K エントリ リニア転送データベース |

| 管理ポート | ・100/1000 RJ45 Ethernet(イーサネット) ポート ・RS232 コンソールポート ・USBポート ・DHCP ・業界標準のCLI ・IPv6による管理 ・管理IP ・SNMP v1、v2、v3 ・Web UI |

| ファブリック管理機能 | ・最大2,000ノードのファブリック管理に対応したオンボードSubnet Manager ・Unified Fabric Manager™(UFM™) Agent |

| コネクタとケーブル | ・QSFP56コネクタ ・パッシブカッパーまたはアクティブ光ケーブル ・オプティカルモジュール |

| インジケータ | ・ポート別のリンク/稼働状態表示用LED ・システム状態表示用LED:システム、ファン、電源 ・ポートエラー表示用LED ・ユニットID 表示用LED |

| パワーサプライ | ・冗長電源用デュアルスロット ・ホットプラグ対応 ・入力電圧レンジ:100~127VAC、200~240VAC ・電源周波数:50~60Hz、単相AC、4.5A、2.9A |

| 冷却装置 | ・正面から背面あるいは背面から正面へのエアフローによる冷却オプション ・ホットスワップ対応ファンユニット |

| 消費電力 | ・常温で最大スループットを得るための定常消費電力: - すべてのポートにAOCを接続:650W - すべてのポートにDACを接続:450W |

| 発注型番 | Managed | ポート 数 |

最大転送 レート |

電源 数 |

FRU 構成 |

エア フロー |

筐体の 奥行 |

|---|---|---|---|---|---|---|---|

| MQM8700-HS2F | ○ | 40 | 200Gb/s HDR (Quantum™) |

2 | Yes | P2C | Standard |

| MQM8700-HS2R | C2P | ||||||

| MQM8790-HS2F | × | P2C | |||||

| MQM8790-HS2R | C2P |

QM8700シリーズ - メラノックスQuantum™ HDR 200Gb/s InfiniBandスマートスイッチ

QM8700シリーズはNVIDIAの40ポートノンブロッキング HDR 200Gb/s インフィニバンド・スマートスイッチです。1Uポートに40個のHDR 200Gb/s双方向フル帯域幅のポートを搭載し、最大16Tb/sのノンブロッキング帯域幅と130ナノ秒のポート間遅延という市場で最も高いファブリックパフォーマンスを発揮します。また協調設計アーキテクチャScalable Hierarchical Aggregation Protocol (SHARP)がデータセンターの稼働中の全デバイスの利用を可能にし、組込ハードウェアを利用した通信フレームワークの高速化によりアプリケーションのパフォーマンスを大幅に高めます。managed、unmaneged、P2Cエアフロー、C2Pエアフローの4タイプが用意されています。