生成AIの爆発的な普及により、あらゆる業界で大規模なコンピューティングリソースを導入する必要性が高まっています。パフォーマンス、効率、ROI*[1]向上のため、現代のデータセンターには、複雑なワークロード、高速コンピューティング、グラフィックス、ビデオ処理機能を提供する技術が必要です。

NVIDIA L40Sは、データセンター向けの最も強力なユニバーサルGPUであり、推論とトレーニング、グラフィックス、およびビデオアプリケーションに対して高性能かつ高速な処理を実現します。マルチモーダル*[2]生成 AI のプレミアプラットフォームとして、推論、トレーニング、グラフィックス、ビデオワークフローのエンドtoエンドでの高速処理を可能にし、次世代の AI 対応オーディオ、音声、ビデオ、2Dおよび 3D アプリケーションを強化します。

*[1] Return On Investment(投資利益率)。事業や施策において、投下した資本に対しての収益性を図る指標のこと。

*[2] Multi(複数)とModal(様式)を組み合わせたコンピューター用語。さまざまな種類の情報を利用して高度な判断を行うAIを指す。

GPUリソースの安定確保にむけて

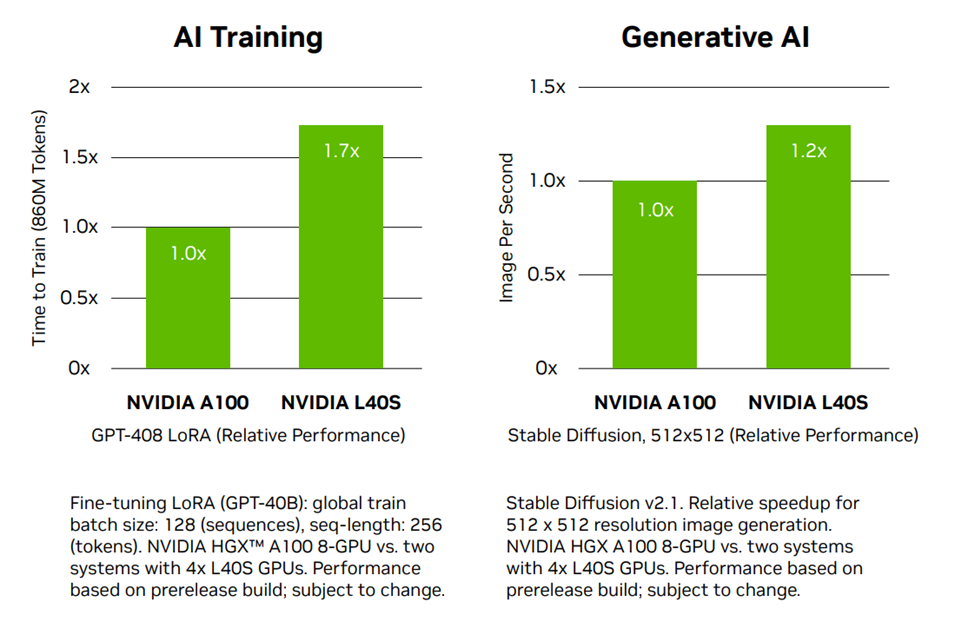

現在、世界的なGPUの急激な需要増加によってNVIDIA H100やNVIDIA A100などのデータセンターGPUの納期が非常に長期化している状況です。ジーデップ・アドバンスでは NVIDIA A100を凌駕したAIトレーニングパフォーマンスを誇る新製品 NVIDIA L40S を搭載した製品ラインナップを増強し、多彩なポートフォリオでお客様のご要望にお応えして参ります。

GPUリソースの安定確保にむけて

現在、世界的なGPUの急激な需要増加によってNVIDIA H100やNVIDIA A100などのデータセンターGPUの納期が非常に長期化している状況です。ジーデップ・アドバンスでは NVIDIA A100を凌駕したAIトレーニングパフォーマンスを誇る新製品 NVIDIA L40S を搭載した製品ラインナップを増強し、多彩なポートフォリオでお客様のご要望にお応えして参ります。

NVIDIA L40S 製品 仕様比較

|

L40S |

A100 80GB SXM |

|

|

GPU Architecture |

NVIDIA Ada Lovelace |

NVIDIA Ampere |

|

FP64 |

N/A |

9.7 TFLOPS |

|

FP32 |

91.6 TFLOPS |

19.5 TFLOPS |

|

RT Core |

212 TFLOPS |

N/A |

|

TF32 TensorCore* |

366 TFLOPS |

312 TFLOPS |

|

FP16/BF16 Tensor Core* |

733 TFLOPS |

624 TFLOPS |

|

FP8 Tensor Core* |

1466 TFLOPS |

N/A |

|

INT8 Tensor Core* |

1466 TOPS |

1248 TOPS |

|

GPU Memory |

48 GB GDDR6 |

80 GB HBM2e |

|

GPU Memory Bandwidth |

864 GB/s |

2039 GB/s |

|

L2 Cache |

96 MB |

40 MB |

|

Power |

Up to 350 W |

Up to 400 W |

|

Form Factor |

2-slot FHFL |

8-way HGX |

|

Interconnect |

PCIe Gen4 x16: 64 GB/s |

PCIe Gen4 x16: 64 GB/s |

- 18176CUDA

- 568Tensor

- 142RT

- ECC

- GDDR6

- 48GB

- 標準3年保証

強力なAIパフォーマンス

第4世代TensorコアとTransformer Engine、新しい半精度性能(FP8)フォーマットは、NVIDIA A100 Tensor Core GPUの推論性能を最大1.5倍上回ります。18,176個のNVIDIA Ada Lovelace GPUアーキテクチャーCUDA® コアを搭載し、A100の約5倍の単精度性能 (FP32)を提供します。

次世代グラフィックス機能

企業向けデータセンター対応

DLSS3