GNAS-QN2U8B は、Intel® Celeron® N5095/5105 クアッドコアプロセッサ(最大バースト 2.9 GHz)を搭載し、省スペース筐体により奥行きの浅いラックや配線が多い環境にも容易に設置できます。さらに、拡張可能なストレージ構成と高性能アプリケーション群により、従来モデルと比較して処理性能・拡張性・運用効率が大幅に向上しています。

クアッドコアCPUとハードウェア暗号化を備えた高効率NASアーキテクチャ

GNAS-QN2U8Bは、Intel® Celeron® N5095 クアッドコアプロセッサ(最大バースト 2.9 GHz)を搭載し、標準 4 GB の DDR4 メモリは最大 16 GB まで拡張可能です。また、Intel® AES-NI 暗号化エンジンを備えており、AES-256 ビット暗号化のハードウェアアクセラレーションにより、暗号化処理を高速化しつつシステム全体のパフォーマンスを最適化します。これにより、NAS に保存されるビジネスデータを高い安全性で保護できます。

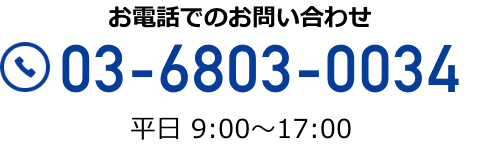

Qtier™ による自動階層化とSSDキャッシュで高速I/Oを実現

GNAS-QN2U8Bは、仮想化環境などランダムIOPSが求められるワークロードを高速化するSSDキャッシュに対応しています。さらに Qtier™ テクノロジー により、高速なSSD層と大容量SATA層の間でデータを自動的に最適配置し、ストレージ性能と利用効率を継続的に向上させます。Qtier™ 2.0 では、SSDの未使用領域をキャッシュとして活用することでリアルタイムのバーストI/Oに対応可能となり、SSD階層化ストレージの性能を最大限引き出します。これにより、GNAS-QN2U8Bはランダムアクセス負荷の高い業務アプリケーションでも高いパフォーマンスを発揮します。

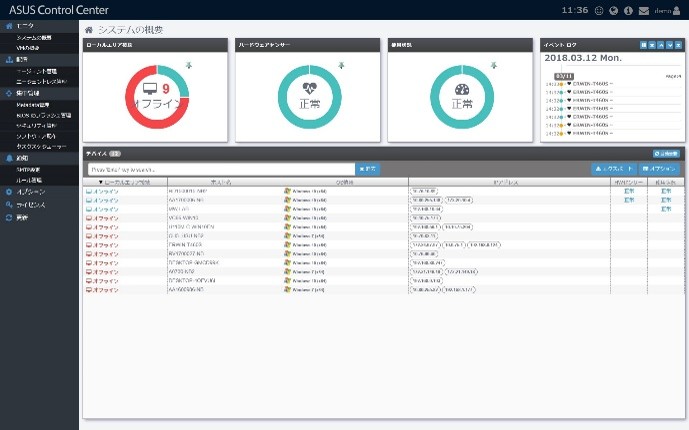

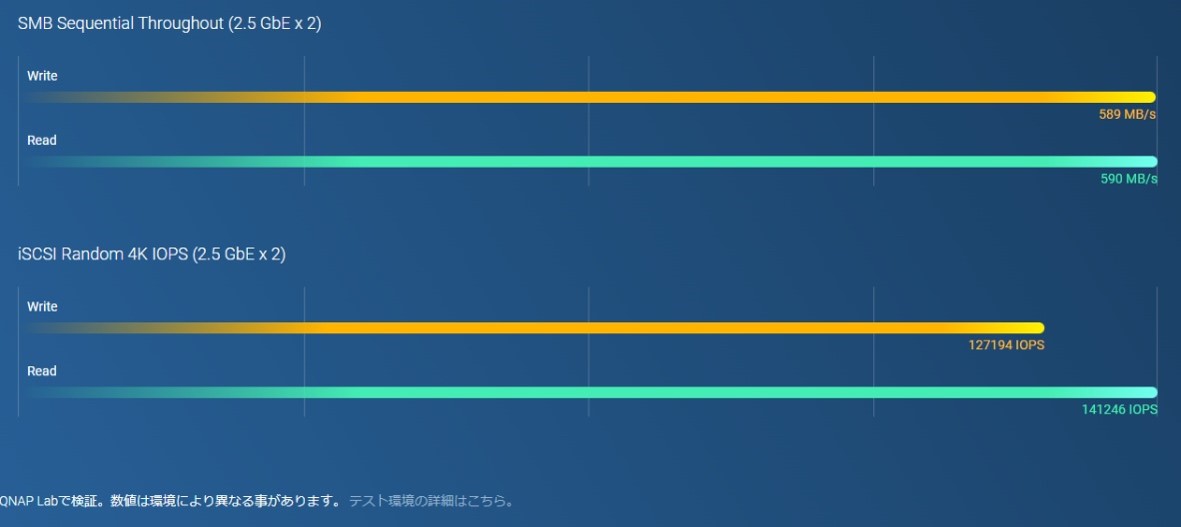

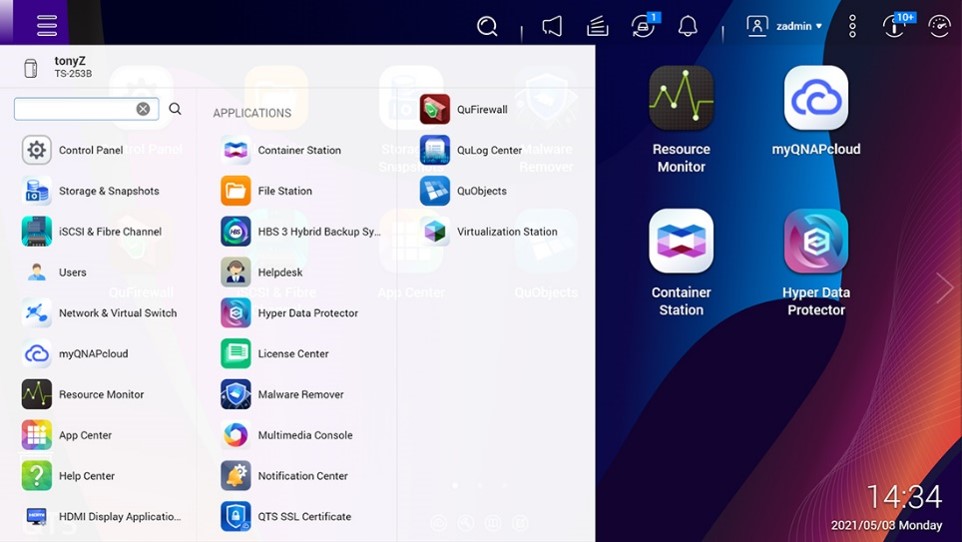

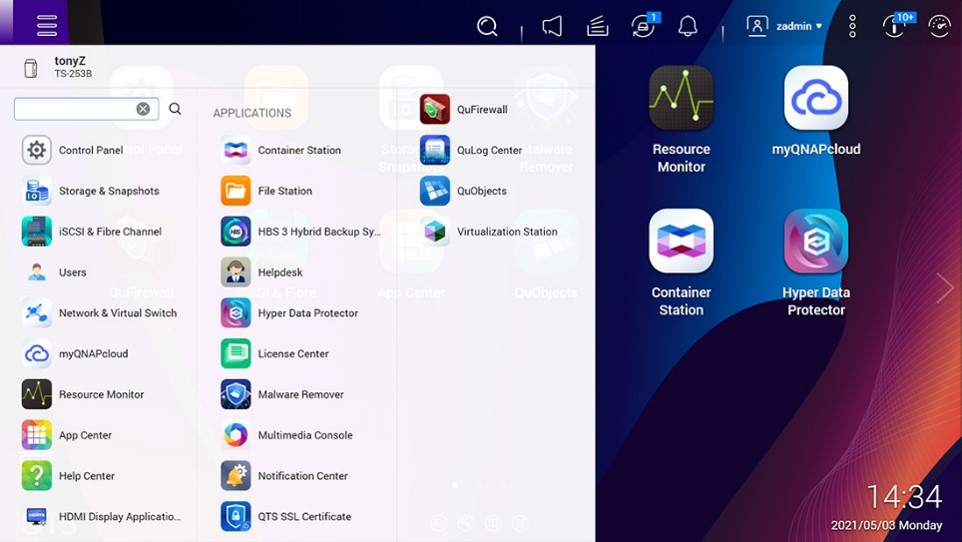

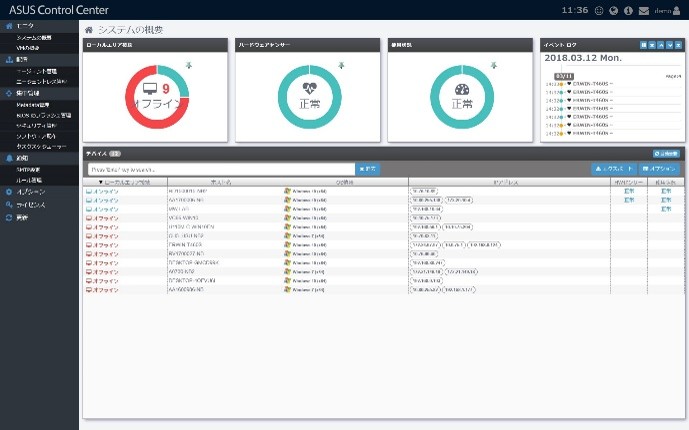

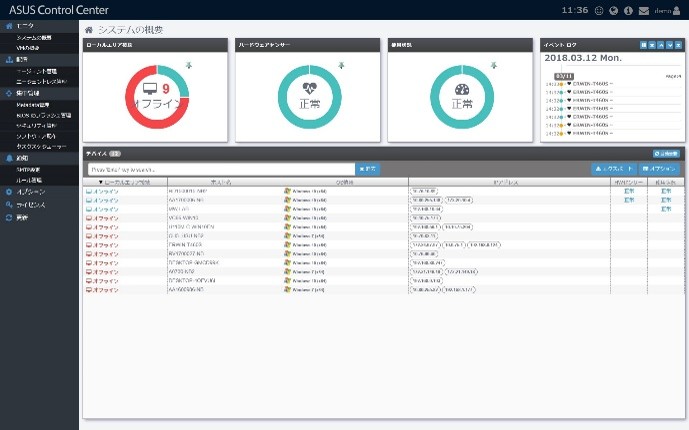

QTS 5 ベースの高効率管理オペレーティング環境

GNAS-QN2U8Bは標準で QTS 5 オペレーティングシステムを搭載しています。最新カーネルによるパフォーマンス向上と、操作性を高めたユーザーインターフェース、さらに強化されたセキュリティ機能により、管理性・安全性・快適性を備えた最新の運用環境を提供します。

高信頼性を支えるアクセス制御と統合セキュリティ

GNAS-QN2U8B は高度なアクセス制御と多層セキュリティ機能を搭載しています。IP アクセス制限、2 要素認証(2FA)、HTTPS/TLS 通信に対応し、不正アクセスリスクを低減します。また、統合セキュリティアプリにより、マルウェアやブルートフォース攻撃などの脅威をリアルタイムで監視・防御し、NAS 全体のセキュリティを強化します。

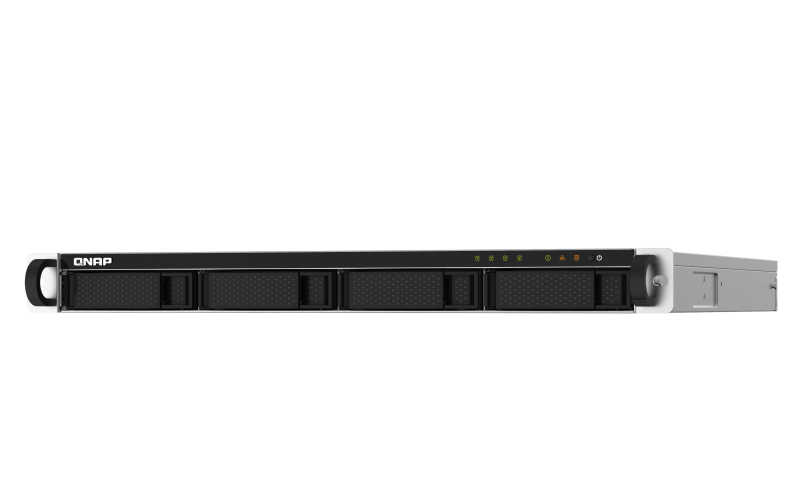

GNASⅢ-RM2U8Bには、Intel® Celeron® N5095/5105 クアッドコアプロセッサ (最大バースト2.9 GHz)が搭載されています。奥行きの浅い省スペースなデザインなので小型のテレビ台やケーブルの多い場所にも簡単に設置できます。拡張可能なストレージ容量および高性能のアプリを備えた GNASⅢ-RM2U8Bは、従来の製品と比較して、圧倒的に優れています。

クアッドコアプロセッサ、最大バースト2.9 GHz、最大8 GBまで増設可能なメモリ

GNASⅢ-RM2U8Bは、Intel® Celeron® N5095クアッドコアプロセッサ(最大バースト2.9 GHz)搭載で、さらに16 GBまで拡張可能な4 GB DDR4メモリを備えています。Intel® AES-NI暗号化エンジン搭載のTS-x64eUは、AES-256ビット暗号化アクセラレーションによる比類ない暗号化性能を備えており、システム性能を向上させつつ、NASに保存された重要なビジネスデータを安全に守ります。

SSDキャッシュおよび自動階層化によるストレージ効率の最適化

GNASⅢ-RM2U8Bは、仮想化などのランダムIOPSを要求するアプリケーションのワークフローを向上するSSDキャッシュをサポートしています。Qtier™テクノロジーにより、高性能のSSDおよび大容量SATAドライブにわたるストレージ利用を継続的に最適化する自動階層化で、GNASⅢ-RM2U8Bの性能が向上します。Qtier™ 2.0は、キャッシュのような予備のスペースでSSD階層化ストレージを強化して、リアルタイムにバーストI/Oを処理し、SSDのメリットを最大限に引き出すことのできるIOへのケアを特長としています。

QTS 5、高速でスムーズかつ使いやすい!

GNASⅢ-RM2U8Bは標準でQTS 5オペレーティングシステムが付属し、アップデートされたシステムカーネル、最適化されたユーザーインターフェース、また先進のセキュリティ機能を備えており、次世代の使用体験を提供します。

包括的なセキュリティおよび権限設定

GNASⅢ-RM2U8Bには、柔軟な権限設定およびセキュリティ機能が搭載されています。IPブロック、二段階認証、HTTPS接続に加え、マルウェアやハッカーなどの脅威からNASを最適に保護するためのアプリがあります。

GNASⅢ-RM2U8Bには、Intel® Celeron® N5095/5105 クアッドコアプロセッサ (最大バースト2.9 GHz)が搭載されています。奥行きの浅い省スペースなデザインなので小型のテレビ台やケーブルの多い場所にも簡単に設置できます。拡張可能なストレージ容量および高性能のアプリを備えた GNASⅢ-RM2U8Bは、従来の製品と比較して、圧倒的に優れています。

クアッドコアプロセッサ、最大バースト2.9 GHz、最大8 GBまで増設可能なメモリ

GNASⅢ-RM2U8Bは、Intel® Celeron® N5095クアッドコアプロセッサ(最大バースト2.9 GHz)搭載で、さらに16 GBまで拡張可能な4 GB DDR4メモリを備えています。Intel® AES-NI暗号化エンジン搭載のTS-x64eUは、AES-256ビット暗号化アクセラレーションによる比類ない暗号化性能を備えており、システム性能を向上させつつ、NASに保存された重要なビジネスデータを安全に守ります。

SSDキャッシュおよび自動階層化によるストレージ効率の最適化

GNASⅢ-RM2U8Bは、仮想化などのランダムIOPSを要求するアプリケーションのワークフローを向上するSSDキャッシュをサポートしています。Qtier™テクノロジーにより、高性能のSSDおよび大容量SATAドライブにわたるストレージ利用を継続的に最適化する自動階層化で、GNASⅢ-RM2U8Bの性能が向上します。Qtier™ 2.0は、キャッシュのような予備のスペースでSSD階層化ストレージを強化して、リアルタイムにバーストI/Oを処理し、SSDのメリットを最大限に引き出すことのできるIOへのケアを特長としています。

QTS 5、高速でスムーズかつ使いやすい!

GNASⅢ-RM2U8Bは標準でQTS 5オペレーティングシステムが付属し、アップデートされたシステムカーネル、最適化されたユーザーインターフェース、また先進のセキュリティ機能を備えており、次世代の使用体験を提供します。

包括的なセキュリティおよび権限設定

GNASⅢ-RM2U8Bには、柔軟な権限設定およびセキュリティ機能が搭載されています。IPブロック、二段階認証、HTTPS接続に加え、マルウェアやハッカーなどの脅威からNASを最適に保護するためのアプリがあります。

GNASⅢ-RM2U8Bには、Intel® Celeron® N5095/5105 クアッドコアプロセッサ (最大バースト2.9 GHz)が搭載されています。奥行きの浅い省スペースなデザインなので小型のテレビ台やケーブルの多い場所にも簡単に設置できます。拡張可能なストレージ容量および高性能のアプリを備えた GNASⅢ-RM2U8Bは、従来の製品と比較して、圧倒的に優れています。

クアッドコアプロセッサ、最大バースト2.9 GHz、最大8 GBまで増設可能なメモリ

GNASⅢ-RM2U8Bは、Intel® Celeron® N5095クアッドコアプロセッサ(最大バースト2.9 GHz)搭載で、さらに16 GBまで拡張可能な4 GB DDR4メモリを備えています。Intel® AES-NI暗号化エンジン搭載のTS-x64eUは、AES-256ビット暗号化アクセラレーションによる比類ない暗号化性能を備えており、システム性能を向上させつつ、NASに保存された重要なビジネスデータを安全に守ります。

SSDキャッシュおよび自動階層化によるストレージ効率の最適化

GNASⅢ-RM2U8Bは、仮想化などのランダムIOPSを要求するアプリケーションのワークフローを向上するSSDキャッシュをサポートしています。Qtier™テクノロジーにより、高性能のSSDおよび大容量SATAドライブにわたるストレージ利用を継続的に最適化する自動階層化で、GNASⅢ-RM2U8Bの性能が向上します。Qtier™ 2.0は、キャッシュのような予備のスペースでSSD階層化ストレージを強化して、リアルタイムにバーストI/Oを処理し、SSDのメリットを最大限に引き出すことのできるIOへのケアを特長としています。

QTS 5、高速でスムーズかつ使いやすい!

GNASⅢ-RM2U8Bは標準でQTS 5オペレーティングシステムが付属し、アップデートされたシステムカーネル、最適化されたユーザーインターフェース、また先進のセキュリティ機能を備えており、次世代の使用体験を提供します。

包括的なセキュリティおよび権限設定

GNASⅢ-RM2U8Bには、柔軟な権限設定およびセキュリティ機能が搭載されています。IPブロック、二段階認証、HTTPS接続に加え、マルウェアやハッカーなどの脅威からNASを最適に保護するためのアプリがあります。

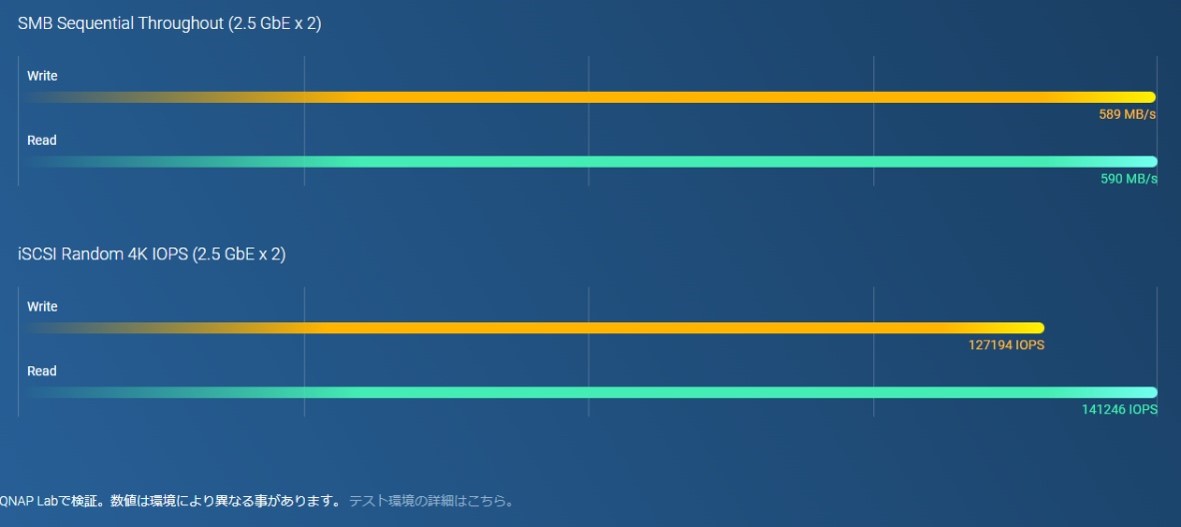

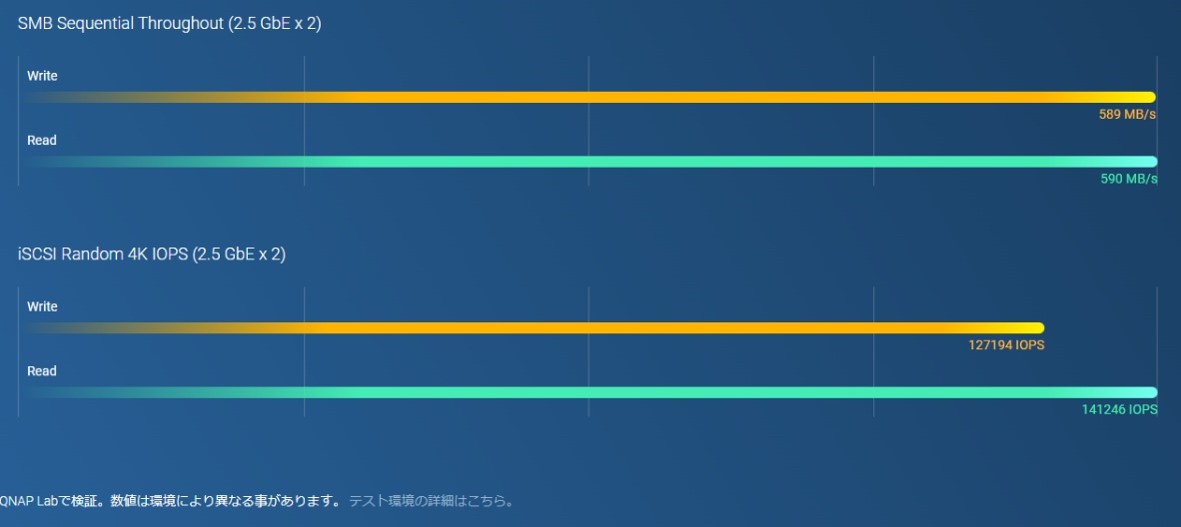

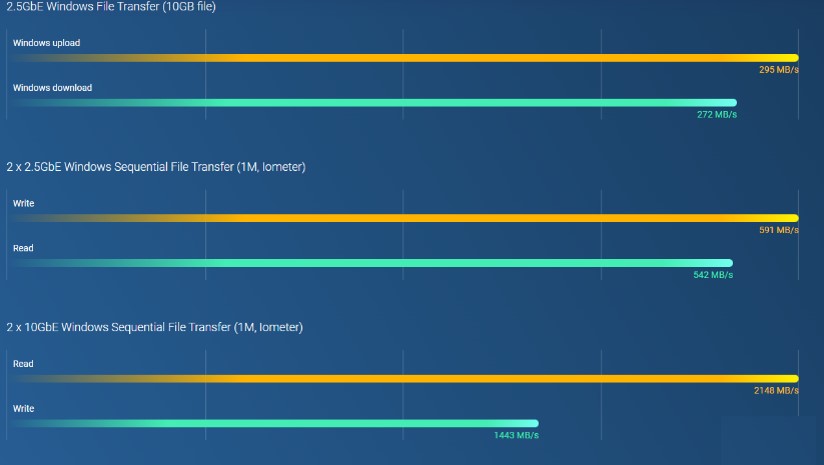

Intel® Celeron® N5105/N5095、クアッドコアプロセッサ (最大バースト 2.9GHz)搭載、2つの2.5GbE RJ45ポートおよびポートトランキング対応で、最大5Gbpsの結合帯域幅を実現します。M.2 PCIe Gen3およびPCIe Gen3スロット装備、NAS機能の拡張性を提供し、M.2 SSDキャッシュ用のQM2カード、AI画像認識用のEdge TPU、各種10GbE/5GbEネットワークカードのインストールが可能です。また4 GB RAM装備で軽負荷VMおよびコンテナが稼働可能で、マルチクラウドバックアップ、クラウドストレージゲートウェイ、4K HDMI出力、リアルタイムトランスコーディングに対応し、拡張可能なストレージ容量や機能の豊富なアプリによって高いコスト効率と信頼性を備えた2.5GbE NASとして活躍します。

クアッドコアの高性能および最大16GBのRAM

Intel Celeron N5105 / N5095 クアッドコアプロセッサ搭載で、最大16 GB DDR4 メモリ、2つの2.5GbEポートおよびSATA 6 Gb/sドライブに対応します。また、搭載のIntel® AES-NI暗号化エンジンがシステムパフォーマンスへの影響なく機密データの保護を支援します。

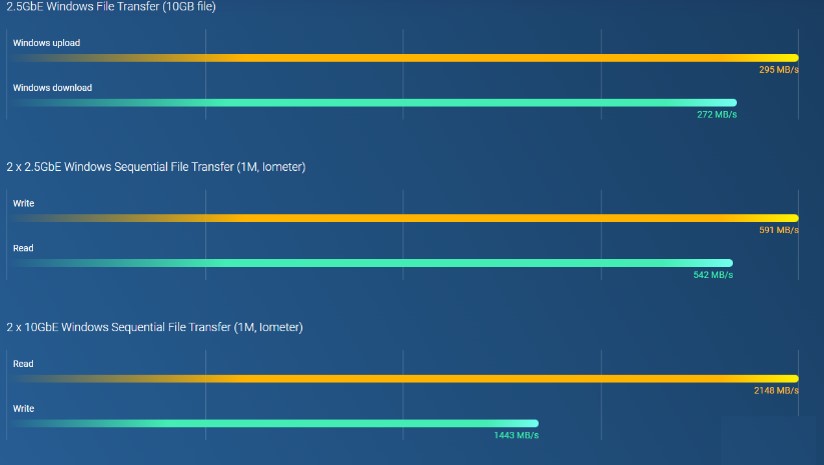

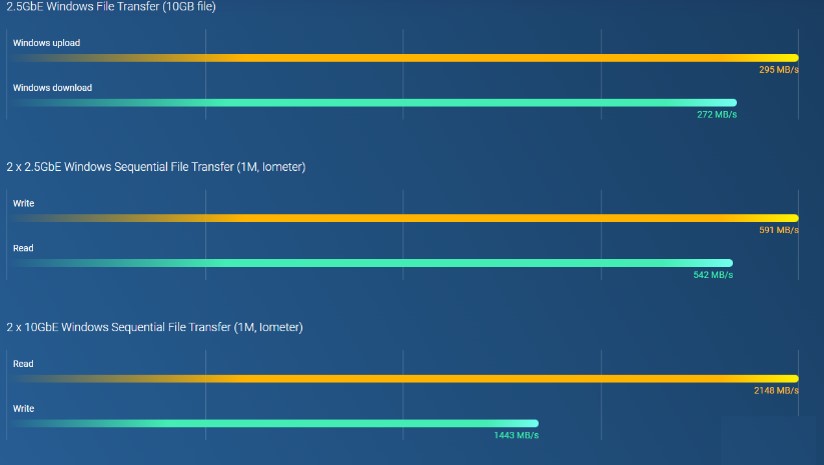

2.5GbEで、大容量ファイル転送とビデオ編集を効率化

2つの2.5GbE RJ45 (2.5G/1G/100M) LANポートを備えており、既存のCAT5eケーブルを使ってネットワーク速度を1 ギガビットから2.5 ギガビットへアップグレードできます。また、2つの2.5GbEポートはポートトランキング対応で最大5 Gbpsの転送速度を実現し、大型ファイル転送、高速バックアップ・復元、マルチメディア転送・編集など、帯域幅重視のアプリケーションにおけるビジネス効率を向上させます。

TPUおよびPCIe拡張による、AIベース画像認識およびキャッシュのアクセラレーション

2つのM.2 PCIe Gen 3スロットを装備しており、SSDキャッシュまたはSSDストレージプールによるパフォーマンス向上、またはEdge TPUによるAI画像認識を実現します。

最大5年までのハードウェア保証延長

本製品には、別途費用なしで3年保証が付いています。必要に応じて、最大5年までの延長保証を購入することができます。

GNAS-DS4Bは10GbEネットワーク、RAID(5,6,10,JBOD等)に対応した信頼性、安全性、拡張性が高い4ベイ高性能 NAS のエントリーモデルです。

高い機密性とパフォーマンス

最新の14 nm Intel® Celeron® J3455クアッドコア1.5Ghzプロセッサ (バースト最大2.3Ghz)、を搭載したGNAS-DS8BBは最大 225 MB/s の読み書き速度でタスクをスムーズかつ素早く実行します。Intel® AES-NIハードウェアアクセラレート暗号化エンジンを搭載し、NASボリューム全体と共有フォルダに対して、AES 256ビット暗号化による最大225MB/秒の転送速度を実現します。 また、システム性能を向上させ、貴重なデータを安全に確実に保管します。

シームレスな容量拡張

GNAS-DS4Bは拡張エンクロージャーを追加することにより容易に容量の拡張が可能です。ビジネスにおいて増大するビッグデータや,大型ファイルのアーカイブの必要性に応える高性能でありながらも経済的なストレージソリューションです。

高信頼性ストレージWD Redシリーズ搭載

GNAS-DS8Bでは搭載ハードディスクにWestern digital社のREDシリーズを採用。 複数台ストレージの周囲温度が高くなるような厳しい環境下でも、低温で低振動で動作するよう開発されており、厳しい24時間365日常時稼働環境で優れた適合性を発揮します。

GNAS-DS4Bは10GbEネットワーク、RAID(5,6,10,JBOD等)に対応した信頼性、安全性、拡張性が高い4ベイ高性能 NAS のエントリーモデルです。

高い機密性とパフォーマンス

最新の14 nm Intel® Celeron® J3455クアッドコア1.5Ghzプロセッサ (バースト最大2.3Ghz)、を搭載したGNAS-DS8BBは最大 225 MB/s の読み書き速度でタスクをスムーズかつ素早く実行します。Intel® AES-NIハードウェアアクセラレート暗号化エンジンを搭載し、NASボリューム全体と共有フォルダに対して、AES 256ビット暗号化による最大225MB/秒の転送速度を実現します。 また、システム性能を向上させ、貴重なデータを安全に確実に保管します。

シームレスな容量拡張

GNAS-DS4Bは拡張エンクロージャーを追加することにより容易に容量の拡張が可能です。ビジネスにおいて増大するビッグデータや,大型ファイルのアーカイブの必要性に応える高性能でありながらも経済的なストレージソリューションです。

高信頼性ストレージWD Redシリーズ搭載

GNAS-DS8Bでは搭載ハードディスクにWestern digital社のREDシリーズを採用。 複数台ストレージの周囲温度が高くなるような厳しい環境下でも、低温で低振動で動作するよう開発されており、厳しい24時間365日常時稼働環境で優れた適合性を発揮します。

AMD Ryzen™ V1000シリーズ V1500Bクアッドコアプロセッサ搭載で、最大クアッドコア/ 8スレッド、最大2.2 GHzのTurbo Core対応、優れたシステム性能を実現します。2つの2.5GbE RJ45ポートおよび2つのPCIe Gen3スロットを装備、5GbE/10GbEネットワークをフレキシブルに展開できます。QtierテクノロジおよびSSDキャッシング対応の2つのM.2 NVMe SSDスロットにより、安定したストレージ最適化が可能です。

高性能AMD Ryzen™プロセッサ

AMD Ryzen™ V1000 シリーズ V1500 クアッドコア2.2 GHz プロセッサ搭載、最大64GB RAM (ECCメモリ対応*)装着で、最大10 Gb/sの速度に対応するUSB 3.2 Gen 2ポートを装備します。また、1つのUSB Type-Cポートを装備、より多くのデバイスに対応することで、大容量メディアファイルを複数のデバイス間で転送でき、より効率的なワークフローが実現します。

お財布に優しい2.5GbEスイッチにより、ネットワークを変革します

ネットワークのアップグレードに莫大な費用をかける必要はありません。2.5GbE接続は標準の1GbEと比べてすぐに顕著な改善がみられます。マルチGigabit NBASE-T™対応の2.5GbEスイッチを提供、これにより既存のCAT5eケーブルを使って複数のコンピューターおよびNASが接続でき、予算を超えることなく、高速でセキュアかつスケーラブルなネットワーク環境を組織に導入することを支援します。

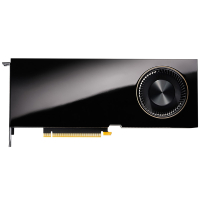

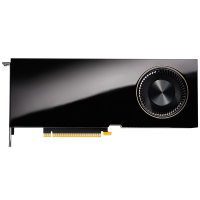

GPUアクセラレーションコンピューティングのためにグラフィックカードを取り付ける

グラフィックスカードは、グラフィカルな計算や変換のために最適化されていますが、他のハードウェアよりも多くの電力を必要としています。本製品は、NVIDIA® GeForce® GTX1650グラフィックスカードを含む、電源ケーブルを必要としないハイプロファイルグラフィックスカードをサポートするPCIeスロットを備えており、ビデオ編集、4K UHDトランスコーディング、QTSでの画像処理、GPUパススルーを介した仮想マシンのパフォーマンスなどのアプリケーション性能を向上させることができます。

最大5年までのハードウェア保証延長

本製品には、別途費用なしで3年保証が付いています。必要に応じて、最大5年までの延長保証を購入することができます。

AMD Ryzen™ V1000シリーズ V1500Bクアッドコアプロセッサ搭載で、最大クアッドコア/ 8スレッド、最大2.2 GHzのTurbo Core対応、優れたシステム性能を実現します。2つの2.5GbE RJ45ポートおよび2つのPCIe Gen3スロットを装備、5GbE/10GbEネットワークをフレキシブルに展開できます。QtierテクノロジおよびSSDキャッシング対応の2つのM.2 NVMe SSDスロットにより、安定したストレージ最適化が可能です。

高性能AMD Ryzen™プロセッサ

AMD Ryzen™ V1000 シリーズ V1500 クアッドコア2.2 GHz プロセッサ搭載、最大64GB RAM (ECCメモリ対応*)装着で、最大10 Gb/sの速度に対応するUSB 3.2 Gen 2ポートを装備します。また、1つのUSB Type-Cポートを装備、より多くのデバイスに対応することで、大容量メディアファイルを複数のデバイス間で転送でき、より効率的なワークフローが実現します。

お財布に優しい2.5GbEスイッチにより、ネットワークを変革します

ネットワークのアップグレードに莫大な費用をかける必要はありません。2.5GbE接続は標準の1GbEと比べてすぐに顕著な改善がみられます。マルチGigabit NBASE-T™対応の2.5GbEスイッチを提供、これにより既存のCAT5eケーブルを使って複数のコンピューターおよびNASが接続でき、予算を超えることなく、高速でセキュアかつスケーラブルなネットワーク環境を組織に導入することを支援します。

GPUアクセラレーションコンピューティングのためにグラフィックカードを取り付ける

グラフィックスカードは、グラフィカルな計算や変換のために最適化されていますが、他のハードウェアよりも多くの電力を必要としています。本製品は、NVIDIA® GeForce® GTX1650グラフィックスカードを含む、電源ケーブルを必要としないハイプロファイルグラフィックスカードをサポートするPCIeスロットを備えており、ビデオ編集、4K UHDトランスコーディング、QTSでの画像処理、GPUパススルーを介した仮想マシンのパフォーマンスなどのアプリケーション性能を向上させることができます。

最大5年までのハードウェア保証延長

本製品には、別途費用なしで3年保証が付いています。必要に応じて、最大5年までの延長保証を購入することができます。

AMD Ryzen™ V1000シリーズ V1500Bクアッドコアプロセッサ搭載で、最大クアッドコア/ 8スレッド、最大2.2 GHzのTurbo Core対応、優れたシステム性能を実現します。2つの2.5GbE RJ45ポートおよび2つのPCIe Gen3スロットを装備、5GbE/10GbEネットワークをフレキシブルに展開できます。QtierテクノロジおよびSSDキャッシング対応の2つのM.2 NVMe SSDスロットにより、安定したストレージ最適化が可能です。

高性能AMD Ryzen™プロセッサ

AMD Ryzen™ V1000 シリーズ V1500 クアッドコア2.2 GHz プロセッサ搭載、最大64GB RAM (ECCメモリ対応*)装着で、最大10 Gb/sの速度に対応するUSB 3.2 Gen 2ポートを装備します。また、1つのUSB Type-Cポートを装備、より多くのデバイスに対応することで、大容量メディアファイルを複数のデバイス間で転送でき、より効率的なワークフローが実現します。

既存CAT5eをそのまま活用し、コストを抑えた高速・安全なネットワーク環境を実現

ネットワークのアップグレードに莫大な費用をかける必要はありません。2.5GbE接続は標準の1GbEと比べてすぐに顕著な改善がみられます。マルチGigabit NBASE-T™対応の2.5GbEスイッチを提供、これにより既存のCAT5eケーブルを使って複数のコンピューターおよびNASが接続でき、予算を超えることなく、高速でセキュアかつスケーラブルなネットワーク環境を組織に導入することを支援します。

GTX1650相当の無給電GPU拡張に対応。4KトランスコードやVMパススルー性能の強化が可能に

グラフィックスカードは、グラフィカルな計算や変換のために最適化されていますが、他のハードウェアよりも多くの電力を必要としています。本製品は、NVIDIA® GeForce® GTX1650グラフィックスカードを含む、電源ケーブルを必要としないハイプロファイルグラフィックスカードをサポートするPCIeスロットを備えており、ビデオ編集、4K UHDトランスコーディング、QTSでの画像処理、GPUパススルーを介した仮想マシンのパフォーマンスなどのアプリケーション性能を向上させることができます。

最大5年までのハードウェア保証延長

本製品には、別途費用なしで3年保証が付いています。必要に応じて、最大5年までの延長保証を購入することができます。

AMD Ryzen™ V1000シリーズ V1500Bクアッドコアプロセッサ搭載で、最大クアッドコア/ 8スレッド、最大2.2 GHzのTurbo Core対応、優れたシステム性能を実現します。2つの2.5GbE RJ45ポートおよび2つのPCIe Gen3スロットを装備、5GbE/10GbEネットワークをフレキシブルに展開できます。QtierテクノロジおよびSSDキャッシング対応の2つのM.2 NVMe SSDスロットにより、安定したストレージ最適化が可能です。

高性能AMD Ryzen™プロセッサ

AMD Ryzen™ V1000 シリーズ V1500 クアッドコア2.2 GHz プロセッサ搭載、最大64GB RAM (ECCメモリ対応*)装着で、最大10 Gb/sの速度に対応するUSB 3.2 Gen 2ポートを装備します。また、1つのUSB Type-Cポートを装備、より多くのデバイスに対応することで、大容量メディアファイルを複数のデバイス間で転送でき、より効率的なワークフローが実現します。

お財布に優しい2.5GbEスイッチにより、ネットワークを変革します

ネットワークのアップグレードに莫大な費用をかける必要はありません。2.5GbE接続は標準の1GbEと比べてすぐに顕著な改善がみられます。マルチGigabit NBASE-T™対応の2.5GbEスイッチを提供、これにより既存のCAT5eケーブルを使って複数のコンピューターおよびNASが接続でき、予算を超えることなく、高速でセキュアかつスケーラブルなネットワーク環境を組織に導入することを支援します。

GPUアクセラレーションコンピューティングのためにグラフィックカードを取り付ける

グラフィックスカードは、グラフィカルな計算や変換のために最適化されていますが、他のハードウェアよりも多くの電力を必要としています。本製品は、NVIDIA® GeForce® GTX1650グラフィックスカードを含む、電源ケーブルを必要としないハイプロファイルグラフィックスカードをサポートするPCIeスロットを備えており、ビデオ編集、4K UHDトランスコーディング、QTSでの画像処理、GPUパススルーを介した仮想マシンのパフォーマンスなどのアプリケーション性能を向上させることができます。

最大5年までのハードウェア保証延長

本製品には、別途費用なしで3年保証が付いています。必要に応じて、最大5年までの延長保証を購入することができます。

10GbE SFP+と2.5GbEネットワークポートを備えたGNASⅢ-RM1U4Bは、高いネットワーク帯域幅を実現し、チームのコラボレーションとファイルアクセスを合理化します。1つのPCIe Gen 2 x2スロットにより、QNAP拡張カードをインストールして、ネットワーク接続性、SSDキャッシング機能やワイヤレス接続性を追加できます。必要な時にはいつでも即座に回復を実現する一方で、ファイルのバックアップと同期化、安全なスナップショット保護、Google™ WorkspaceとMicrosoft 365®エンタープライズアカウントバックアップサービスに対応しています。

より高いパフォーマンス x より速い処理能力

より高いパフォーマンスを実現する2GB DDR4 RAM(16GBまで拡張可能)とSATA 6Gb/sドライブを備えたAnnapurna Labs Alpine AL-324 ARM® Cortex®-A57クアッドコア1.7 GHzプロセッサを搭載しています。2つの10GbE SFP+と2つの2.5GbEネットワークポートを備えたGNAS-RM1U4Bは、信じられないくらいの帯域幅を実現し、高速ファイルアクセス、バックアップ/復元、メディア転送を満たします。さらに、個々のアプリケーションとサービスのためにネットワークリソースを柔軟に割り当てることができます。

マルチポイントのファイルバックアップ、アクセス、および同期

HBS(Hybrid Backup Sync)は、データのバックアップ、回復、データの同期化を統合します。高速10GbEの接続性により、別のGNAS、リモートサーバーやクラウドストレージにデータを容易にバックアップ/同期でき、信頼性の高い障害復旧ソリューションを構築できます。Qsync があれば、GNAS-RM1U4Bがファイル同期のための大容量の安全なデータセンターへと変身。GNAS-RM1U4Bにアップロードされたファイルは、デスクトップパソコンやノートパソコン、スマートフォンなど、接続されたすべての端末で利用できます。また、共有フォルダの同期やチームフォルダを作成することで、共同作業の効率を上げることも可能です。

頼れるサービスのための冗長性電源

GNAS-RM1U4Bは、サービスアップタイムを最大化するために冗長性電源を搭載しています。デュアル10GbE SFP+とデュアル2.5GbEポートを組み合わせ、 お客様のビジネスは容易に年中無休の稼働を維持でき、費用対効果が良く、信頼性の高いストレージソリューションを保証します。

データ増加に応じて拡張できる、モジュール型ストレージ拡張フレームワーク

GNAS-RM1U4Bのストレージ容量は、データ需要の増加に合わせて容易に拡張できます。ストレージ容量を拡張するには、必要に応じて、TR RAID拡張エンクロージャやTL JBODを接続するだけです。仮想JBOD(VJBOD)テクノロジーにより、GNAS-RM1U4Bの未使用のスペースが他のGNASのストレージ容量を拡張するために使用されます。

Intel® Celeron® J4125、クアッドコア2.0 GHzプロセッサを搭載した本製品は、2つの2.5GbE RJ45ポート特長としています。このモデルは、ギガビットイーサネットの最大2.5倍の速度を実現し、スムーズなマルチメディア再生と日常での利用を可能にします。PCIe Gen 2.0 x 2スロットを搭載した本製品は、NAS機能を柔軟に拡張でき、追加のネットワークポート、M.2 SSDキャッシング/ティアリングやWi-Fi接続性用のさまざまなカードをインストールできます。本製品は、AES 256ビット暗号化を使用してデータセキュリティを確保しており、保存されている機密性の高いビジネスデータの安全性を確保しながらシステムの性能を向上しています。

QNAPで高速ネットワークを構築

Intel® Celeron® J4125クアッドコア2.0 GHzプロセッサ(最大2.70 GHzまでバースト)、DDR4デュアルチャンネルRAM(最大8GB)、2つの2.5GbEギガビットLANポートを搭載した本製品は、スムーズなマルチメディア再生と日常でのNAS利用を可能にします。QNAPの追加の高速ネットワークオプションには、USB 3.2 Gen 1 to 2.5GbE/5GbEアダプター(N-BASET/Multi-Gigに対応)、QXG 5GbE/10GbE PCIeカード、QNAP QSW 10GbEスイッチが含まれます。これらすべてのオプションにより、ユーザーはネットワークをコスト効率良く大幅に改善できます。

PCIeカードでNASの機能性を拡張

PCIe Gen 2.0 x 2スロットにより、本製品はNAS機能拡張および将来のアプリケーション向けに柔軟性を提供しています。システム性能を最適化するには、QNAP QM2カードをインストールして、M.2 SATAやNVMe SSDキャッシング/10GbE接続性を追加し、最適なシステム性能を実現するためにQtier階層型記憶域と共に使用します。QNAP QWA-AC2600をインストールすることで、ワイヤレス接続性を追加できます。QXG-10GbE/5GbEネットワークカードは、超高速ネットワークポートを追加します。あるいは、お手頃なQNAP QNA-UC5G1T USB 3.2 Gen 1 to 5GbEアダプターを追加して、より高速なネットワーク速度を楽しんだり、USB 3.2 Gen 2(10Gbps)カードをインストールしてUSB接続性を向上させたりすることができます。

最適化されたストレージ効率のためのSSDキャッシングおよび自動階層化

本製品は、仮想化などのランダムIOPSを要求するアプリケーションのワークフローを向上するSSDキャッシングをサポートしています。Qtier™テクノロジーにより、高性能のSSDおよび大容量SATAドライブにわたるストレージ利用を継続的に最適化する自動階層化で本製品が強化されています。Qtier™ 2.0は、キャッシュのような予約スペースでSSD階層化ストレージを強化して、リアルタイムにバーストI/Oを処理し、SSDのメリットを最大限に引き出すことのできるIOへのケアを特長としています。

簡単で安全なファイル管理

File Stationでは、本製品やクラウドに保存したファイルを一元管理することができます。コンピューターからファイルを簡単にアップロードしたり、フォルダー間でファイルをドラッグアンドドロップでき、ファイル名の変更、ファイルの削除、ファイルの設定、不正アクセスを回避するためのフォルダー権限の変更を行うことができます。Microsoft Office Onlineを使用して、ローカルデバイスにダウンロードすることなく、本製品に保存されたMicrosoft Office文書を直接開いたり、修正したりすることができます。本製品に保存された機密性の高いファイルを共有する場合、File Stationを使用してファイルを.qencファイルに暗号化し、パスワードを設定し、QENC Decrypterを使用してファイルを復号します。

Intel® Celeron® J4125、クアッドコア2.0 GHzプロセッサを搭載した本製品は、2つの2.5GbE RJ45ポート特長としています。このモデルは、ギガビットイーサネットの最大2.5倍の速度を実現し、スムーズなマルチメディア再生と日常での利用を可能にします。PCIe Gen 2.0 x 2スロットを搭載した本製品は、NAS機能を柔軟に拡張でき、追加のネットワークポート、M.2 SSDキャッシング/ティアリングやWi-Fi接続性用のさまざまなカードをインストールできます。本製品は、AES 256ビット暗号化を使用してデータセキュリティを確保しており、保存されている機密性の高いビジネスデータの安全性を確保しながらシステムの性能を向上しています。

QNAPで高速ネットワークを構築

Intel® Celeron® J4125クアッドコア2.0 GHzプロセッサ(最大2.70 GHzまでバースト)、DDR4デュアルチャンネルRAM(最大8GB)、2つの2.5GbEギガビットLANポートを搭載した本製品は、スムーズなマルチメディア再生と日常でのNAS利用を可能にします。QNAPの追加の高速ネットワークオプションには、USB 3.2 Gen 1 to 2.5GbE/5GbEアダプター(N-BASET/Multi-Gigに対応)、QXG 5GbE/10GbE PCIeカード、QNAP QSW 10GbEスイッチが含まれます。これらすべてのオプションにより、ユーザーはネットワークをコスト効率良く大幅に改善できます。

PCIeカードでNASの機能性を拡張

PCIe Gen 2.0 x 2スロットにより、本製品はNAS機能拡張および将来のアプリケーション向けに柔軟性を提供しています。システム性能を最適化するには、QNAP QM2カードをインストールして、M.2 SATAやNVMe SSDキャッシング/10GbE接続性を追加し、最適なシステム性能を実現するためにQtier階層型記憶域と共に使用します。QNAP QWA-AC2600をインストールすることで、ワイヤレス接続性を追加できます。QXG-10GbE/5GbEネットワークカードは、超高速ネットワークポートを追加します。あるいは、お手頃なQNAP QNA-UC5G1T USB 3.2 Gen 1 to 5GbEアダプターを追加して、より高速なネットワーク速度を楽しんだり、USB 3.2 Gen 2(10Gbps)カードをインストールしてUSB接続性を向上させたりすることができます。

最適化されたストレージ効率のためのSSDキャッシングおよび自動階層化

本製品は、仮想化などのランダムIOPSを要求するアプリケーションのワークフローを向上するSSDキャッシングをサポートしています。Qtier™テクノロジーにより、高性能のSSDおよび大容量SATAドライブにわたるストレージ利用を継続的に最適化する自動階層化で本製品が強化されています。Qtier™ 2.0は、キャッシュのような予約スペースでSSD階層化ストレージを強化して、リアルタイムにバーストI/Oを処理し、SSDのメリットを最大限に引き出すことのできるIOへのケアを特長としています。

簡単で安全なファイル管理

File Stationでは、本製品やクラウドに保存したファイルを一元管理することができます。コンピューターからファイルを簡単にアップロードしたり、フォルダー間でファイルをドラッグアンドドロップでき、ファイル名の変更、ファイルの削除、ファイルの設定、不正アクセスを回避するためのフォルダー権限の変更を行うことができます。Microsoft Office Onlineを使用して、ローカルデバイスにダウンロードすることなく、本製品に保存されたMicrosoft Office文書を直接開いたり、修正したりすることができます。本製品に保存された機密性の高いファイルを共有する場合、File Stationを使用してファイルを.qencファイルに暗号化し、パスワードを設定し、QENC Decrypterを使用してファイルを復号します。

強力なAMD Ryzen™ V1000シリーズV1500Bクアッドコアプロセッサを搭載したGNAS-QN2U12Bは、仮想マシンのパフォーマンスを最大2.2GHzの4コア/8スレッドまでブーストできます。2つの2.5GbEポートと2つのPCIe Gen 3スロットを備えており、高速ネットワーク接続を提供し、更なる機能と追加のアプリケーションの可能性を付加することができます。また、システムのアップタイムを最大化するために冗長電源を搭載しています。

Ryzen™ V1500B搭載、高性能ラックマウントNAS

GNAS-QN2U12B は、AES-NI ハードウェア暗号化アクセラレーションと最大 64 GB の DDR4 メモリを備え、4コア/8スレッドの AMD Ryzen™ V1500B 2.2 GHz プロセッサを搭載したラックマウント型NASです。高性能ながら効率的な設計により、VDI、R&D、プライベートクラウド、サーバー仮想化など、リソース集約型のビジネスアプリケーションでも安定した処理能力を提供します。

2.5GbE対応LANポートとリンクアグリゲーションによる高速・冗長ネットワーク

GNAS-QN2U12B は、2基の 2.5GbE RJ45 LAN ポートを搭載しており、既存の CAT5e ケーブルを用いてネットワーク速度を 1GbE から 2.5GbE にアップグレード可能です。ポートトランキング(リンクアグリゲーション)を活用することで、最大 5GbE の帯域幅を実現でき、冗長性と負荷分散によるネットワーク安定性も向上します。さらに、ラップトップやデスクトップ端末の高速ネットワーク利用を支援するため、USB 3.2 Gen 1 to 5GbE アダプターや 5GbE PCIe 拡張カードなどの各種アダプター・周辺機器にも対応しています。

SSDキャッシュによるランダムI/O最適化と低レイテンシ化

GNAS-QN2U12B は、SSD キャッシュを追加することでストレージボリュームのランダム I/O 性能を大幅に向上させ、レイテンシを低減します。データベースや仮想化環境など IOPS を多く消費するアプリケーションに最適で、キャッシュ使用によりシステム全体のワークフロー効率が改善されます。SSD キャッシュの起動・停止および設定変更は、システムをシャットダウンすることなくリアルタイムで実行可能で、運用中の柔軟なパフォーマンス最適化をサポートします。

VJBOD対応による柔軟なNASストレージ拡張

GNAS-QN2U12B は、TR RAID 拡張エンクロージャや TL JBOD を接続することで、データ増加に応じた物理ストレージの容易な拡張をサポートします。加えて、仮想 JBOD(VJBOD)テクノロジーを活用することで、GNAS-QN2U12B の未使用ストレージ領域をネットワーク経由で他の GNAS デバイスに仮想的に割り当て、追加ハードウェアを導入せずにストレージ容量を拡張可能です。これにより、ストレージ資源を効率的に集約し、RAID 構成やデータ冗長性を維持しながら、複数 NAS 間で柔軟に容量を再配分できます。

強力なAMD Ryzen™ V1000シリーズV1500Bクアッドコアプロセッサを搭載したGNASⅢ-RM2U12Bは、仮想マシンのパフォーマンスを最大2.2GHzの4コア/8スレッドまでブーストできます。2つの2.5GbEポートと2つのPCIe Gen 3スロットを備えており、高速ネットワーク接続を提供し、更なる機能と追加のアプリケーションの可能性を付加することができます。また、システムのアップタイムを最大化するために冗長電源を搭載しています。

AMD Ryzen™および最大64GBのRAMによる絶対的なパフォーマンス

AES-NI暗号化アクセラレーションと最大64GB DDR4 RAMを備え、4コア/8スレッドAMD Ryzen™ V1500B 2.2GHzプロセッサを搭載したラックマウントGNASⅢ-RM2U12Bは、積極的ながらパワースマートなパフォーマンスを提供し、 VDI、R&D、プライベートクラウドやサーバー仮想化などのリソースを多く消費するビジネスアプリケーションをドライブします。

マル2.5GbEネットワーキングにアップグレード

GNASⅢ-RM2U12Bには、2つの2.5GbE RJ45 LANポートが付属しています。このポートは、既存のカテゴリー5eケーブルを使用して、ネットワーク速度を1 ギガビットから2.5ギガビットにアップグレードできます。ポートトランキングを使用することで、5GbEの速度を達成できます。ラップトップやデスクトップをアップグレードして、高速ネットワークを活用できるように、GNASⅢ-RM2U12BはUSB 3.2 Gen 1 to 5GbEアダプターと5GbE PCIe拡張カードなどを含む、さまざまなアダプターと周辺機器を提供しています。

SSDキャッシングによるIOPSパフォーマンスの高速化

GNASⅢ-RM2U12BへのSSDキャッシュ追加は、IOPSパフォーマンスを向上し、ストレージボリュームレイテンシーを低減させるための簡単な方法です。IOPSを要求するアプリケーション(データベースや仮想化を含む)に理想的です。また、全体的なワークフローを大幅に向上できます。必要に応じて、起動、停止、または設定の変更を、システムをシャットダウンすることなく行うことができます。

必要な時にはいつでも、柔軟にストレージ容量を拡張します

GNAS-RM1U4Bのストレージ容量は、データ需要の増加に合わせて容易に拡張できます。ストレージ容量を拡張するには、必要に応じて、TR RAID拡張エンクロージャやTL JBODを接続するだけです。仮想JBOD(VJBOD)テクノロジーにより、GNAS-RM1U4Bの未使用のスペースが他のGNASのストレージ容量を拡張するために使用されます。

強力なAMD Ryzen™ V1000シリーズV1500Bクアッドコアプロセッサを搭載したGNASⅢ-RM2U12Bは、仮想マシンのパフォーマンスを最大2.2GHzの4コア/8スレッドまでブーストできます。2つの2.5GbEポートと2つのPCIe Gen 3スロットを備えており、高速ネットワーク接続を提供し、更なる機能と追加のアプリケーションの可能性を付加することができます。また、システムのアップタイムを最大化するために冗長電源を搭載しています。

AMD Ryzen™および最大64GBのRAMによる絶対的なパフォーマンス

AES-NI暗号化アクセラレーションと最大64GB DDR4 RAMを備え、4コア/8スレッドAMD Ryzen™ V1500B 2.2GHzプロセッサを搭載したラックマウントGNASⅢ-RM2U12Bは、積極的ながらパワースマートなパフォーマンスを提供し、 VDI、R&D、プライベートクラウドやサーバー仮想化などのリソースを多く消費するビジネスアプリケーションをドライブします。

マル2.5GbEネットワーキングにアップグレード

GNASⅢ-RM2U12Bには、2つの2.5GbE RJ45 LANポートが付属しています。このポートは、既存のカテゴリー5eケーブルを使用して、ネットワーク速度を1 ギガビットから2.5ギガビットにアップグレードできます。ポートトランキングを使用することで、5GbEの速度を達成できます。ラップトップやデスクトップをアップグレードして、高速ネットワークを活用できるように、GNASⅢ-RM2U12BはUSB 3.2 Gen 1 to 5GbEアダプターと5GbE PCIe拡張カードなどを含む、さまざまなアダプターと周辺機器を提供しています。

SSDキャッシングによるIOPSパフォーマンスの高速化

GNASⅢ-RM2U12BへのSSDキャッシュ追加は、IOPSパフォーマンスを向上し、ストレージボリュームレイテンシーを低減させるための簡単な方法です。IOPSを要求するアプリケーション(データベースや仮想化を含む)に理想的です。また、全体的なワークフローを大幅に向上できます。必要に応じて、起動、停止、または設定の変更を、システムをシャットダウンすることなく行うことができます。

必要な時にはいつでも、柔軟にストレージ容量を拡張します

GNAS-RM1U4Bのストレージ容量は、データ需要の増加に合わせて容易に拡張できます。ストレージ容量を拡張するには、必要に応じて、TR RAID拡張エンクロージャやTL JBODを接続するだけです。仮想JBOD(VJBOD)テクノロジーにより、GNAS-RM1U4Bの未使用のスペースが他のGNASのストレージ容量を拡張するために使用されます。

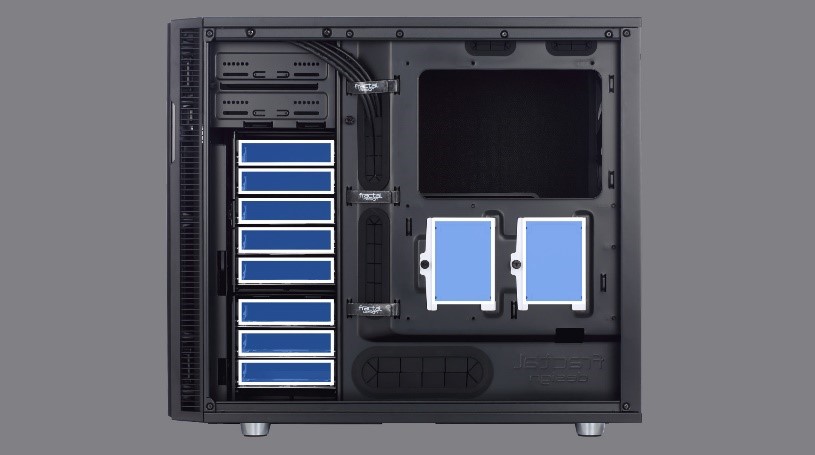

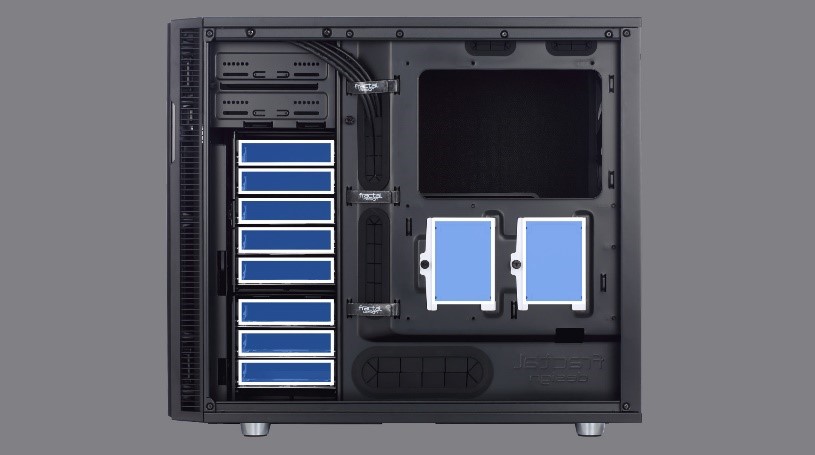

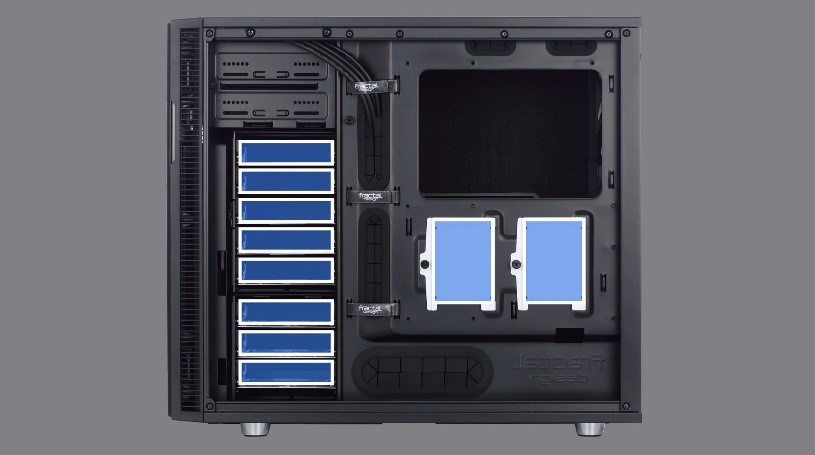

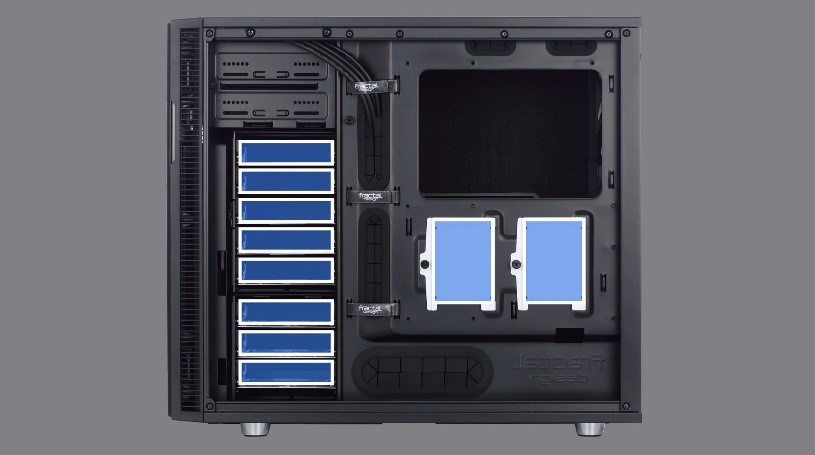

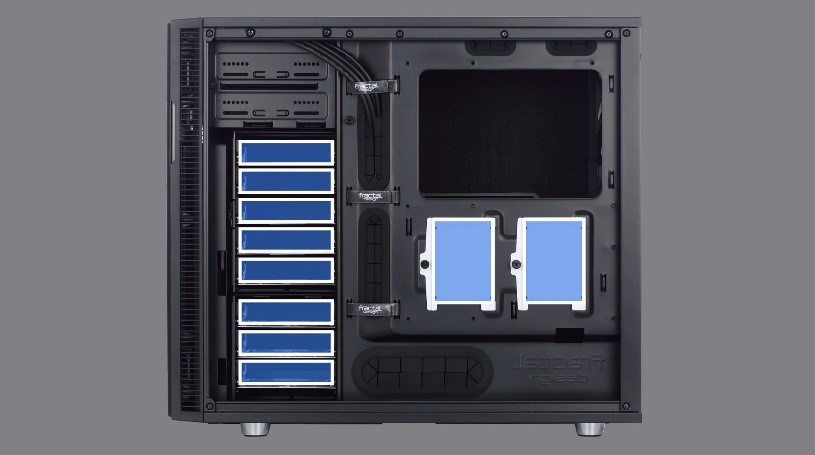

UNI-i9ZR/Silentは第14世代インテル® Core™ プロセッサー(コードネーム:Raptor Lake Refresh)を搭載した静音モデルです。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

最新のインテル® Core™ プロセッサー(第14世代)はRaptor Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

Intel® B760チップセット

第14世代 intel Coreプロセッサ対応 intel B760搭載ATXマザーボードを採用。PCIe5.0対応PCIe×16スロット、USB3.2 Gen2×1 Type-C、3つのPCIe4.0接続対応M.2スロット、Realtek 2.5GbE等を搭載。従来のDIPスタイルのPCIeスロットと比較して、SMT(表面実装技術)タイプのPCIe スロットは、信号の流れを改善し高速での安定性を最大化しています。

CPUクーラーに「こだわり」の空冷システムメーカー Noctua搭載

ナローヒートシンクデザインを使用した、12cmファン搭載サイドフロー型のCPUクーラーを採用。スリム設計により、CPUソケット周辺のクリアランスを確保。メモリとの干渉も最小限に抑えこんでいます。

負荷 40% 以下でのセミファンレスモード& ハイブリッドスイッチ搭載 80 PLUS Gold認証の静音電源

高効率を実現できるハーフブリッジ形 LLC方式 DC/DCコンバータに、日本製コンデンサを100% 使用し、プロフェッショナルグレードの品質を実現しつつ、本体のハイブリッドスイッチで ON/OFFを切替可能なセミファンレスモードを搭載することにより、静音性と冷却性にも優れ た 80 PLUS Gold 認証 850W電源です。

ノイズを最小限に抑え、冷却効率に優れたSILENCIOデザイン

Silencioは、ソフトで厚みのあるフォーム材から高密度ビニールまで、特定の周波数を正確に打 ち消すために複数の遮音材を組み合わせて使用しています。 スチールフロントパネルは、開く方向を左右どちらにも変えることができるリバーシブルシス テムを採用しています。スチール部分に取付けられた厚みのある緩衝材と、マグネットとゴム パッドを使用したヒンジシステムによって、パーツ同士の接触部分の振動を抑えています。

UNI-i9ZR/Silentは第14世代インテル® Core™ プロセッサー(コードネーム:Raptor Lake Refresh)を搭載した静音モデルです。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

最新のインテル® Core™ プロセッサー(第14世代)はRaptor Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

Intel® Z790チップセット

ビジネス向け 第13世代 intel Coreプロセッサ対応 intel Z790搭載ATXマザーボードを採用。PCIe5.0対応PCIe×16スロット、USB3.2 Gen2×2 Type-C、3つのPCIe4.0×4接続対応M.2スロット、PCIe3.0×4接続対応M.2スロット、intel 2.5GbE等を搭載。CPUとの接続にはDMI4.0x8が採用され、チップセットとCPU間のボトルネックが解消されています。

CPUクーラーに「こだわり」の空冷システムメーカー Noctua搭載

ナローヒートシンクデザインを使用した、12cmファン搭載サイドフロー型のCPUクーラーを採用。スリム設計により、CPUソケット周辺のクリアランスを確保。メモリとの干渉も最小限に抑えこんでいます。

負荷 40% 以下でのセミファンレスモード& ハイブリッドスイッチ搭載 80 PLUS Gold認証の静音電源

高効率を実現できるハーフブリッジ形 LLC方式 DC/DCコンバータに、日本製コンデンサを100% 使用し、プロフェッショナルグレードの品質を実現しつつ、本体のハイブリッドスイッチで ON/OFFを切替可能なセミファンレスモードを搭載することにより、静音性と冷却性にも優れ た 80 PLUS Gold 認証 850W電源です。

ノイズを最小限に抑え、冷却効率に優れたSILENCIOデザイン

Silencioは、ソフトで厚みのあるフォーム材から高密度ビニールまで、特定の周波数を正確に打 ち消すために複数の遮音材を組み合わせて使用しています。 スチールフロントパネルは、開く方向を左右どちらにも変えることができるリバーシブルシス テムを採用しています。スチール部分に取付けられた厚みのある緩衝材と、マグネットとゴム パッドを使用したヒンジシステムによって、パーツ同士の接触部分の振動を抑えています。

UNI-i9ZR/Silentは第14世代インテル® Core™ プロセッサー(コードネーム:Raptor Lake Refresh)を搭載した静音モデルです。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

最新のインテル® Core™ プロセッサー(第14世代)はRaptor Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

Intel® Z790チップセット

ビジネス向け 第13世代 intel Coreプロセッサ対応 intel Z790搭載ATXマザーボードを採用。PCIe5.0対応PCIe×16スロット、USB3.2 Gen2×2 Type-C、3つのPCIe4.0×4接続対応M.2スロット、PCIe3.0×4接続対応M.2スロット、intel 2.5GbE等を搭載。CPUとの接続にはDMI4.0x8が採用され、チップセットとCPU間のボトルネックが解消されています。

CPUクーラーに「こだわり」の空冷システムメーカー Noctua搭載

ナローヒートシンクデザインを使用した、12cmファン搭載サイドフロー型のCPUクーラーを採用。スリム設計により、CPUソケット周辺のクリアランスを確保。メモリとの干渉も最小限に抑えこんでいます。

負荷 40% 以下でのセミファンレスモード& ハイブリッドスイッチ搭載 80 PLUS Gold認証の静音電源

高効率を実現できるハーフブリッジ形 LLC方式 DC/DCコンバータに、日本製コンデンサを100% 使用し、プロフェッショナルグレードの品質を実現しつつ、本体のハイブリッドスイッチで ON/OFFを切替可能なセミファンレスモードを搭載することにより、静音性と冷却性にも優れ た 80 PLUS Gold 認証 850W電源です。

ノイズを最小限に抑え、冷却効率に優れたSILENCIOデザイン

Silencioは、ソフトで厚みのあるフォーム材から高密度ビニールまで、特定の周波数を正確に打 ち消すために複数の遮音材を組み合わせて使用しています。 スチールフロントパネルは、開く方向を左右どちらにも変えることができるリバーシブルシス テムを採用しています。スチール部分に取付けられた厚みのある緩衝材と、マグネットとゴム パッドを使用したヒンジシステムによって、パーツ同士の接触部分の振動を抑えています。

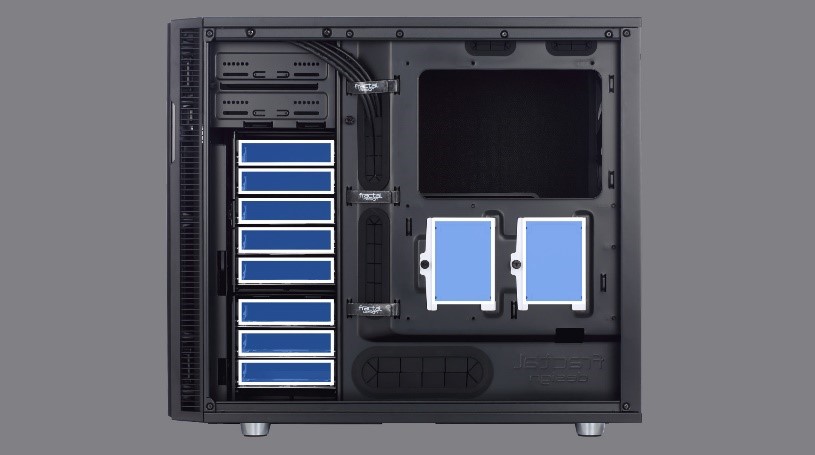

UNI-i9ZRは、第14世代 Intel® Core™ デスクトッププロセッサ(Raptor Lake-S Refresh)を搭載したモデルです。前世代の Alder Lake-S と比較して、クロックの向上に加え、キャッシュメモリ容量の増加や E-CORE のコア数拡張により、大幅な性能向上を実現しました。Raptor Cove を採用した高性能コア(P-CORE)と、Gracemont を採用した高効率コア(E-CORE)によるハイブリッド構成により、最大24コアを搭載可能です。これにより、効率的なコア利用が可能となり、高精細コンテンツの処理性能向上はもちろん、高速演算、シミュレーション、グラフィック作業など、CPUパワーを必要とする幅広い作業において高いパフォーマンスを提供します。

第14世代 Intel® Core™ デスクトッププロセッサ(Raptor Lake-S Refresh)搭載

第14世代 インテル® Core™ プロセッサー(コードネーム:Raptor Lake-S Refresh)は、Raptor Cove 高性能CPUコア(P-CORE)と Gracemont 高効率CPUコア(E-CORE)によるハイブリッド構成を採用し、最大24コアを搭載する最新アーキテクチャです。前世代からの改良によりクロックが向上し、キャッシュメモリの強化や E-CORE 数の拡張によって、さらなる性能向上を実現しています。効率的なコア運用により、没入感のある高精細ゲームの描画性能向上はもちろん、4K 以上のビデオ編集、映像制作、仮想現実(VR)など、最新の映像・クリエイティブワークにおいても優れたパフォーマンスを発揮し、卓越したエンターテインメント体験を提供します。

Intel® B760チップセット

第14世代 intel Coreプロセッサ対応 intel B760搭載ATXマザーボードを採用。PCIe5.0対応PCIe×16スロット、USB3.2 Gen2×1 Type-C、3つのPCIe4.0接続対応M.2スロット、Realtek 2.5GbE等を搭載。従来のDIPスタイルのPCIeスロットと比較して、SMT(表面実装技術)タイプのPCIe スロットは、信号の流れを改善し高速での安定性を最大化しています。

PCI-Express 5.0 に対応

Alder Lake-SのCPU及び、Z690マザーボードは最新のPCI-Express 5.0に対応しており、従来のPCI-Express 4.0に比べて2倍の転送速度を持っております。x1で4GB/s、x4で16GB/s、x8で32GB/s、x16で64GB/sの転送速度を発揮します。最大レーン数がx4に縛られるM.2接続の機器などでは大きな恩恵を受ける事が可能です。特にM.2接続のNVMe SSDでは現在最新のPCIe 4.0ではx4接続では理論上は最大8GB/sの転送速度が実現可能となっていますが、既にPCIe 4.0対応のNVMe SSDでは最大リード速度が7GB/sに達している製品が多く、既にPCIe 4.0の規格上限値に限りなく近くなっておりました。これが、PCIe 5.0対応となると最大16GB/sまで理論的には対応可能になるため、現行の約2倍高速なNVMe SSDが搭載可能となります。

最大5基のストレージベイを搭載

HDD ケージシステムには 3.5 インチまたは 2.5 インチドライブを最大 5台まで設置可能、従来よりも更に優れた拡張性を実現。ユーザー個人の好みに応じてケースレイアウトを変更可能です。

UNI-i9ZRは第13世代インテル® Core™ プロセッサー(コードネーム:Raptor Lake-S)を搭載したモデルです。

第13世代インテル® Core™プロセッサー “Raptor Lake-S”搭載

第13世代インテル® Core™ プロセッサー(コードネーム:RaptorLake-S)はRaptor Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。

Intel® Z790チップセット

ビジネス向け 第13世代 intel Coreプロセッサ対応 intel Z790搭載ATXマザーボードを採用。PCIe5.0対応PCIe×16スロット、USB3.2 Gen2×2 Type-C、3つのPCIe4.0×4接続対応M.2スロット、PCIe3.0×4接続対応M.2スロット、intel 2.5GbE等を搭載。CPUとの接続にはDMI4.0x8が採用され、チップセットとCPU間のボトルネックが解消されています。

PCI-Express 5.0 に対応

Alder Lake-SのCPU及び、Z690マザーボードは最新のPCI-Express 5.0に対応しており、従来のPCI-Express 4.0に比べて2倍の転送速度を持っております。x1で4GB/s、x4で16GB/s、x8で32GB/s、x16で64GB/sの転送速度を発揮します。最大レーン数がx4に縛られるM.2接続の機器などでは大きな恩恵を受ける事が可能です。特にM.2接続のNVMe SSDでは現在最新のPCIe 4.0ではx4接続では理論上は最大8GB/sの転送速度が実現可能となっていますが、既にPCIe 4.0対応のNVMe SSDでは最大リード速度が7GB/sに達している製品が多く、既にPCIe 4.0の規格上限値に限りなく近くなっておりました。これが、PCIe 5.0対応となると最大16GB/sまで理論的には対応可能になるため、現行の約2倍高速なNVMe SSDが搭載可能となります。

最大5基のストレージベイを搭載

HDD ケージシステムには 3.5 インチまたは 2.5 インチドライブを最大 5台まで設置可能、従来よりも更に優れた拡張性を実現。ユーザー個人の好みに応じてケースレイアウトを変更可能です。

UNI-i9ZRは第13世代インテル® Core™ プロセッサー(コードネーム:Raptor Lake-S)を搭載したモデルです。

第13世代インテル® Core™プロセッサー “Raptor Lake-S”搭載

第13世代インテル® Core™ プロセッサー(コードネーム:RaptorLake-S)はRaptor Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。

Intel® Z790チップセット

ビジネス向け 第13世代 intel Coreプロセッサ対応 intel Z790搭載ATXマザーボードを採用。PCIe5.0対応PCIe×16スロット、USB3.2 Gen2×2 Type-C、3つのPCIe4.0×4接続対応M.2スロット、PCIe3.0×4接続対応M.2スロット、intel 2.5GbE等を搭載。CPUとの接続にはDMI4.0x8が採用され、チップセットとCPU間のボトルネックが解消されています。

PCI-Express 5.0 に対応

Alder Lake-SのCPU及び、Z690マザーボードは最新のPCI-Express 5.0に対応しており、従来のPCI-Express 4.0に比べて2倍の転送速度を持っております。x1で4GB/s、x4で16GB/s、x8で32GB/s、x16で64GB/sの転送速度を発揮します。最大レーン数がx4に縛られるM.2接続の機器などでは大きな恩恵を受ける事が可能です。特にM.2接続のNVMe SSDでは現在最新のPCIe 4.0ではx4接続では理論上は最大8GB/sの転送速度が実現可能となっていますが、既にPCIe 4.0対応のNVMe SSDでは最大リード速度が7GB/sに達している製品が多く、既にPCIe 4.0の規格上限値に限りなく近くなっておりました。これが、PCIe 5.0対応となると最大16GB/sまで理論的には対応可能になるため、現行の約2倍高速なNVMe SSDが搭載可能となります。

最大5基のストレージベイを搭載

HDD ケージシステムには 3.5 インチまたは 2.5 インチドライブを最大 5台まで設置可能、従来よりも更に優れた拡張性を実現。ユーザー個人の好みに応じてケースレイアウトを変更可能です。

最新インテル第14世代 コードネーム Raptor Lake-S Refresh(ラプターレイクリフレッシュ)を搭載したデスクサイドGPUワークステーションです。Pコア+Eコア合計24コアで 最大Thermal Velocity Boost 6.0GHz動作の「Inte® Core™ i9-14900KF」をはじめとした」ラインナップによりCPU性能を大幅に向上させています。また、プラットフォームでは PCIe 5.0をサポート 、最大16のPCI Express 5.0レーンにより、RTX 4090 をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

※注意:このモデルはCPU 仕様によりPCIe Lanes数は20までとなり、2枚のGPUを搭載可能ですが、1枚目はx16転送レート(理論値 256.0Gbps)、2枚目はx4転送レート(理論値 64.0Gbps)での動作となります。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第 4 世代 Tensor コアにより Tensor コアは、新しい FP8 Transformer エンジンを使用して、驚異的に速い、最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現し、Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。これらプロフェッショナル グラフィックス、AI、コンピューティング性能を実現するために設計されていおります。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

最新のインテル® Core™ プロセッサー(第14世代)はRaptor Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

最新インテル第14世代 コードネーム Raptor Lake-S Refresh(ラプターレイクリフレッシュ)を搭載したデスクサイドGPUワークステーションです。Pコア+Eコア合計24コアで 最大Thermal Velocity Boost 6.0GHz動作の「Inte® Core™ i9-14900KF」をはじめとした」ラインナップによりCPU性能を大幅に向上させています。また、プラットフォームでは PCIe 5.0をサポート 、最大16のPCI Express 5.0レーンにより、RTX 4090 をはじめとする 次世代 NVIDIA Ada Lovelace アーキテクチャ GPU搭載で最適に動作することができ、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要する作業に満足のいくパフォーマンスを提供できるモデルです。

※注意:このモデルはCPU 仕様によりPCIe Lanes数は20までとなり、2枚のGPUを搭載可能ですが、1枚目はx16転送レート(理論値 256.0Gbps)、2枚目はx4転送レート(理論値 64.0Gbps)での動作となります。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第 4 世代 Tensor コアにより Tensor コアは、新しい FP8 Transformer エンジンを使用して、驚異的に速い、最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現し、Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。これらプロフェッショナル グラフィックス、AI、コンピューティング性能を実現するために設計されていおります。

第14世代インテル® Core™プロセッサー “Raptor Lake Refresh”搭載

最新のインテル® Core™ プロセッサー(第14世代)はRaptor Cove 高性能CPUコア(P-CORE)とGracemont 高効率CPUコア(E-CORE)によるハイブリッド構成の全く新しい新アーキテクチャで最大24コアを搭載。効率的なコアの使用により没入感のある高精細なゲームのパフォーマンス向上をはじめ、4K超ビデオコンテンツ制作などの最新の映像体験において驚異のエンターテインメント・ハブを提供します。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

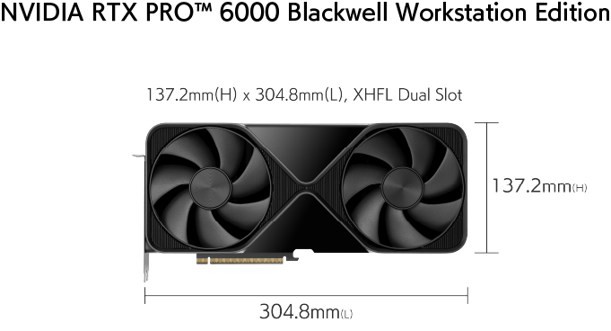

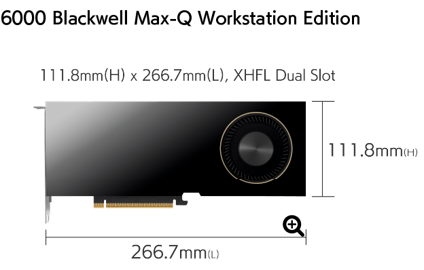

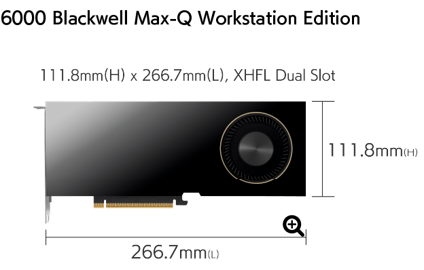

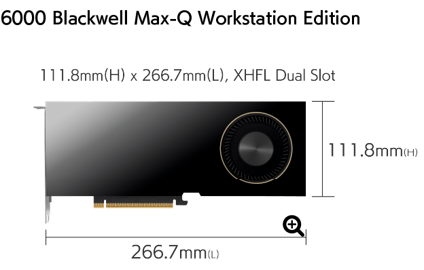

GWS-IARGA-1Gは、Intel® Core™ Ultra プロセッサを採用し、Performanceコア(Pコア)とEfficiencyコア(Eコア)によるハイブリッド・アーキテクチャを実装しています。これにより、スレッドレベルでの動的スケジューリングが最適化され、シングルスレッド性能を要する処理から並列性の高いマルチスレッド処理まで、タスク負荷に応じた効率的なリソース配分が可能です。またGPUには、RTX™ 6000 Blackwell Max-Q Workstation Edition、RTX™ 6000 Blackwell Workstation Edition、またはNVIDIA GeForce RTX 5090のいずれかを搭載可能。これらのGPUは、Blackwell アーキテクチャによるFP8/FP16演算性能と高帯域のメモリ帯域幅を備えており、AIモデルの学習・推論、3Dレンダリング、ディープラーニング推論などGPUコンピュート負荷の高いワークロードにおいて卓越した処理スループットを発揮します。加えて、最大256GBのDDR5メモリをサポートしており、大規模データセットやマルチアプリケーション環境でも安定した処理性能を維持できます。同時に、システムドライブとしてセットアップされたM.2 SSDにより、OSおよび主要アプリケーションの起動を高速化します。その上、データ用ストレージスロットを2基備え、プロジェクトごとのデータ分離や作業用・保管用データの効率的運用が可能です。

カスタマイズメニューに無い構成はお気軽に弊社までお問い合わせ下さい。お客様のご要望に合わせて抜群のコストパフォーマンスと安定した利用環境をご提供します。

NVIDIA RTX PRO 6000 Blackwell シリーズ製品比較レポート

Intel Core Ultra を採用

GWS-IARGA-1Gは、Intel Core Ultra を搭載することで、AI時代に最適化された高性能環境を実現します。高性能コア(Pコア)と高効率コア(Eコア)がリアルタイムにタスクを解析し、負荷に応じて自動的に最適化。これにより、重いAI演算から軽いバックグラウンド処理まで、あらゆるワークロードで安定した処理能力を発揮します。さらに、AI専用エンジン NPU(Neural Processing Unit)により、生成AIや機械学習、データ解析といった高度なAIワークロードも効率的に実行可能です。内蔵の Intel Arc GPU がグラフィック処理を強化し、3Dレンダリングや科学計算、AI推論などもスムーズに処理できます。また高速メモリや PCIe Gen 5 SSD との連携により、大規模データの読み書きも高速化。これにより、AI開発や解析作業、シミュレーションなど、多様な業務において卓越した演算性能と安定性を提供します。

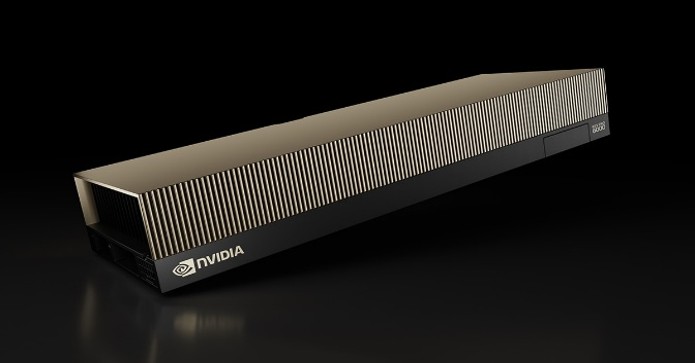

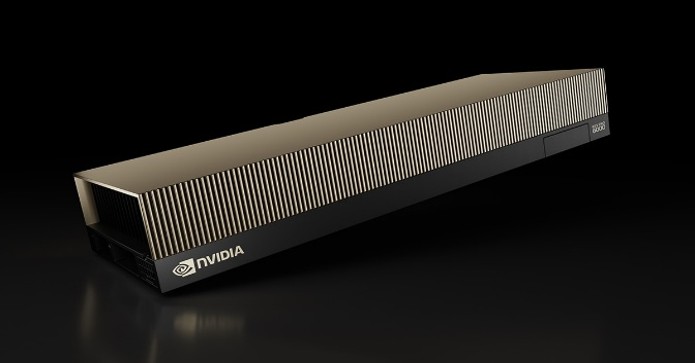

最大1基の高性能GPUを搭載

GWS-IARGA-1Gは、Blackwell GPU を搭載することで、GPU負荷の高い処理を高速かつ効率的に実行できます。高度な並列演算能力を持つ Blackwell アーキテクチャにより、AIモデルの学習や推論、大規模データ解析を迅速に処理。さらに、リアルタイムレンダリングや3Dグラフィックス計算も滑らかに実行でき、複雑なシミュレーションや高度な解析作業でも優れた演算性能を発揮します。Blackwell GPU は専用の高速メモリを備えており、大量データをGPU内で直接処理可能です。加えて、CPUやストレージからGPUへのデータ転送速度が向上しているため、GPUがデータ待ちになる時間を最小化。これにより、大規模データや複数のAIタスクも滞りなく処理でき、GPUの演算能力をフルに活かすことができます。AI開発、科学計算、生成AIモデルの推論など、多様なGPUワークロードにおいて、Blackwell GPU は高効率な並列演算能力と持続的安定動作を提供します。

効率化ストレージ設計

GWS-IARGA-1Gは、M.2 SSD をブートストレージに採用することで、OS やアプリケーションの起動時間を大幅に短縮し、システム全体の応答性と操作感を向上させます。さらに、データ用ストレージを2枚搭載することで、大容量データの管理や複数プロジェクトの同時運用が容易になり、柔軟なデータ整理と効率的なバックアップ運用を実現します。これにより、業務中の待機時間を最小化するとともに、解析作業やAI処理、シミュレーションなどの大量データを扱う高度な作業でも、安定かつスムーズなワークフローを維持できます。加えて、M.2 SSDとデータ用ストレージの組み合わせにより、ストレージ間のデータ移動や読み書きも高速化され、全体的な作業効率をさらに高めることが可能です。

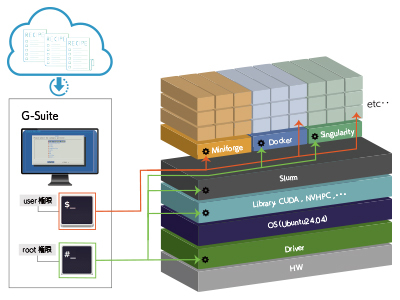

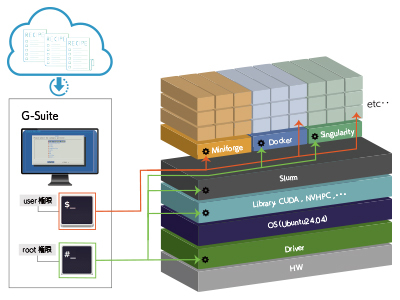

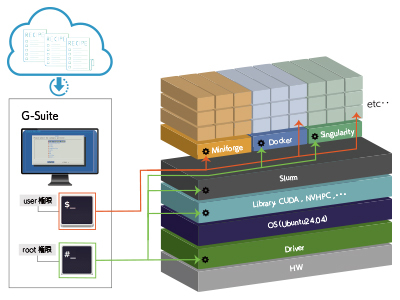

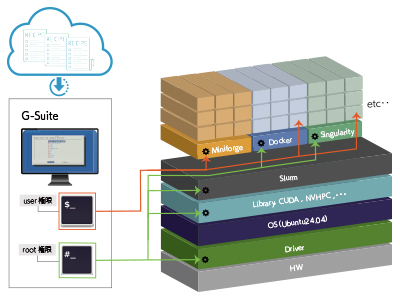

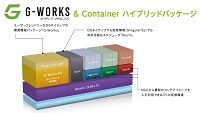

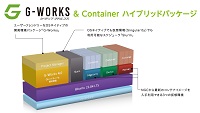

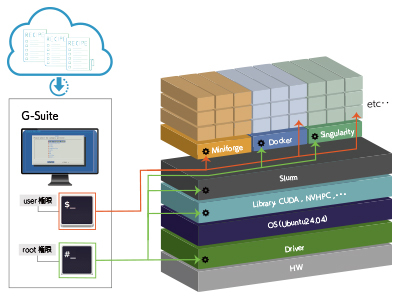

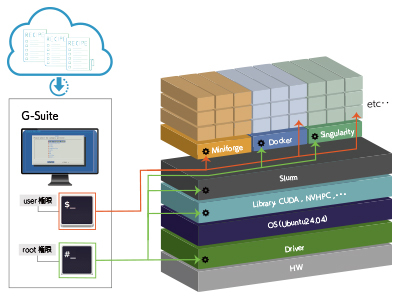

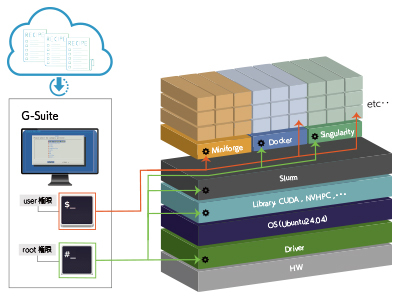

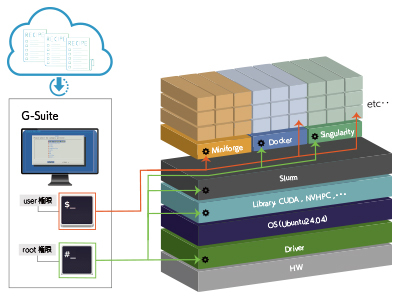

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。

Ubuntu 22.04に対応する「G-Works4.0」を選択されたい場合は こちら からご覧ください。

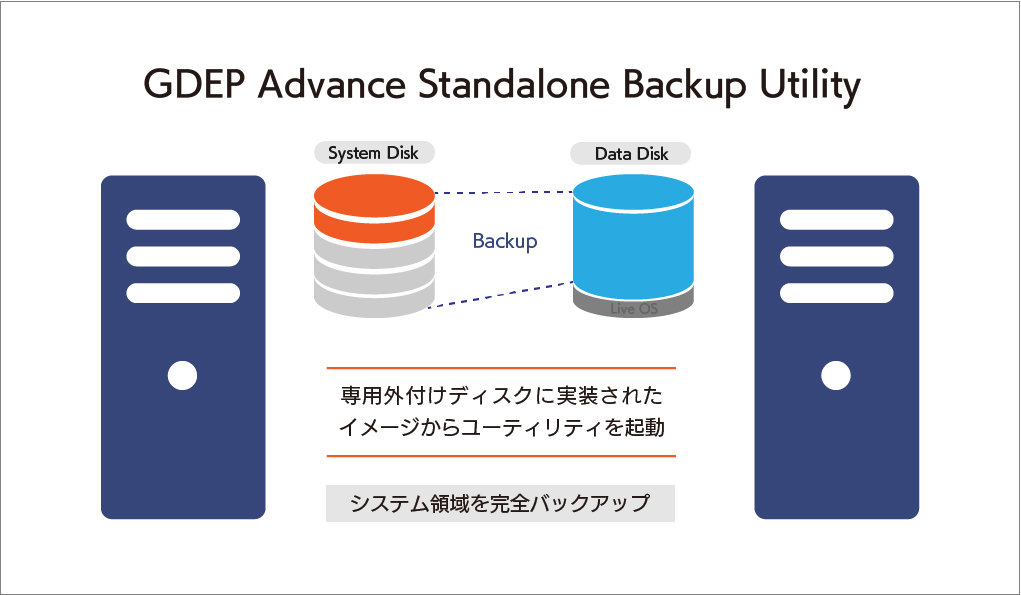

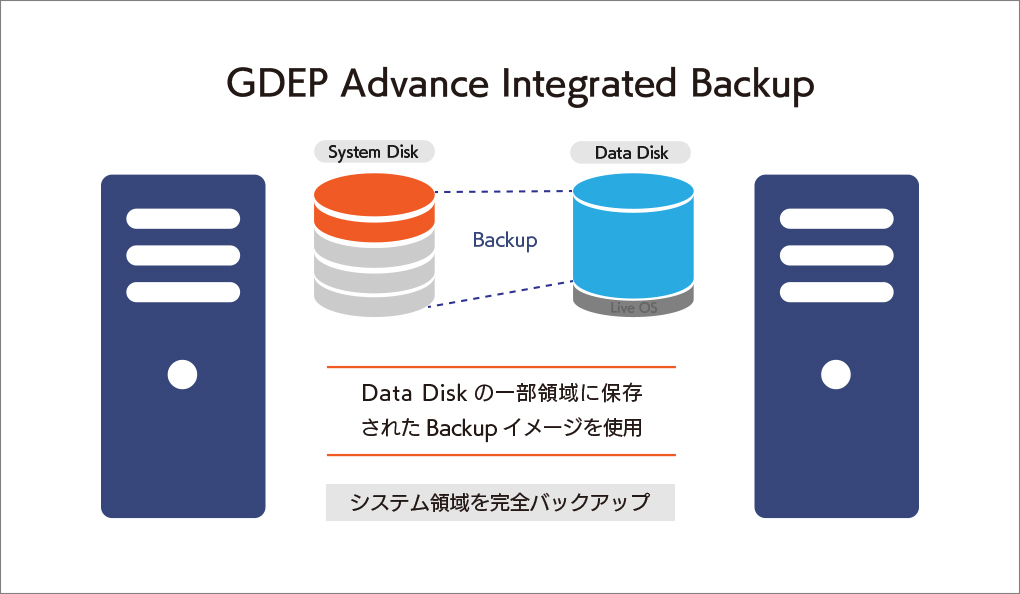

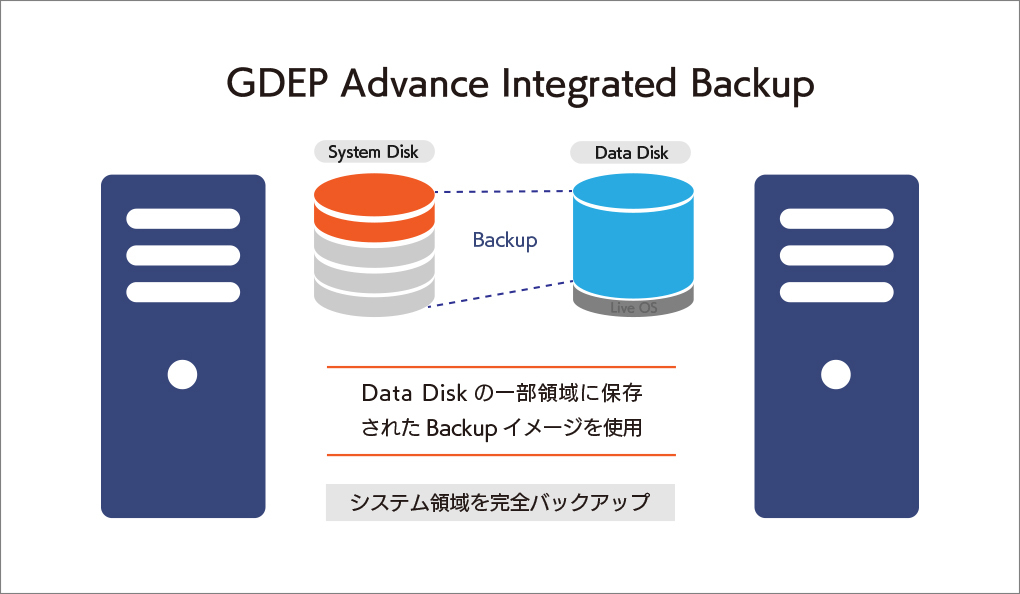

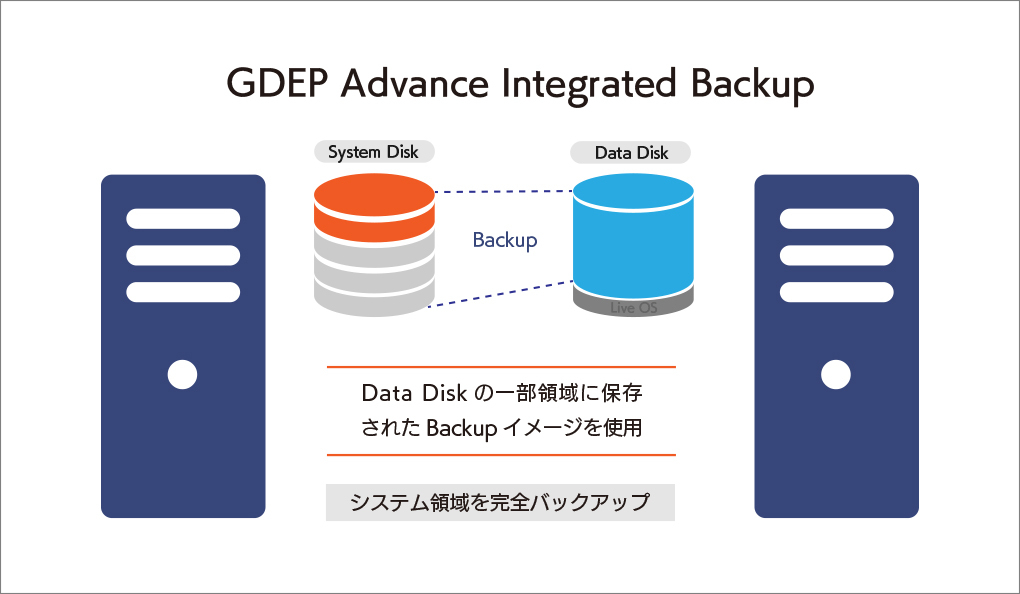

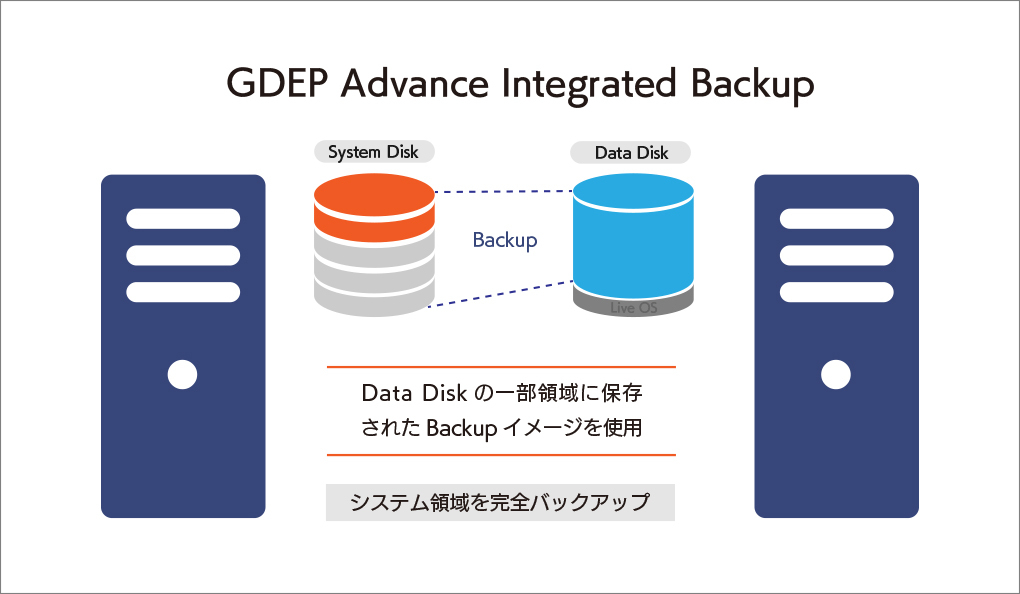

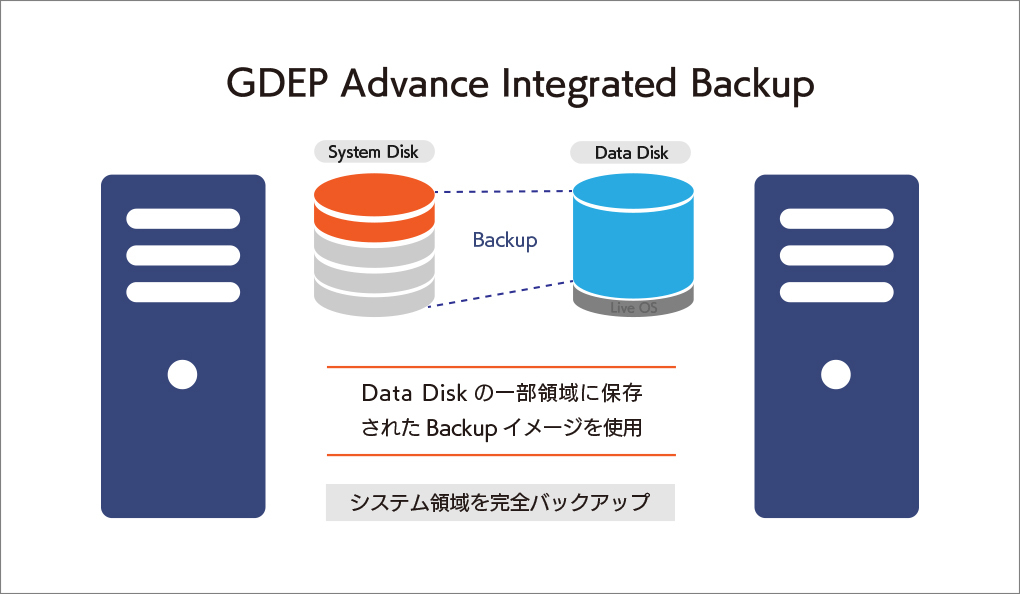

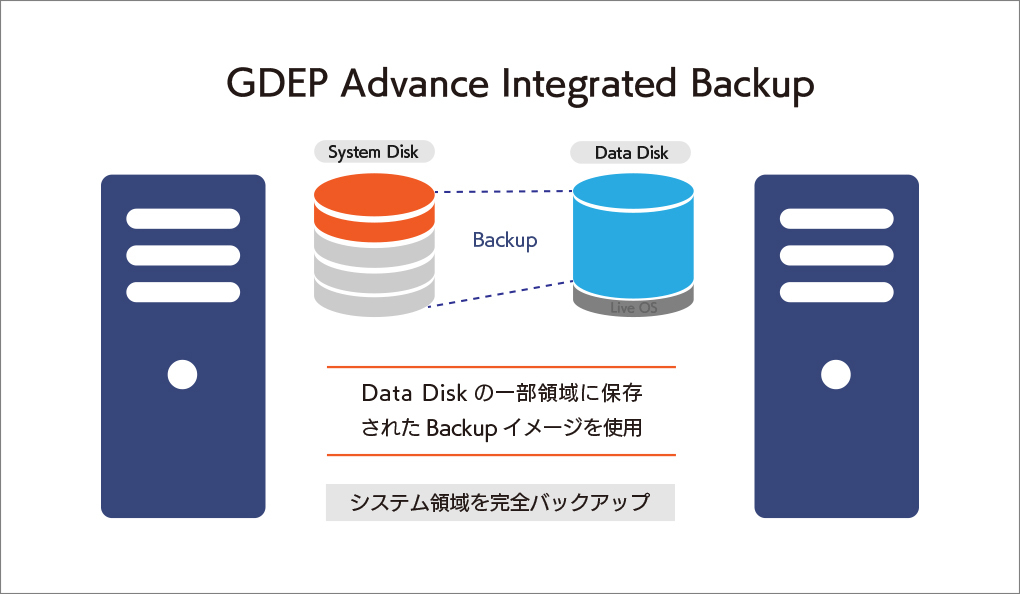

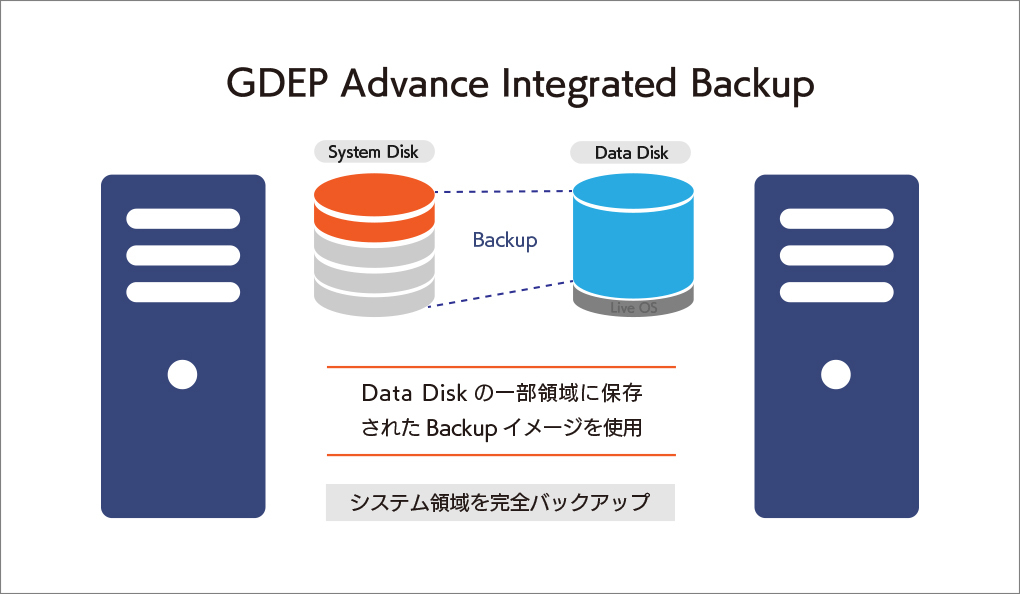

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。 システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。 【動作条件】 ・システムディスク以外にデータディスクが一つ以上装備されている必要があります。 ・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。 ・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。 ・バックアップデータは日付別に分類されて保存されます。

GWS-IARGA-1Gは、Intel® Core™ Ultra プロセッサを採用し、Performanceコア(Pコア)とEfficiencyコア(Eコア)によるハイブリッド・アーキテクチャを実装しています。これにより、スレッドレベルでの動的スケジューリングが最適化され、シングルスレッド性能を要する処理から並列性の高いマルチスレッド処理まで、タスク負荷に応じた効率的なリソース配分が可能です。またGPUには、RTX™ 6000 Blackwell Max-Q Workstation Edition、RTX™ 6000 Blackwell Workstation Edition、またはNVIDIA GeForce RTX 5090のいずれかを搭載可能。これらのGPUは、Blackwell アーキテクチャによるFP8/FP16演算性能と高帯域のメモリ帯域幅を備えており、AIモデルの学習・推論、3Dレンダリング、ディープラーニング推論などGPUコンピュート負荷の高いワークロードにおいて卓越した処理スループットを発揮します。加えて、最大256GBのDDR5メモリをサポートしており、大規模データセットやマルチアプリケーション環境でも安定した処理性能を維持できます。同時に、システムドライブとしてセットアップされたM.2 SSDにより、OSおよび主要アプリケーションの起動を高速化します。その上、データ用ストレージスロットを2基備え、プロジェクトごとのデータ分離や作業用・保管用データの効率的運用が可能です。 カスタマイズメニューに無い構成はお気軽に弊社までお問い合わせ下さい。お客様のご要望に合わせて抜群のコストパフォーマンスと安定した利用環境をご提供します。

Intel Core Ultra を採用

GWS-IARGA-1Gは、Intel Core Ultra を搭載することで、AI時代に最適化された高性能環境を実現します。高性能コア(Pコア)と高効率コア(Eコア)がリアルタイムにタスクを解析し、負荷に応じて自動的に最適化。これにより、重いAI演算から軽いバックグラウンド処理まで、あらゆるワークロードで安定した処理能力を発揮します。さらに、AI専用エンジン NPU(Neural Processing Unit)により、生成AIや機械学習、データ解析といった高度なAIワークロードも効率的に実行可能です。内蔵の Intel Arc GPU がグラフィック処理を強化し、3Dレンダリングや科学計算、AI推論などもスムーズに処理できます。また高速メモリや PCIe Gen 5 SSD との連携により、大規模データの読み書きも高速化。これにより、AI開発や解析作業、シミュレーションなど、多様な業務において卓越した演算性能と安定性を提供します。

最大1基の高性能GPUを搭載

GWS-IARGA-1Gは、Blackwell GPU を搭載することで、GPU負荷の高い処理を高速かつ効率的に実行できます。高度な並列演算能力を持つ Blackwell アーキテクチャにより、AIモデルの学習や推論、大規模データ解析を迅速に処理。さらに、リアルタイムレンダリングや3Dグラフィックス計算も滑らかに実行でき、複雑なシミュレーションや高度な解析作業でも優れた演算性能を発揮します。Blackwell GPU は専用の高速メモリを備えており、大量データをGPU内で直接処理可能です。加えて、CPUやストレージからGPUへのデータ転送速度が向上しているため、GPUがデータ待ちになる時間を最小化。これにより、大規模データや複数のAIタスクも滞りなく処理でき、GPUの演算能力をフルに活かすことができます。AI開発、科学計算、生成AIモデルの推論など、多様なGPUワークロードにおいて、Blackwell GPU は高効率な並列演算能力と持続的安定動作を提供します。

効率化ストレージ設計

GWS-IARGA-1Gは、M.2 SSD をブートストレージに採用することで、OS やアプリケーションの起動時間を大幅に短縮し、システム全体の応答性と操作感を向上させます。さらに、データ用ストレージを2枚搭載することで、大容量データの管理や複数プロジェクトの同時運用が容易になり、柔軟なデータ整理と効率的なバックアップ運用を実現します。これにより、業務中の待機時間を最小化するとともに、解析作業やAI処理、シミュレーションなどの大量データを扱う高度な作業でも、安定かつスムーズなワークフローを維持できます。加えて、M.2 SSDとデータ用ストレージの組み合わせにより、ストレージ間のデータ移動や読み書きも高速化され、全体的な作業効率をさらに高めることが可能です。

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。

Ubuntu 22.04に対応する「G-Works4.0」を選択されたい場合は こちら からご覧ください。

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。 システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。 【動作条件】 ・システムディスク以外にデータディスクが一つ以上装備されている必要があります。 ・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。 ・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。 ・バックアップデータは日付別に分類されて保存されます。

GWS-IARGA-1Gは、Intel® Core™ Ultra プロセッサを採用し、Performanceコア(Pコア)とEfficiencyコア(Eコア)によるハイブリッド・アーキテクチャを実装しています。これにより、スレッドレベルでの動的スケジューリングが最適化され、シングルスレッド性能を要する処理から並列性の高いマルチスレッド処理まで、タスク負荷に応じた効率的なリソース配分が可能です。またGPUには、RTX™ 6000 Blackwell Max-Q Workstation Edition、RTX™ 6000 Blackwell Workstation Edition、またはNVIDIA GeForce RTX 5090のいずれかを搭載可能。これらのGPUは、Blackwell アーキテクチャによるFP8/FP16演算性能と高帯域のメモリ帯域幅を備えており、AIモデルの学習・推論、3Dレンダリング、ディープラーニング推論などGPUコンピュート負荷の高いワークロードにおいて卓越した処理スループットを発揮します。加えて、最大256GBのDDR5メモリをサポートしており、大規模データセットやマルチアプリケーション環境でも安定した処理性能を維持できます。同時に、システムドライブとしてセットアップされたM.2 SSDにより、OSおよび主要アプリケーションの起動を高速化します。その上、データ用ストレージスロットを2基備え、プロジェクトごとのデータ分離や作業用・保管用データの効率的運用が可能です。 カスタマイズメニューに無い構成はお気軽に弊社までお問い合わせ下さい。お客様のご要望に合わせて抜群のコストパフォーマンスと安定した利用環境をご提供します。

Intel Core Ultra を採用

GWS-IARGA-1Gは、Intel Core Ultra を搭載することで、AI時代に最適化された高性能環境を実現します。高性能コア(Pコア)と高効率コア(Eコア)がリアルタイムにタスクを解析し、負荷に応じて自動的に最適化。これにより、重いAI演算から軽いバックグラウンド処理まで、あらゆるワークロードで安定した処理能力を発揮します。さらに、AI専用エンジン NPU(Neural Processing Unit)により、生成AIや機械学習、データ解析といった高度なAIワークロードも効率的に実行可能です。内蔵の Intel Arc GPU がグラフィック処理を強化し、3Dレンダリングや科学計算、AI推論などもスムーズに処理できます。また高速メモリや PCIe Gen 5 SSD との連携により、大規模データの読み書きも高速化。これにより、AI開発や解析作業、シミュレーションなど、多様な業務において卓越した演算性能と安定性を提供します。

最大1基の高性能GPUを搭載

GWS-IARGA-1Gは、Blackwell GPU を搭載することで、GPU負荷の高い処理を高速かつ効率的に実行できます。高度な並列演算能力を持つ Blackwell アーキテクチャにより、AIモデルの学習や推論、大規模データ解析を迅速に処理。さらに、リアルタイムレンダリングや3Dグラフィックス計算も滑らかに実行でき、複雑なシミュレーションや高度な解析作業でも優れた演算性能を発揮します。Blackwell GPU は専用の高速メモリを備えており、大量データをGPU内で直接処理可能です。加えて、CPUやストレージからGPUへのデータ転送速度が向上しているため、GPUがデータ待ちになる時間を最小化。これにより、大規模データや複数のAIタスクも滞りなく処理でき、GPUの演算能力をフルに活かすことができます。AI開発、科学計算、生成AIモデルの推論など、多様なGPUワークロードにおいて、Blackwell GPU は高効率な並列演算能力と持続的安定動作を提供します。

効率化ストレージ設計

GWS-IARGA-1Gは、M.2 SSD をブートストレージに採用することで、OS やアプリケーションの起動時間を大幅に短縮し、システム全体の応答性と操作感を向上させます。さらに、データ用ストレージを2枚搭載することで、大容量データの管理や複数プロジェクトの同時運用が容易になり、柔軟なデータ整理と効率的なバックアップ運用を実現します。これにより、業務中の待機時間を最小化するとともに、解析作業やAI処理、シミュレーションなどの大量データを扱う高度な作業でも、安定かつスムーズなワークフローを維持できます。加えて、M.2 SSDとデータ用ストレージの組み合わせにより、ストレージ間のデータ移動や読み書きも高速化され、全体的な作業効率をさらに高めることが可能です。

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。

Ubuntu 22.04に対応する「G-Works4.0」を選択されたい場合は こちら からご覧ください。

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。 システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。 【動作条件】 ・システムディスク以外にデータディスクが一つ以上装備されている必要があります。 ・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。 ・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。 ・バックアップデータは日付別に分類されて保存されます。

UNI-R5B はAMD B550 チップセットマザーボードに7nm製造プロセス ZEN3アーキテクチャーを採用したAMD Ryzen プロセッサーを搭載しています。最大8個のZen3コア、最大16MBのL3キャッシュ、DDR4-3200メモリに対応し、Radeonグラフィックによるパワフルなオンボードグラフィック機能を内蔵しています。CPUクーラーには世界屈指の空冷メーカー Noctua製「NH-U12S redux」を採用しており、メインストリーム系ながらハイエンドに迫る性能を発揮します。用途に応じ、内蔵グラフィックを使用したエントリーモデルからNVIDIA RTXシリーズを搭載したグラフィックWSモデルまで選択いただけるコストパフォーマンスに優れたモデルです。

AMD新APU Ryzen 5000Gシリーズ を採用

最大8コアを搭載したAMD Ryzen™ 5000シリーズ・デスクトップ・プロセッサーを利用することで、データの処理やコンテンツ制作を容易に遂行できるようになります。電力効率が高く、低発熱かつ静音な最先端の7nmテクノロジーで構築されたこのプロセッサーは、ミニ、スモール・フォームファクター、タワーなど、あらゆるサイズのデスクトップPCでハイパフォーマンスを実現します。

世界屈指の空冷最強メーカー Noctua製 「NH-U12S redux」を選択可能

メインストリーム系ながらハイエンドに迫る性能を発揮。ナローヒートシンクデザインを使用した、12cmファン搭載サイドフロー型のCPUクーラーです。

高品質な部品を採用し、安定性を重視したプロフェッショナルユーザー向けマザーボード

AMD B550チップセットマザーボードを採用。大型PWMヒートシンクと7W/mKのサーマルパッドがCPU温度を低く保ち、CPUの性能を高負荷時でも最大限に発揮します。ヘビーユーザーの要望に応える高い拡張性を備え、低遅延で高速なLANを搭載し、最新のストレージデバイスに対応しています。

UNI-R5B はAMD B550 チップセットマザーボードに7nm製造プロセス ZEN3アーキテクチャーを採用したAMD Ryzen プロセッサーを搭載しています。最大8個のZen3コア、最大16MBのL3キャッシュ、DDR4-3200メモリに対応し、Radeonグラフィックによるパワフルなオンボードグラフィック機能を内蔵しています。CPUクーラーには世界屈指の空冷メーカー Noctua製「NH-U12S redux」を採用しており、メインストリーム系ながらハイエンドに迫る性能を発揮します。用途に応じ、内蔵グラフィックを使用したエントリーモデルからNVIDIA RTXシリーズを搭載したグラフィックWSモデルまで選択いただけるコストパフォーマンスに優れたモデルです。

AMD新APU Ryzen 5000Gシリーズ を採用

最大8コアを搭載したAMD Ryzen™ 5000シリーズ・デスクトップ・プロセッサーを利用することで、データの処理やコンテンツ制作を容易に遂行できるようになります。電力効率が高く、低発熱かつ静音な最先端の7nmテクノロジーで構築されたこのプロセッサーは、ミニ、スモール・フォームファクター、タワーなど、あらゆるサイズのデスクトップPCでハイパフォーマンスを実現します。

世界屈指の空冷最強メーカー Noctua製 「NH-U12S redux」を選択可能

メインストリーム系ながらハイエンドに迫る性能を発揮。ナローヒートシンクデザインを使用した、12cmファン搭載サイドフロー型のCPUクーラーです。

高品質な部品を採用し、安定性を重視したプロフェッショナルユーザー向けマザーボード

AMD B550チップセットマザーボードを採用。大型PWMヒートシンクと7W/mKのサーマルパッドがCPU温度を低く保ち、CPUの性能を高負荷時でも最大限に発揮します。ヘビーユーザーの要望に応える高い拡張性を備え、低遅延で高速なLANを搭載し、最新のストレージデバイスに対応しています。

UNI-R5B はAMD B550 チップセットマザーボードに7nm製造プロセス ZEN3アーキテクチャーを採用したAMD Ryzen プロセッサーを搭載しています。最大8個のZen3コア、最大16MBのL3キャッシュ、DDR4-3200メモリに対応し、Radeonグラフィックによるパワフルなオンボードグラフィック機能を内蔵しています。CPUクーラーには世界屈指の空冷メーカー Noctua製「NH-U12S redux」を採用しており、メインストリーム系ながらハイエンドに迫る性能を発揮します。用途に応じ、内蔵グラフィックを使用したエントリーモデルからNVIDIA RTXシリーズを搭載したグラフィックWSモデルまで選択いただけるコストパフォーマンスに優れたモデルです。

AMD新APU Ryzen 5000Gシリーズ を採用

最大8コアを搭載したAMD Ryzen™ 5000シリーズ・デスクトップ・プロセッサーを利用することで、データの処理やコンテンツ制作を容易に遂行できるようになります。電力効率が高く、低発熱かつ静音な最先端の7nmテクノロジーで構築されたこのプロセッサーは、ミニ、スモール・フォームファクター、タワーなど、あらゆるサイズのデスクトップPCでハイパフォーマンスを実現します。

世界屈指の空冷最強メーカー Noctua製 「NH-U12S redux」を選択可能

メインストリーム系ながらハイエンドに迫る性能を発揮。ナローヒートシンクデザインを使用した、12cmファン搭載サイドフロー型のCPUクーラーです。

高品質な部品を採用し、安定性を重視したプロフェッショナルユーザー向けマザーボード

AMD B550チップセットマザーボードを採用。大型PWMヒートシンクと7W/mKのサーマルパッドがCPU温度を低く保ち、CPUの性能を高負荷時でも最大限に発揮します。ヘビーユーザーの要望に応える高い拡張性を備え、低遅延で高速なLANを搭載し、最新のストレージデバイスに対応しています。

UNI-R7X は、最新の AMD X870 チップセットマザーボード に、5nm 製造プロセスを採用した Zen 4 アーキテクチャ 第5世代 AMD Ryzen™ プロセッサー を搭載したモデルです。最大16コアの Zen 4 コア、最大 64MB の L3 キャッシュ、DDR5 メモリ対応により、高い処理能力と高速応答性を実現しています。高クロックの P-core 系 Zen 4 コアは、スレッド数の少ない 3D 設計や軽量レンダリングタスクに優れているだけでなく、最大16コア構成により、マルチスレッド・レンダリングやリアリティキャプチャなどの重い処理にも柔軟に対応できるバランスの取れた性能を発揮します。さらに、統合 RDNA2 グラフィックス を備え、AVX-512 命令セット、PCIe 5.0 をサポート。X870 チップセット経由では USB4(最大40Gbps) をはじめとする次世代 I/O に対応し、高速なデータ転送や外部デバイスとの高い互換性を提供します。すべてをこなすデスクトップ・プロセッサーとして、卓越したシングルスレッドおよびマルチスレッド性能を両立し、クリエイティブ制作から高度な演算処理まで、幅広いワークフローで最大限のパフォーマンスを発揮します。次世代のデスクトップ PC がもたらすパワーを、ぜひご体感ください。

第5世代(ZEN 4)AMD Ryzen プロセッサー搭載を搭載

最大16コア32スレッドのZen4コア、最大5.7GHzのブーストクロック、最大80MBキャッシュを備えたAMD Ryzen 7000 シリーズ・プロセッサーは先を行く性能を発揮します。時間を節約できる演算能力で、クリエイターの創作活動を支援します。タスクの種類を問わず、PCIe 5.0のスピードとストレージを備え、最大32個のプロセッシング・スレッドと専用のビデオ・アクセラレーターを搭載したこのプロセッサーがあれば、より高速に作業を遂行することができます。

次世代ワークステーションを支える AMD X870 マザーボード

UNI-R7Xの マザーボードは最新の AMD X870 チップセットを採用し、科学計算やシミュレーション用途で求められる高い計算負荷にも耐えるワークステーション基盤を提供します。 PCIe Gen5、DDR5高速メモリ、USB4などの先進的なインターフェースにより、大容量データの高速処理や、GPUアクセラレーションを活用した数値解析・物理シミュレーションを強力にサポートします。 さらに、業界初のクイックリリース式M.2ヒートシンクと大型アルミ合金ヒートシンクを備え、長時間連続稼働が必要なモデリング作業や計算ジョブでも安定したスループットを維持。 インテリジェント冷却設計により、熱負荷の高いストレージや拡張カード使用時でも信頼性の高い運用が可能です。 高帯域ネットワーク(Wi-Fi 7 / 2.5GbE)と堅牢な電源設計を組み合わせ、研究開発・工学分野のワークステーションに求められる安定性・拡張性を両立しています。

最大128GBまで搭載可能な広帯域4800MHz DDR5メモリー

メモリはDDR-5規格広帯域 4800MHzモジュールをDual-Cannelで実装、合計4つのメモリスロットを確保しております。マザーボード上には強化DIMMスロッが表面実装されており、より優れた物理的強度とより安定したメモリ信号を実現します。

PCI-Express 5.0 に対応

最新のPCI Express 5.0規格に対応し、前世代の2倍となる128 Gb/秒の転送速度に対応します。この驚異的な帯域幅により、将来の超高速SSDの性能を最大限に引き出すことができます。

最大5基のストレージベイを搭載

HDD ケージシステムには 3.5 インチまたは 2.5 インチドライブを最大 5台まで設置可能、従来よりも更に優れた拡張性を実現。ユーザー個人の好みに応じてケースレイアウトを変更可能です。

UNI-R7X はAMD X670E チップセットマザーボードに5nm製造プロセス ZEN4アーキテクチャーを採用した第5世代(ZEN 4)AMD Ryzen プロセッサーを搭載しています。最大16個のZen4コア、最大64MBのL3キャッシュ、DDR5-4800メモリ対応、統合RDNA2グラフィックス、AVX512インストラクションサポート、高性能105W+および65Wソリューションをターゲット、PCIe5.0対応、チップセット経由で最大20GbpsのUSBType-Cに対応、等々。デスクトップPCを次世代に導く性能をご体感ください。

第5世代(ZEN 4)AMD Ryzen プロセッサー搭載を搭載

最大16コア32スレッドのZen4コア、最大5.7GHzのブーストクロック、最大80MBキャッシュを備えたAMD Ryzen 7000 シリーズ・プロセッサーは先を行く性能を発揮します。時間を節約できる演算能力で、クリエイターの創作活動を支援します。タスクの種類を問わず、PCIe 5.0のスピードとストレージを備え、最大32個のプロセッシング・スレッドと専用のビデオ・アクセラレーターを搭載したこのプロセッサーがあれば、より高速に作業を遂行することができます。

堅牢なコンポーネントを装備し、安定性を重視したマザーボード

AMD X670Eチップセットマザーボードを採用。それぞれのフェーズの電流と温度の監視向けに最適化されているので、RyzenCPU に円滑かつ安定した電源を供給し、性能を向上させて、低温と優れたエネルギー効率をお届けします。

最大128GBまで搭載可能な広帯域4800MHz DDR5メモリー

メモリはDDR-5規格広帯域 4800MHzモジュールをDual-Cannelで実装、合計4つのメモリスロットを確保しております。マザーボード上には強化DIMMスロッが表面実装されており、より優れた物理的強度とより安定したメモリ信号を実現します。

PCI-Express 5.0 に対応

最新のPCI Express 5.0規格に対応し、前世代の2倍となる128 Gb/秒の転送速度に対応します。この驚異的な帯域幅により、将来の超高速SSDの性能を最大限に引き出すことができます。

最大5基のストレージベイを搭載

HDD ケージシステムには 3.5 インチまたは 2.5 インチドライブを最大 5台まで設置可能、従来よりも更に優れた拡張性を実現。ユーザー個人の好みに応じてケースレイアウトを変更可能です。

UNI-R7X はAMD X670E チップセットマザーボードに5nm製造プロセス ZEN4アーキテクチャーを採用した第5世代(ZEN 4)AMD Ryzen プロセッサーを搭載しています。最大16個のZen4コア、最大64MBのL3キャッシュ、DDR5-4800メモリ対応、統合RDNA2グラフィックス、AVX512インストラクションサポート、高性能105W+および65Wソリューションをターゲット、PCIe5.0対応、チップセット経由で最大20GbpsのUSBType-Cに対応、等々。デスクトップPCを次世代に導く性能をご体感ください。

第5世代(ZEN 4)AMD Ryzen プロセッサー搭載を搭載

最大16コア32スレッドのZen4コア、最大5.7GHzのブーストクロック、最大80MBキャッシュを備えたAMD Ryzen 7000 シリーズ・プロセッサーは先を行く性能を発揮します。時間を節約できる演算能力で、クリエイターの創作活動を支援します。タスクの種類を問わず、PCIe 5.0のスピードとストレージを備え、最大32個のプロセッシング・スレッドと専用のビデオ・アクセラレーターを搭載したこのプロセッサーがあれば、より高速に作業を遂行することができます。

堅牢なコンポーネントを装備し、安定性を重視したマザーボード

AMD X670Eチップセットマザーボードを採用。それぞれのフェーズの電流と温度の監視向けに最適化されているので、RyzenCPU に円滑かつ安定した電源を供給し、性能を向上させて、低温と優れたエネルギー効率をお届けします。

最大128GBまで搭載可能な広帯域4800MHz DDR5メモリー

メモリはDDR-5規格広帯域 4800MHzモジュールをDual-Cannelで実装、合計4つのメモリスロットを確保しております。マザーボード上には強化DIMMスロッが表面実装されており、より優れた物理的強度とより安定したメモリ信号を実現します。

PCI-Express 5.0 に対応

最新のPCI Express 5.0規格に対応し、前世代の2倍となる128 Gb/秒の転送速度に対応します。この驚異的な帯域幅により、将来の超高速SSDの性能を最大限に引き出すことができます。

最大5基のストレージベイを搭載

HDD ケージシステムには 3.5 インチまたは 2.5 インチドライブを最大 5台まで設置可能、従来よりも更に優れた拡張性を実現。ユーザー個人の好みに応じてケースレイアウトを変更可能です。

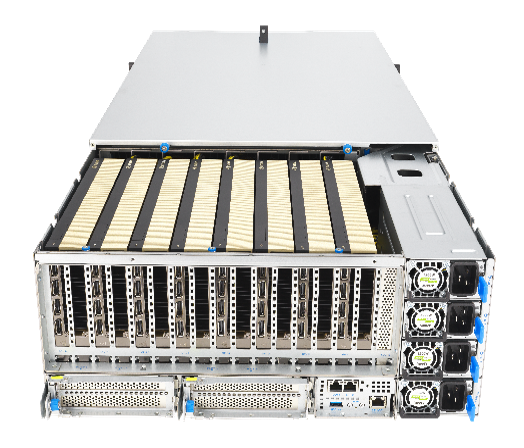

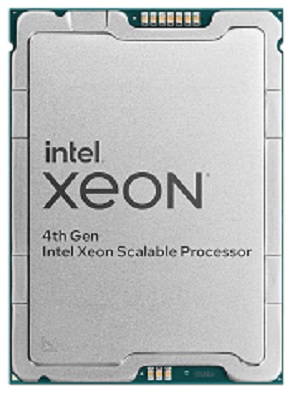

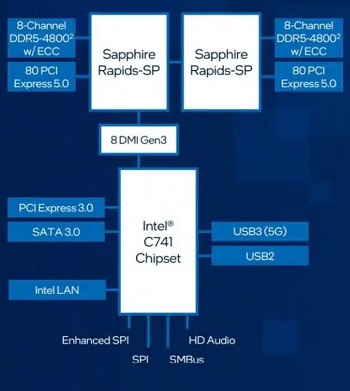

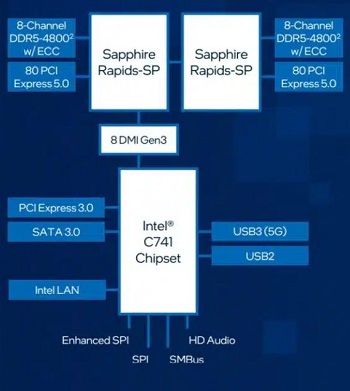

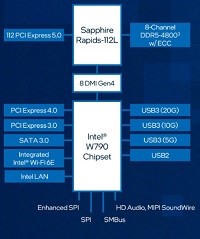

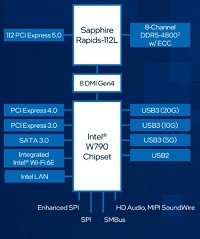

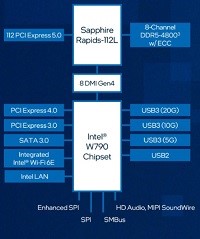

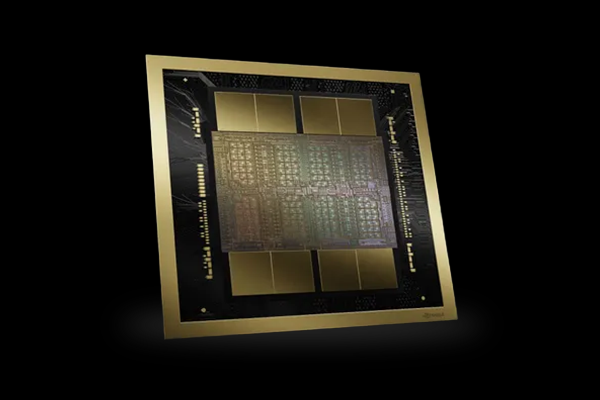

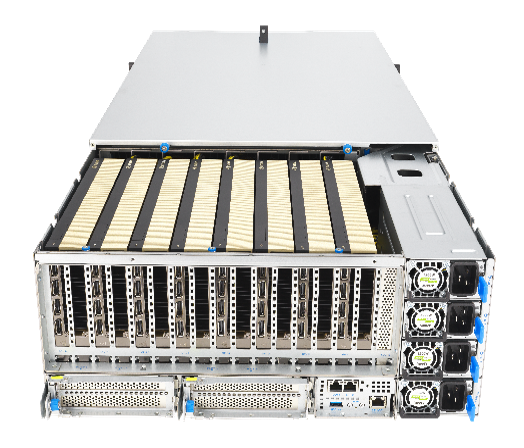

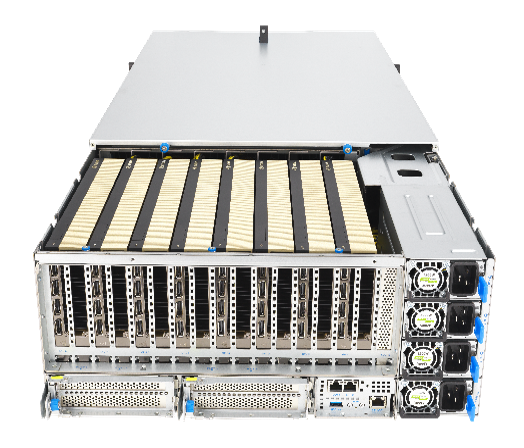

DeepLearning BOXⅢはNVIDIA Blackwell アーキテクチャーGPUであるRTX PRO 6000 Blackwellシリーズを最大3基搭載可能なGPUディープラーニングワークステーションです。CPUにはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3500シリーズを採用し、シングルソケットで最大 60 個のメニーコア環境を実現。インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。GPUカードはRTX PRO 6000 Blackwellシリーズに対応しており、LLMなどの複雑で大規模なAI学習でもご利用いただけるワークステーションです。さらに100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にし、サーバールームなど特別な電源環境を備えていない居室でもハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。

カスタマイズメニューに無い構成はお気軽に弊社までお問い合わせ下さい。お客様のご要望に合わせて抜群のコストパフォーマンスと安定した利用環境をご提供します。

NVIDIA RTX PRO 6000 Blackwell シリーズ製品比較レポート

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また。最新のDeeplearningBOXIIIは液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

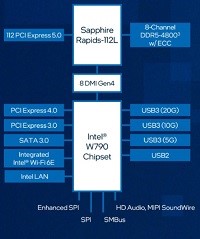

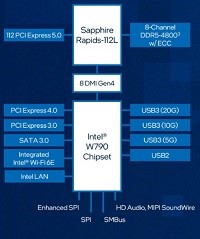

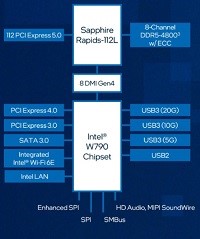

強化されたプラットフォーム

最新のDeeplearning BOXは、インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し、生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

ウルトラハイエンドGPUカードを 最大3枚搭載可能

コアパーツであるGPUは、最大3枚フル帯域で搭載が可能。PCI Expressの最新世代のPCI Express 5.0レーンに対応。

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。

Ubuntu 22.04に対応する「G-Works4.0」を選択されたい場合は こちら からご覧ください。

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。 システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。 【動作条件】 ・システムディスク以外にデータディスクが一つ以上装備されている必要があります。 ・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。 ・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。 ・バックアップデータは日付別に分類されて保存されます。

DeepLearning BOXIII はインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3400シリーズを搭載した GPUディープラーニングワークステーションです。「G-Works 4.0」をインストール

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また。最新のDeeplearningBOXIIIは液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

強化されたプラットフォーム

最新のDeeplearning BOXは、インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し、生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

ウルトラハイエンドGPUカードを 最大4枚を搭載可能

コアパーツであるGPUは、最大4枚フル帯域で搭載が可能。PCI Expressの最新世代のPCI Express 5.0レーンに対応。

バージョンアップされたDeepLearning開発環境「G-Works4.0」

新しいG-Works 4.0はWandBによる課題の可視化に加えて、Ubuntu 22.04 LTSに対応し、業界標準となっている仮想環境Dockerに加え、AI/HPCアプリケーションに適したSingularity、およびワークロードマネジメント用にSlurmをインストールしました。また、NVIDIA社が提供するNVIDIA GPU Cloud (NGC)の内容を検索できるngcスクリプトも配置してありますので、コマンドラインから、利用可能なDocker Imageを簡単に探し出すことができ利便性を高めています。

G-Worksの詳細はこちら からご覧ください。

DeepLearning BOXIII はインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3400シリーズを搭載した GPUディープラーニングワークステーションです。LLM などの複雑で大規模なAI学習でも利用できる、最新のAdaLovelaceアーキテクチャGPUであるRTX Adaシリーズを搭載したモデルをご用意。100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でのハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。「G-Works 4.0」をインストール

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また。最新のDeeplearningBOXIIIは液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

強化されたプラットフォーム

最新のDeeplearning BOXは、インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し、生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

ウルトラハイエンドGPUカードを 最大4枚を搭載可能

コアパーツであるGPUは、最大4枚フル帯域で搭載が可能。PCI Expressの最新世代のPCI Express 5.0レーンに対応。

バージョンアップされたDeepLearning開発環境「G-Works4.0」

新しいG-Works 4.0はWandBによる課題の可視化に加えて、Ubuntu 22.04 LTSに対応し、業界標準となっている仮想環境Dockerに加え、AI/HPCアプリケーションに適したSingularity、およびワークロードマネジメント用にSlurmをインストールしました。また、NVIDIA社が提供するNVIDIA GPU Cloud (NGC)の内容を検索できるngcスクリプトも配置してありますので、コマンドラインから、利用可能なDocker Imageを簡単に探し出すことができ利便性を高めています。

G-Worksの詳細はこちら からご覧ください。

GWS-ISAGA-2Gはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) Wシリーズを搭載したデスクサイドGPUワークステーションです。Xeon Wの採用によりシングルソケットでメニーコア環境を実現。インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、PCI Express 5.0 を備え、理論値32GT/sの広帯域なインターフェースで Microsoft DirectStorageなどのデータ転送技術とNVIDIA Blackwell アーキテクチャーのハイエンドGPUを最大2基まで最適に動作させることが可能です。さらに最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。GPUカードはNVIDIA Blackwell アーキテクチャーに対応。ストレージには高速なM.2NVMe1台と4台の3.5インチHDDが搭載可能です。GPU演算に加えて、高速演算やシミュレーション、グラフィック作業などCPUパワーを必要とする作業に満足のいくパフォーマンスを提供できるモデルです。

カスタマイズメニューに無い構成はお気軽に弊社までお問い合わせ下さい。お客様のご要望に合わせて抜群のコストパフォーマンスと安定した利用環境をご提供します。

NVIDIA RTX PRO 6000 Blackwell シリーズ製品比較レポート

NVIDIA Blackwell アーキテクチャーGPUカードが搭載可能

NVIDIA Blackwell アーキテクチャは、AI、レイトレーシング、ニューラルグラフィックス技術を組み合わせており、パフォーマンスとメモリの大幅な向上を実現します。これにより、先進的なクリエイティブ、設計、エンジニアリングワークフローを推進します。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)はさまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また、最新のGSW-W9/4G は液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

強化されたプラットフォーム

インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。 システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。 【動作条件】 ・システムディスク以外にデータディスクが一つ以上装備されている必要があります。 ・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。 ・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。 ・バックアップデータは日付別に分類されて保存されます。

GWS-ISAGA-2Gはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) Wシリーズを搭載したデスクサイドGPUワークステーションです。最新のXeon Wの採用によりシングルソケットでメニーコア環境を実現。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第 4 世代 Tensor コアにより、新しいFP8 Transformerエンジンを使用して驚異的に速い最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。これらプロフェッショナル グラフィックス、AI、コンピューティング性能を実現するために設計されております。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)はさまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また、最新のDeeplearningBOXIIIは液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

強化されたプラットフォーム

インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

GWS-ISAGA-2Gはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) Wシリーズを搭載したデスクサイドGPUワークステーションです。最新のXeon Wの採用によりシングルソケットでメニーコア環境を実現。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第 4 世代 Tensor コアにより、新しいFP8 Transformerエンジンを使用して驚異的に速い最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。これらプロフェッショナル グラフィックス、AI、コンピューティング性能を実現するために設計されております。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)はさまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また、最新のDeeplearningBOXIIIは液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

強化されたプラットフォーム

インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

ローカルRAGスターターBOXは、LLMアプリケーションの開発や高速化など数々のAI開発実績を誇る株式会社Ridge-iと共同開発したQ&Aサポートチケット付ワークステーションです。

セキュアなローカル環境

ローカルRAGスターターBOXは、クローズドな環境で機密性の高い自社データを活用したLLMの構築を行う開発者向けにソフトウェア環境構築済みのオンプレミスの開発向けモデルです。開発中のデータをローカル環境内に留め外部へ持ち出さないため、情報漏洩リスクを最小化します。そのため厳格なセキュリティポリシーが求められる業種でも機密性、正確性、リアルタイム性が担保された、より精度の高いLLMの構築を行うことが可能になります。

短期導入・即運用可能

ローカルRAGスターターBOXは、LLM/RAG開発に適したハードウェアシステム構成に加え、開発環境には Dify OpenWebUIと Ollama Xinference を実装したワークステーションです。 AIモデルには2025年1月7日に公開された最新のMicrosoft Phi-4、2024年公開のLlama 3.1など複数のモデルをプリインストールしています。そのため、届いたその日から最短時間で基本機能が稼働し、迅速に業務への導入が可能です。

安心のQ&Aチケット

初期セットアップ済みのLLM/RAG開発環境の操作方法について不明な点は、、LLMアプリケーションの開発や高速化など数々のAI開発実績を誇るRidge-i社のQ&Aチケットが付属したワークステーションとなり、Q&Aサポートを受けながらスムーズな導入が可能です。

抜群のコストパフォーマンス

ローカルRAGスターターBOXは、お客様のビジネスへのAI活用がスムーズにスタートできるよう、エントリー、スタンダード、ハイスペックの3タイプのモデルを展開したワークステーションです。ハードウェア構成として NVIDIA Ada Lovelaceアーキテクチャを採用したRTX Adaシリーズを搭載。最大48GB のGDDR6メモリと広帯域なNVLINKを組み合わせることにより高いAI学習性能及び推論性能を実現します。また、ソフトウェア環境構築は LLM/RAGの開発環境のプリインストールだけではなく、各モデルにQ&Aチケットが3回分付帯して1,998,000円(税別・送料別)から始められるお求めやすい価格でご用意しました。

他に類を見ない拡張性と柔軟性

ローカルRAGスターターBOXは、エントリー、スタンダード、ハイスペック、3タイプのモデルに対して、お客様のご予算に合わせてGPUカードの交換や増設などにご予算に合わせたカスタマイズが可能なワークステーションです。また導入後のGPUやストレージの追加なども柔軟に対応しますので、必要なタイミングでマシンパフォーマンスの向上が可能となります。また、ハードのみならず、PoC推進のためにAIのプロフェッショナルであるRidge-i社による本格的なコンサルテーションや開発をセット提供(別途有償)できるよう柔軟なオプションと提供形態をご用意しています。まずはお気軽にご相談下さい。

※PoCでの利用シーンを想定して1マシンを1ユーザ(1グループ)で占有してご利用いただく開発環境となります。

ローカルRAGスターターBOXは、LLMアプリケーションの開発や高速化など数々のAI開発実績を誇る株式会社Ridge-iと共同開発したQ&Aサポートチケット付ワークステーションです。

セキュアなローカル環境

ローカルRAGスターターBOXは、クローズドな環境で機密性の高い自社データを活用したLLMの構築を行う開発者向けにソフトウェア環境構築済みのオンプレミスの開発向けモデルです。開発中のデータをローカル環境内に留め外部へ持ち出さないため、情報漏洩リスクを最小化します。そのため厳格なセキュリティポリシーが求められる業種でも機密性、正確性、リアルタイム性が担保された、より精度の高いLLMの構築を行うことが可能になります。

短期導入・即運用可能

ローカルRAGスターターBOXは、LLM/RAG開発に適したハードウェアシステム構成に加え、開発環境には Dify OpenWebUIと Ollama Xinference を実装したワークステーションです。 AIモデルには2025年1月7日に公開された最新のMicrosoft Phi-4、2024年公開のLlama 3.1など複数のモデルをプリインストールしています。そのため、届いたその日から最短時間で基本機能が稼働し、迅速に業務への導入が可能です。

安心のQ&Aチケット

初期セットアップ済みのLLM/RAG開発環境の操作方法について不明な点は、、LLMアプリケーションの開発や高速化など数々のAI開発実績を誇るRidge-i社のQ&Aチケットが付属したワークステーションとなり、Q&Aサポートを受けながらスムーズな導入が可能です。

抜群のコストパフォーマンス

ローカルRAGスターターBOXは、お客様のビジネスへのAI活用がスムーズにスタートできるよう、エントリー、スタンダード、ハイスペックの3タイプのモデルを展開したワークステーションです。ハードウェア構成として NVIDIA Ada Lovelaceアーキテクチャを採用したRTX Adaシリーズを搭載。最大48GB のGDDR6メモリと広帯域なNVLINKを組み合わせることにより高いAI学習性能及び推論性能を実現します。また、ソフトウェア環境構築は LLM/RAGの開発環境のプリインストールだけではなく、各モデルにQ&Aチケットが3回分付帯して1,998,000円(税別・送料別)から始められるお求めやすい価格でご用意しました。

他に類を見ない拡張性と柔軟性

ローカルRAGスターターBOXは、エントリー、スタンダード、ハイスペック、3タイプのモデルに対して、お客様のご予算に合わせてGPUカードの交換や増設などにご予算に合わせたカスタマイズが可能なワークステーションです。また導入後のGPUやストレージの追加なども柔軟に対応しますので、必要なタイミングでマシンパフォーマンスの向上が可能となります。また、ハードのみならず、PoC推進のためにAIのプロフェッショナルであるRidge-i社による本格的なコンサルテーションや開発をセット提供(別途有償)できるよう柔軟なオプションと提供形態をご用意しています。まずはお気軽にご相談下さい。

※PoCでの利用シーンを想定して1マシンを1ユーザ(1グループ)で占有してご利用いただく開発環境となります。

ローカルRAGスターターBOXは、LLMアプリケーションの開発や高速化など数々のAI開発実績を誇る株式会社Ridge-iと共同開発したQ&Aサポートチケット付ワークステーションです。

セキュアなローカル環境

ローカルRAGスターターBOXは、クローズドな環境で機密性の高い自社データを活用したLLMの構築を行う開発者向けにソフトウェア環境構築済みのオンプレミスの開発向けモデルです。開発中のデータをローカル環境内に留め外部へ持ち出さないため、情報漏洩リスクを最小化します。そのため厳格なセキュリティポリシーが求められる業種でも機密性、正確性、リアルタイム性が担保された、より精度の高いLLMの構築を行うことが可能になります。

短期導入・即運用可能

ローカルRAGスターターBOXは、LLM/RAG開発に適したハードウェアシステム構成に加え、開発環境には Dify OpenWebUIと Ollama Xinference を実装したワークステーションです。 AIモデルには2025年1月7日に公開された最新のMicrosoft Phi-4、2024年公開のLlama 3.1など複数のモデルをプリインストールしています。そのため、届いたその日から最短時間で基本機能が稼働し、迅速に業務への導入が可能です。

安心のQ&Aチケット

初期セットアップ済みのLLM/RAG開発環境の操作方法について不明な点は、、LLMアプリケーションの開発や高速化など数々のAI開発実績を誇るRidge-i社のQ&Aチケットが付属したワークステーションとなり、Q&Aサポートを受けながらスムーズな導入が可能です。

抜群のコストパフォーマンス

ローカルRAGスターターBOXは、お客様のビジネスへのAI活用がスムーズにスタートできるよう、エントリー、スタンダード、ハイスペックの3タイプのモデルを展開したワークステーションです。ハードウェア構成として NVIDIA Ada Lovelaceアーキテクチャを採用したRTX Adaシリーズを搭載。最大48GB のGDDR6メモリと広帯域なNVLINKを組み合わせることにより高いAI学習性能及び推論性能を実現します。また、ソフトウェア環境構築は LLM/RAGの開発環境のプリインストールだけではなく、各モデルにQ&Aチケットが3回分付帯して1,998,000円(税別・送料別)から始められるお求めやすい価格でご用意しました。

他に類を見ない拡張性と柔軟性

ローカルRAGスターターBOXは、エントリー、スタンダード、ハイスペック、3タイプのモデルに対して、お客様のご予算に合わせてGPUカードの交換や増設などにご予算に合わせたカスタマイズが可能なワークステーションです。また導入後のGPUやストレージの追加なども柔軟に対応しますので、必要なタイミングでマシンパフォーマンスの向上が可能となります。また、ハードのみならず、PoC推進のためにAIのプロフェッショナルであるRidge-i社による本格的なコンサルテーションや開発をセット提供(別途有償)できるよう柔軟なオプションと提供形態をご用意しています。まずはお気軽にご相談下さい。

※PoCでの利用シーンを想定して1マシンを1ユーザ(1グループ)で占有してご利用いただく開発環境となります。

DeepLearningSTATION II は、当社独自のケース設計によりNVIDIA Blackwell アーキテクチャーGPUであるRTX PRO 6000 Blackwellシリーズを最大4基搭載可能なAIワークステーションです。CPUにはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3500シリーズを採用し、シングルソケットで最大 60 個のメニーコア環境を実現。インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。ストレージにはフロントアクセスが可能な2台の3.5インチHDDベイと、2.5インチSSDが最大4台内蔵でき、高い拡張性を実現します。GPUカードはNVIDIA Blackwell アーキテクチャーGPUであるRTX PRO 6000 Blackwellシリーズに対応しており、LLMなどの複雑で大規模なAI学習でもご利用いただけるワークステーションです。さらに100V-15A入力の高性能電源を2基搭載したDual PSU構成によりトータル2000W以上の電源供給を可能にし、サーバールームなど特別な電源環境を備えていない居室でもハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。加えてオプションのラックマウントレールを装着することにより、デスクサイド利用のみならず19インチラックへの搭載も可能となっています。※本製品は Windows 版もご用意しております。ご希望の際は、お気軽にお問い合わせください。 NVIDIA RTX PRO 6000 Blackwell シリーズ製品比較レポート

▼ より詳しい情報は以下の特設ページでご案内しております。https://www.gdep.co.jp/lp-deeplearningstation2/

VIDEO

独自設計 4GPU ワークステーションケース

DeepLearning STATION IIは、NVIDIAエリートパートナーであるジーデップ・アドバンスの独自設計により最大4枚のハイエンドGPUを搭載可能なAIワークステーションです。

フロントアクセス可能なストレージベイ

フロントアクセス可能な2基の3.5インチ 大容量HDDスワップベイを装備しオプションで冗長化にも対応しています。内蔵ベイには2.5インチの高速SSDを最大で4基搭載可能でシステムとデータエリアを分けた運用が可能です。

デュアルパワーサプライユニット搭載

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

ラックマウントにも対応

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。

Ubuntu 22.04に対応する「G-Works4.0」を選択されたい場合はこちら からご覧ください。

DeepLearning STATIONIIは、当社独自のケース設計により最大4枚のGPUを搭載可能なAIワークステーションです。「G-Works 4.0」をインストール

独自設計 4GPU ワークステーションケース

DeepLearning STATION IIは、NVIDIAエリートパートナーであるジーデップ・アドバンスの独自設計により最大4枚のハイエンドGPUを搭載可能なAIワークステーションです。

フロントアクセス可能なストレージベイ

フロントアクセス可能な2基の3.5インチ 大容量HDDスワップベイを装備しオプションで冗長化にも対応しています。内蔵ベイには2.5インチの高速SSDを最大で4基搭載可能でシステムとデータエリアを分けた運用が可能です。

デュアルパワーサプライユニット搭載

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

ラックマウントにも対応

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

当社独自のDeepLearning開発環境「G-Works4.0」をインストール

当社独自のDeepLearning開発環境である「G-Works 4.0」は、OSネーティブでディープラーニングフレームワークを利用できる環境に加えて、MLOpsプラットフォームであるWandBをプリインストールしており、実験結果のトラッキングや学習効率の可視化が可能です。

こちら からご覧ください。

DeepLearning STATIONIIは、当社独自のケース設計により最大4枚のGPUを搭載可能なAIワークステーションです。「G-Works 4.0」をインストール

独自設計 4GPU ワークステーションケース

DeepLearning STATION IIは、NVIDIAエリートパートナーであるジーデップ・アドバンスの独自設計により最大4枚のハイエンドGPUを搭載可能なAIワークステーションです。

フロントアクセス可能なストレージベイ

フロントアクセス可能な2基の3.5インチ 大容量HDDスワップベイを装備しオプションで冗長化にも対応しています。内蔵ベイには2.5インチの高速SSDを最大で4基搭載可能でシステムとデータエリアを分けた運用が可能です。

デュアルパワーサプライユニット搭載

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

ラックマウントにも対応

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

当社独自のDeepLearning開発環境「G-Works4.0」をインストール

当社独自のDeepLearning開発環境である「G-Works 4.0」は、OSネーティブでディープラーニングフレームワークを利用できる環境に加えて、MLOpsプラットフォームであるWandBをプリインストールしており、実験結果のトラッキングや学習効率の可視化が可能です。

こちら からご覧ください。

DeepLearning STATIONIIは、当社独自のケース設計により最大4枚のGPUを搭載可能なAIワークステーションです。「G-Works 4.0」をインストール

独自設計 4GPU ワークステーションケース

DeepLearning STATION IIは、NVIDIAエリートパートナーであるジーデップ・アドバンスの独自設計により最大4枚のハイエンドGPUを搭載可能なAIワークステーションです。

フロントアクセス可能なストレージベイ

フロントアクセス可能な2基の3.5インチ 大容量HDDスワップベイを装備しオプションで冗長化にも対応しています。内蔵ベイには2.5インチの高速SSDを最大で4基搭載可能でシステムとデータエリアを分けた運用が可能です。

デュアルパワーサプライユニット搭載

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

ラックマウントにも対応

オプションの 19インチラック マウントキットを装着することで6.5Uサイズで19インチラックへの搭載が可能です。

当社独自のDeepLearning開発環境「G-Works4.0」をインストール

当社独自のDeepLearning開発環境である「G-Works 4.0」は、OSネーティブでディープラーニングフレームワークを利用できる環境に加えて、MLOpsプラットフォームであるWandBをプリインストールしており、実験結果のトラッキングや学習効率の可視化が可能です。

こちら からご覧ください。

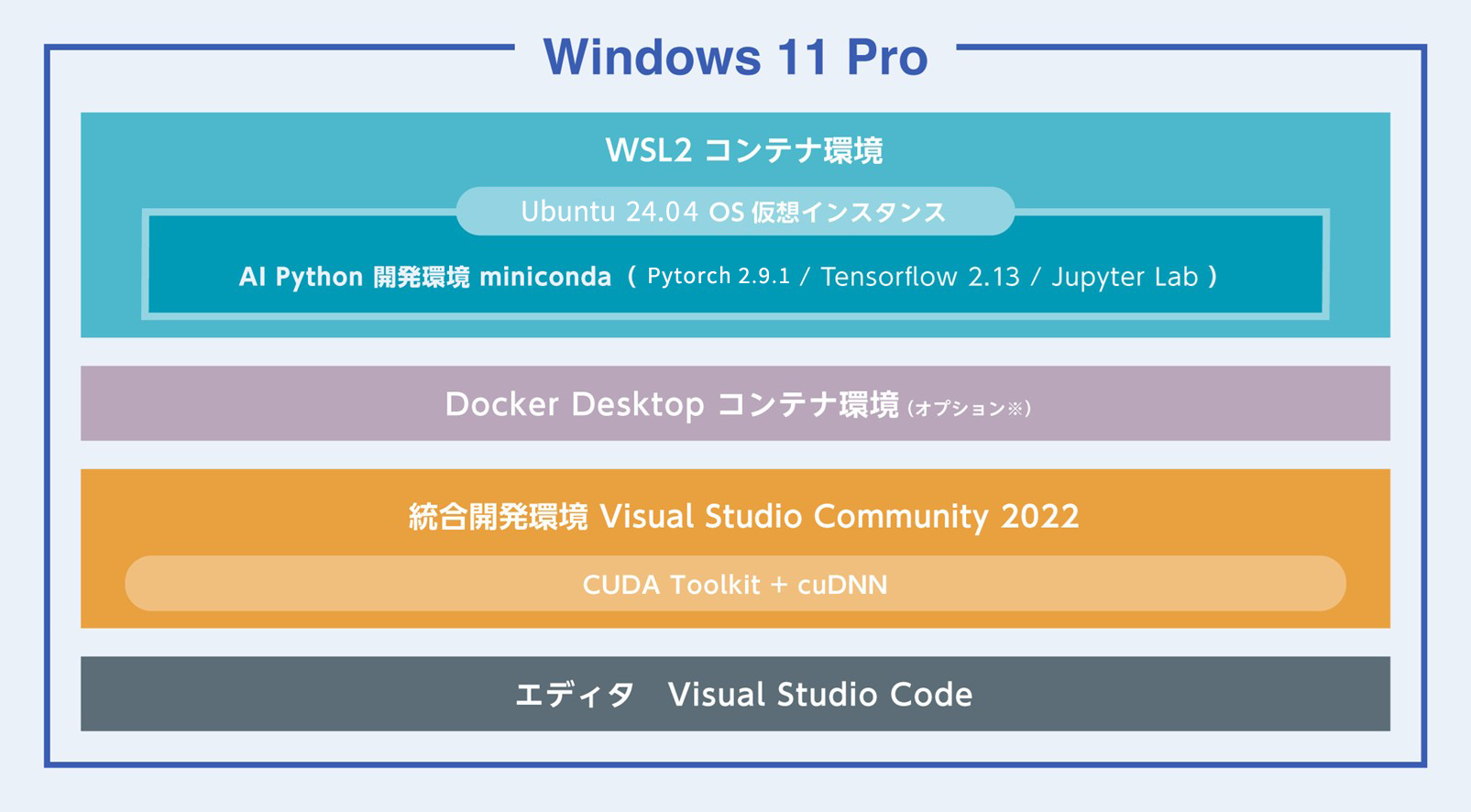

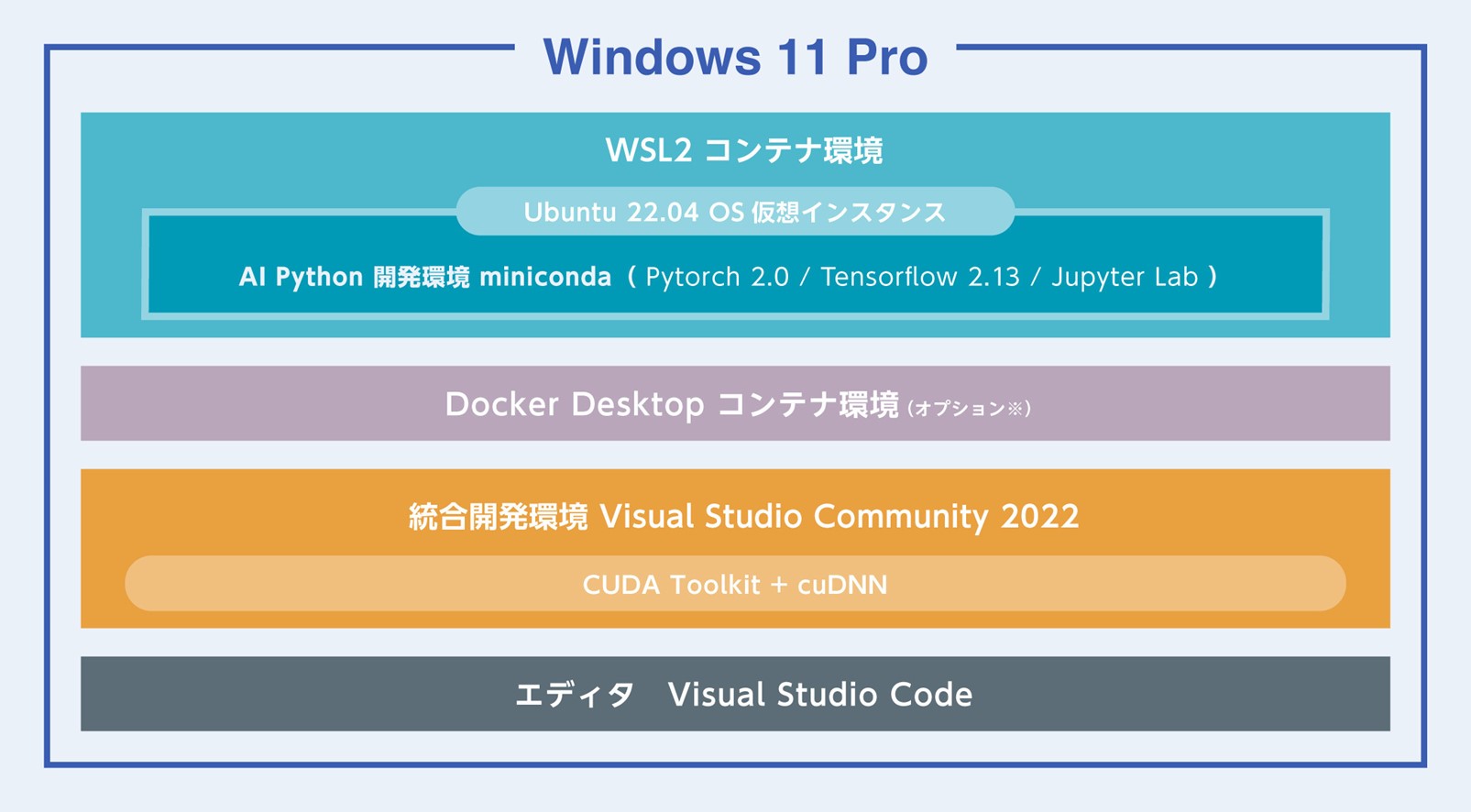

DeepLearingBOXⅢ/WinはNVIDIA Blackwell アーキテクチャーGPUであるRTX PRO 6000 Blackwellシリーズを最大3基搭載可能なGPUディープラーニングワークステーションです。CPUにはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3500シリーズを採用し、シングルソケットで最大 60 個のメニーコア環境を実現。インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。また、最大 112 レーンの PCI Express 5.0 を備え、最大 224GT/ 秒の広帯域でGPU間を接続することで計算のボトルネックを大きく解消することが期待できます。GPUカードはNVIDIA Blackwell アーキテクチャーGPUであるRTX PRO 6000 Blackwellシリーズに対応しており、LLMなどの複雑で大規模なAI学習でもご利用いただけるワークステーションです。さらに100V-15A入力の高性能電源を2基搭載したDual PSU構成でトータル2000W以上の電源供給を可能にしており、サーバールームなど特別な電源環境を備えていない居室でもハイエンドマルチGPUが利用可能なハードウェアスペックを誇ります。NVIDIA RTX PRO 6000 Blackwell シリーズ製品比較レポート Windows11 WSL2セッティング済み

WSL2において以下のコンテナ環境でAI開発環境が提供されます。

製品初期設定時にはインターネット接続が必要です。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また。最新のDeeplearningBOXIIIは液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

強化されたプラットフォーム

最新のDeeplearning BOXは、インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し、生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

ウルトラハイエンドGPUカードを 最大3基搭載可能

コアパーツであるGPUは、最大3基フル帯域で搭載が可能。PCI Expressの最新世代のPCI Express 5.0レーンに対応しており、搭載可能なGPUはNVIDIA Blackwell アーキテクチャーGPU を最大3基搭載可能です。NVLinkにも対応し、2基1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。また、標準でCEM5に対応ケーブルを標準採用しており、最新世代のGPU搭載もサポートしております。

WSL2セッティング済みAI学習フレームワーク搭載

Windows 11 ProをOSに採用した本システムはLinux OS仮想環境を共存させ、Linuxのネイティブアプリケーションを実行可能とするWindows Subsystem for Linux Version 2 (WSL2) を利用しています。多くのAIアプリケーションがLinux上で開発されている中、それらのAIアプリケーションとWindowsデスクトップ環境の統合が容易になります。システム仕様に最適なDeep Learning環境をWindows上で容易に構築できるこの仕組みはユーザーのAI開発環境構築の負担を大幅に削減し、ファイルシステムへのアクセスも、Windows – Linuxの双方向でほぼシームレスに扱うことが可能でます。ユーザーがAI開発において面倒で複雑な開発環境設定を行うことなく、届いたその日からご利用いただけます。

DeepLearning BOXIIIはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3400シリーズを搭載した GPUディープラーニングワークステーションです。Windows11 WSL2セッティング済み

WSL2において以下のコンテナ環境でAI開発環境が提供されます。

製品初期設定時にはインターネット接続が必要です。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)は、さまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。また。最新のDeeplearningBOXIIIは液体冷却ユニットにより冷却が行われていることで、安全で静音な環境で利用することができます。

強化されたプラットフォーム

最新のDeeplearning BOXは、インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し、生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

ウルトラハイエンドGPUカードを 最大3基搭載可能

コアパーツであるGPUは、最大3基フル帯域で搭載が可能。PCI Expressの最新世代のPCI Express 5.0レーンに対応しており、搭載可能なGPUはNVIDIA Blackwell アーキテクチャーGPU を最大3基搭載可能です。NVLinkにも対応し、2基1組でNVLinkブリッジを介して最大112GB/Secという広帯域でGPU間の高速なデータの転送を実現します。また、標準でCEM5に対応ケーブルを標準採用しており、最新世代のGPU搭載もサポートしております。

WSL2セッティング済みAI学習フレームワーク搭載

Windows 11 ProをOSに採用した本システムはLinux OS仮想環境を共存させ、Linuxのネイティブアプリケーションを実行可能とするWindows Subsystem for Linux Version 2 (WSL2) を利用しています。多くのAIアプリケーションがLinux上で開発されている中、それらのAIアプリケーションとWindowsデスクトップ環境の統合が容易になります。システム仕様に最適なDeep Learning環境をWindows上で容易に構築できるこの仕組みはユーザーのAI開発環境構築の負担を大幅に削減し、ファイルシステムへのアクセスも、Windows – Linuxの双方向でほぼシームレスに扱うことが可能でます。ユーザーがAI開発において面倒で複雑な開発環境設定を行うことなく、届いたその日からご利用いただけます。

DeepLearning BOXIIIはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) W3400シリーズを搭載した GPUディープラーニングワークステーションです。Windows11 WSL2セッティング済み

WSL2において以下のコンテナ環境でAI開発環境が提供されます。

製品初期設定時にはインターネット接続が必要です。

GWS-ISASM-2Gはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) Wシリーズを搭載したデスクサイドGPUワークステーションです。最新のXeon Wの採用によりシングルソケットでメニーコア環境を実現。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第 4 世代 Tensor コアにより、新しいFP8 Transformerエンジンを使用して驚異的に速い最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。これらプロフェッショナル グラフィックス、AI、コンピューティング性能を実現するために設計されております。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)はさまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。

強化されたプラットフォーム

インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

GWS-ISASM-2Gはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) Wシリーズを搭載したデスクサイドGPUワークステーションです。最新のXeon Wの採用によりシングルソケットでメニーコア環境を実現。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第 4 世代 Tensor コアにより、新しいFP8 Transformerエンジンを使用して驚異的に速い最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。これらプロフェッショナル グラフィックス、AI、コンピューティング性能を実現するために設計されております。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)はさまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。

強化されたプラットフォーム

インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

GWS-ISASM-2Gはインテル® Xeon® W プロセッサー(開発コード:Sapphire Rapids) Wシリーズを搭載したデスクサイドGPUワークステーションです。最新のXeon Wの採用によりシングルソケットでメニーコア環境を実現。インテル ターボ・ブースト・マックス・テクノロジー 3.0 は 最大 4.8GHz の CPUクロックによって軽度にスレッド化されたアプリケーションのコアパフォーマンスを最適化し、インテル スマートキャッシュはキャッシュとメモリー間のデータ交換の高速化によるレイテンシーを低減させます。

NVIDIA Ada Lovelace アーキテクチャ 世代 TDP 450W クラスGPUカードが搭載可能

第 4 世代 Tensor コアにより、新しいFP8 Transformerエンジンを使用して驚異的に速い最大 5 倍のスループットの向上と、1.4 Tensor-petaFLOPS の性能を実現します。Ada の第 3 世代 RT コアは、レイ-トライアングル交差のスループットが 2 倍になり、RT-TFLOP 性能が 2 倍以上向上します。これらプロフェッショナル グラフィックス、AI、コンピューティング性能を実現するために設計されております。

インテル Xeon W プロセッサー 搭載

最新の インテル® Xeon® W プロセッサー・ファミリー(開発コード Sapphire Rapids)はさまざまなクリエイターのために設計されています。インテル® Xeon® W-3400/2400 プロセッサー搭載のプラットフォームは、VFX、3D レンダリング、複雑な 3D CAD、および AI 開発とエッジ導入向けの拡張されたプラットフォーム機能とともに、卓越したパフォーマンス、セキュリティー、信頼性を提供し、プロフェッショナルなクリエイター向けに究極のワークステーション・ソリューションを実現します。

強化されたプラットフォーム

インテル W790 チップセットと組み合わせることで、プロフェッショナルな高速ネットワークカード、グラフィックス・アクセラレーター、大容量ストレージアレイといった拡張された周辺機器に加えて、ハイパフォーマンス・コンピューティングと信頼性を経験し生産性と構成の柔軟性を向上することが可能です。最大 112 レーン (W2400 は64レーン)の PCIe Gen 5.0 接続、最大 4TB の DDR5 RDIMM メモリーサポート、最大 5x USB 3.2 Gen 2x2 ポートなど、革新的なプラットフォーム機能により構成に柔軟性を持たせており、プロフェッショナルな複雑なコンピューティングの需要に応えることが簡単にできます。

安定度抜群の高効率電源

採用されている電源は高品質のDC-DCコンバータを使用した大容量高効率ユニットです。100V環境で1200W の容量を実現しワークステーション用途はもちろん、サーバーレベルの要求仕様も満たす品質と高いTDPを要求する演算用GPUカードも安定した性能を発揮出来る余裕のマージン設計です。

GSV-ATRSM-5U8Gは、最新のNVIDIA H200 NVL(141GB)やRTX PRO 6000 Blackwell Max-Qなど、先進的なGPUを最大8基まで搭載可能な5Uラックマウント型GPUサーバーです。生成AI、大規模HPC、VDI、3Dレンダリング、医用イメージングといった高負荷なワークロードに対応するために設計されており、あらゆる次世代計算ニーズに応えます。CPUには、AMDの次世代アーキテクチャ「EPYC 9005/9004シリーズ(Turin)」をデュアルソケットで搭載可能。最大192コア・500W TDPにより、圧倒的な並列処理能力と高効率な計算性能を発揮します。メモリは、DDR5 ECC RDIMM/MRDIMMを最大24スロット・6TBまでサポートし、最大6000MT/sの転送速度に対応。AIトレーニングや大規模シミュレーションに最適な高速・大容量メモリ構成が可能です。

拡張性にも優れ、PCIe 5.0 x16スロットを9基搭載。NVIDIA NVLink Bridge(オプション)によるGPU間の高速通信にも対応します。ストレージは、2.5インチNVMeホットスワップベイを4基、さらに1基のM.2 NVMeスロットを備え、リードライトの高速性と柔軟な構成を両立。OCP 3.0/AIOMスロットによるネットワーク機能の拡張性も確保しています。

冷却面では、高性能ファン合計10基により安定したエアフローを維持。電源には、96%以上の効率を誇るTitaniumレベルの2700W冗長電源を6基(4+2構成)を搭載し、常時高負荷が想定される環境でも高可用性を維持します。

※NVIDIA RTX PRO 6000 Blackwell Server Edition を8基搭載される場合は、動作温度環境を27度以下に設定いただく必要があります。詳しくは当社までお問い合わせください。 NVIDIA RTX PRO 6000 Blackwell シリーズ製品比較レポート

AMD 第5世代 AMD EPYC CPU 「Turin」 搭載

AMD EPYC™ Turinは、次世代のデータセンターおよびHPC向けに設計された第5世代EPYCプロセッサで、Zen 5アーキテクチャを採用しています。最大192コア/384スレッドという圧倒的な並列処理能力を備え、AI、HPC、仮想化、クラウド、データ分析などの高負荷ワークロードに最適です。最新のDDR5メモリとPCIe 5.0をサポートし、広帯域かつ低レイテンシのデータ転送を実現。優れた電力効率とセキュリティ機能を兼ね備え、次世代インフラの中核を担う高性能CPUです。

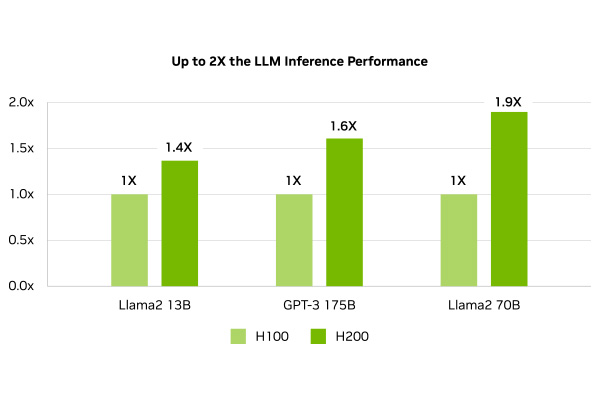

最新の NVIDIA Blackwell世代GPUや、Hopper世代 GPU H200 を最大8枚搭載可能

GSV-ATRSM-5U8Gは、NVIDIAの最新GPUであるRTX 6000 Blackwell Max-Q(Blackwellアーキテクチャ)をはじめ、Hopper世代のH200、Ada世代のRTX 6000 Adaなどに対応した高性能GPUサーバーです。AI推論や生成AI、HPC、3Dレンダリングといった多様なワークロードに最適な性能を提供します。特にBlackwell Max-QはFP8演算や高度なTransformer処理を省電力で実現し、高効率かつ高密度なAI環境を構築可能。第6世代Intel® Xeon® Scalableプロセッサー(Granite Rapids)との組み合わせにより、柔軟かつ拡張性の高いシステム構成が可能です。

エンタープライズ NVMe SSD

GSVシリーズに搭載されているNVMe SSDはビジネスインテリジェンス(BI)、オンライントランザクション処理(OLTP)、ソフトウェア・デファインド・ストレージ(SDS)、仮想化環境などの様々な企業向けアプリケーションおよび関連ワークロードに適したリードインテンシブSSDです。 あらゆる状態において、高い安定性能を維持し優れた耐久性と高速性を実現します。

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。

こちら からご覧ください。

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。 システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。 【動作条件】 ・システムディスク以外にデータディスクが一つ以上装備されている必要があります。 ・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。 ・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。 ・バックアップデータは日付別に分類されて保存されます。

GSV-ATRSM-5U8Gは、最新のNVIDIA H200 NVL(141GB)やRTX PRO 6000 Blackwell Max-Qなど、先進的なGPUを最大8基まで搭載可能な5Uラックマウント型GPUサーバーです。生成AI、大規模HPC、VDI、3Dレンダリング、医用イメージングといった高負荷なワークロードに対応するために設計されており、あらゆる次世代計算ニーズに応えます。CPUには、AMDの次世代アーキテクチャ「EPYC 9005/9004シリーズ(Turin)」をデュアルソケットで搭載可能。最大192コア・500W TDPにより、圧倒的な並列処理能力と高効率な計算性能を発揮します。メモリは、DDR5 ECC RDIMM/MRDIMMを最大24スロット・6TBまでサポートし、最大6000MT/sの転送速度に対応。AIトレーニングや大規模シミュレーションに最適な高速・大容量メモリ構成が可能です。※NVIDIA RTX PRO 6000 Blackwell Server Edition を8基搭載される場合は、動作温度環境を27度以下に設定いただく必要があります。詳しくは当社までお問い合わせください。

AMD 第5世代 AMD EPYC CPU 「Turin」 搭載

AMD EPYC™ Turinは、次世代のデータセンターおよびHPC向けに設計された第5世代EPYCプロセッサで、Zen 5アーキテクチャを採用しています。最大192コア/384スレッドという圧倒的な並列処理能力を備え、AI、HPC、仮想化、クラウド、データ分析などの高負荷ワークロードに最適です。最新のDDR5メモリとPCIe 5.0をサポートし、広帯域かつ低レイテンシのデータ転送を実現。優れた電力効率とセキュリティ機能を兼ね備え、次世代インフラの中核を担う高性能CPUです。

最新の NVIDIA Blackwell世代GPUや、Hopper世代 GPU H200 を最大8枚搭載可能

GSV-ATRSM-5U8Gは、NVIDIAの最新GPUであるRTX 6000 Blackwell Max-Q(Blackwellアーキテクチャ)をはじめ、Hopper世代のH200、Ada世代のRTX 6000 Adaなどに対応した高性能GPUサーバーです。AI推論や生成AI、HPC、3Dレンダリングといった多様なワークロードに最適な性能を提供します。特にBlackwell Max-QはFP8演算や高度なTransformer処理を省電力で実現し、高効率かつ高密度なAI環境を構築可能。第6世代Intel® Xeon® Scalableプロセッサー(Granite Rapids)との組み合わせにより、柔軟かつ拡張性の高いシステム構成が可能です。

エンタープライズ NVMe SSD

GSVシリーズに搭載されているNVMe SSDはビジネスインテリジェンス(BI)、オンライントランザクション処理(OLTP)、ソフトウェア・デファインド・ストレージ(SDS)、仮想化環境などの様々な企業向けアプリケーションおよび関連ワークロードに適したリードインテンシブSSDです。 あらゆる状態において、高い安定性能を維持し優れた耐久性と高速性を実現します。

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。 こちら からご覧ください。

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する

コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。

システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。

【動作条件】

・システムディスク以外にデータディスクが一つ以上装備されている必要があります。

・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。

・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。

・バックアップデータは日付別に分類されて保存されます。

GSV-ATRSM-5U8Gは、最新のNVIDIA H200 NVL(141GB)やRTX PRO 6000 Blackwell Max-Qなど、先進的なGPUを最大8基まで搭載可能な5Uラックマウント型GPUサーバーです。生成AI、大規模HPC、VDI、3Dレンダリング、医用イメージングといった高負荷なワークロードに対応するために設計されており、あらゆる次世代計算ニーズに応えます。CPUには、AMDの次世代アーキテクチャ「EPYC 9005/9004シリーズ(Turin)」をデュアルソケットで搭載可能。最大192コア・500W TDPにより、圧倒的な並列処理能力と高効率な計算性能を発揮します。メモリは、DDR5 ECC RDIMM/MRDIMMを最大24スロット・6TBまでサポートし、最大6000MT/sの転送速度に対応。AIトレーニングや大規模シミュレーションに最適な高速・大容量メモリ構成が可能です。※NVIDIA RTX PRO 6000 Blackwell Server Edition を8基搭載される場合は、動作温度環境を27度以下に設定いただく必要があります。詳しくは当社までお問い合わせください。

AMD 第5世代 AMD EPYC CPU 「Turin」 搭載

AMD EPYC™ Turinは、次世代のデータセンターおよびHPC向けに設計された第5世代EPYCプロセッサで、Zen 5アーキテクチャを採用しています。最大192コア/384スレッドという圧倒的な並列処理能力を備え、AI、HPC、仮想化、クラウド、データ分析などの高負荷ワークロードに最適です。最新のDDR5メモリとPCIe 5.0をサポートし、広帯域かつ低レイテンシのデータ転送を実現。優れた電力効率とセキュリティ機能を兼ね備え、次世代インフラの中核を担う高性能CPUです。

最新の NVIDIA Blackwell世代GPUや、Hopper世代 GPU H200 を最大8枚搭載可能

GSV-ATRSM-5U8Gは、NVIDIAの最新GPUであるRTX 6000 Blackwell Max-Q(Blackwellアーキテクチャ)をはじめ、Hopper世代のH200、Ada世代のRTX 6000 Adaなどに対応した高性能GPUサーバーです。AI推論や生成AI、HPC、3Dレンダリングといった多様なワークロードに最適な性能を提供します。特にBlackwell Max-QはFP8演算や高度なTransformer処理を省電力で実現し、高効率かつ高密度なAI環境を構築可能。第6世代Intel® Xeon® Scalableプロセッサー(Granite Rapids)との組み合わせにより、柔軟かつ拡張性の高いシステム構成が可能です。

エンタープライズ NVMe SSD

GSVシリーズに搭載されているNVMe SSDはビジネスインテリジェンス(BI)、オンライントランザクション処理(OLTP)、ソフトウェア・デファインド・ストレージ(SDS)、仮想化環境などの様々な企業向けアプリケーションおよび関連ワークロードに適したリードインテンシブSSDです。 あらゆる状態において、高い安定性能を維持し優れた耐久性と高速性を実現します。

DeepLearning開発環境「G-Suite」

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。 こちら からご覧ください。

大切なシステムを丸ごと守る、安心の完全バックアップIntegrated Backup搭載

GDEP Advance Integrated Backup(以下 Integrated Backup)はジーデップ・アドバンスが提供する

コンピュータのシステム領域を完全バックアップするためのユーティリティツールです。

システムディスクのパーティション、ファイルシステムフォーマット、データ内容をすべて記録することが可能で、日付やコメントをつけてバックアップ内容を管理できます。ブートディスク消失時の復旧や、過去にバックアップしたの状態への復帰などが容易に行えます。

【動作条件】

・システムディスク以外にデータディスクが一つ以上装備されている必要があります。

・バックアップイメージはシステムディスク以外のディスクに独立して組み込まれます。

・OSをシャットダウンさせたうえで、バックアップが入っているディスクからブートさせます。

・バックアップデータは日付別に分類されて保存されます。

GSV-ATRSM-5U8Gは、最新のNVIDIA H200 NVL(141GB)やRTX PRO 6000 Blackwell Max-Qなど、先進的なGPUを最大8基まで搭載可能な5Uラックマウント型GPUサーバーです。生成AI、大規模HPC、VDI、3Dレンダリング、医用イメージングといった高負荷なワークロードに対応するために設計されており、あらゆる次世代計算ニーズに応えます。CPUには、AMDの次世代アーキテクチャ「EPYC 9005/9004シリーズ(Turin)」をデュアルソケットで搭載可能。最大192コア・500W TDPにより、圧倒的な並列処理能力と高効率な計算性能を発揮します。メモリは、DDR5 ECC RDIMM/MRDIMMを最大24スロット・6TBまでサポートし、最大6000MT/sの転送速度に対応。AIトレーニングや大規模シミュレーションに最適な高速・大容量メモリ構成が可能です。※NVIDIA RTX PRO 6000 Blackwell Server Edition を8基搭載される場合は、動作温度環境を27度以下に設定いただく必要があります。詳しくは当社までお問い合わせください。

AMD 第5世代 AMD EPYC CPU 「Turin」 搭載